¿Qué es y para qué sirve la virtualización?

La virtualización es una tecnología que permite crear servicios de TI útiles, con recursos que están tradicionalmente limitados al hardware. Gracias a que distribuye las funciones de una máquina física entre varios usuarios o entornos, posibilita el uso de toda la capacidad de la máquina.

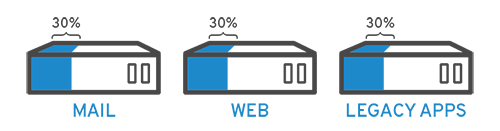

En términos prácticos, imagínese que tiene tres servidores físicos, cada uno con propósitos específicos. Uno es un servidor de correo, otro es un servidor web y el tercero ejecuta aplicaciones heredadas internas. Se utiliza alrededor del 30 % de la capacidad de cada servidor, es decir, solo una parte de su potencial. Pero como las aplicaciones heredadas siguen siendo importantes para sus operaciones internas, tiene que conservarlas junto con el tercer servidor que las aloja, ¿cierto?

Normalmente, la respuesta sería que sí. Por lo general, era más fácil y confiable ejecutar tareas individuales en cada servidor (es decir, un servidor, un sistema operativo y una tarea), ya que no era sencillo asignarle varias. Sin embargo, la virtualización permite dividir el servidor de correo en otros dos únicos que pueden ocuparse de tareas independientes, para poder trasladar las aplicaciones heredadas. Se utiliza el mismo hardware, pero de manera más eficiente.

Si pensamos en la seguridad, es posible volver a dividir el primer servidor para que gestione otra tarea y aumentar su uso de un 30 % a un 60 %, y luego a un 90 %. Una vez que lo logra, los servidores que quedan vacíos se pueden reutilizar para otras tareas o retirarse todos juntos para reducir los costos de refrigeración y mantenimiento.

Historia de la virtualización

Aunque la virtualización data de la década de los sesenta, comenzó a adoptarse más ampliamente a principios del año 2000. Las tecnologías que posibilitaron la virtualización, como los hipervisores, se desarrollaron hace muchas décadas para permitir que varios usuarios accedieran simultáneamente a computadoras que realizaban procesamiento por lotes. El procesamiento por lotes era un tipo de informática popular en el ámbito empresarial que ejecutaba tareas rutinarias miles de veces y muy rápidamente (como las nóminas).

Aunque durante las décadas posteriores se volvieron populares otras soluciones que abordaban el problema de tener una gran cantidad de usuarios y una sola máquina, no ocurrió lo mismo con la virtualización. Una de esas alternativas era el tiempo compartido, que consistía en aislar a los usuarios dentro de los sistemas operativos. Casualmente este sistema fue el precursor de otros como UNIX, en el cual se basó Linux®. Mientras tanto, la virtualización siguió sin adoptarse ampliamente y se mantuvo como una tecnología muy específica.

Ahora bien, avancemos a la década de los noventa. La mayoría de las empresas tenía servidores físicos y pilas de TI de un solo proveedor, por lo cual las aplicaciones heredadas no podían ejecutarse en sistemas de hardware de otro proveedor. A medida que las empresas actualizaban sus entornos de TI con servidores básicos, sistemas operativos y aplicaciones menos costosos y de diferentes proveedores, el hardware físico se usaba de manera insuficiente y cada servidor podía ejecutar solo una tarea específica del proveedor.

Fue en este momento que la virtualización cobró gran protagonismo. Resultó ser la solución natural para dos problemas: las empresas podían dividir los servidores y ejecutar aplicaciones heredadas en varios tipos y versiones de sistemas operativos. Los servidores se empezaron a utilizar más eficientemente (o quedaron directamente en desuso) y, en consecuencia, se redujeron los costos relacionados con las compras, la instalación, la refrigeración y el mantenimiento.

La adopción generalizada de la virtualización ayudó a reducir la dependencia de un solo proveedor y constituyó la base del cloud computing. Actualmente, su uso se ha expandido tanto en las empresas que a menudo se necesita un software de gestión de virtualización especializado para realizar el seguimiento.

¿Cómo funciona la virtualización?

¿Qué es un hipervisor?

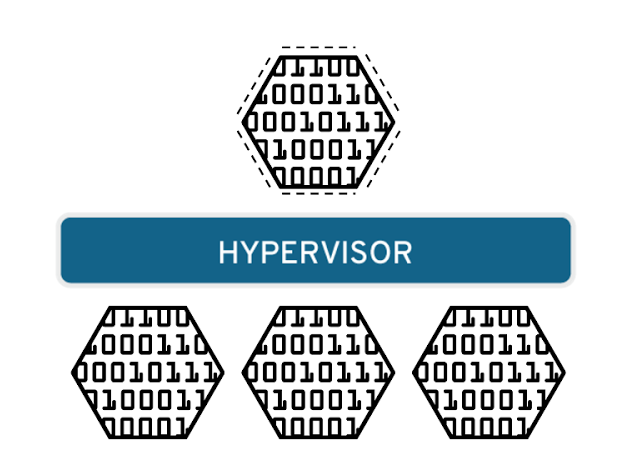

El software denominado hipervisor separa los recursos físicos de los entornos virtuales que los necesitan. Los hipervisores pueden controlar un sistema operativo (como una computadora portátil) o instalarse directamente en el hardware (como un servidor), que es la forma en que la mayoría de las empresas implementan la virtualización. Los hipervisores toman los recursos físicos y los dividen de manera tal que los entornos virtuales puedan usarlos.

Entornos virtuales y máquinas virtuales

Los recursos se dividen según las necesidades, desde el entorno físico hasta los numerosos entornos virtuales. Los usuarios interactúan con la informática y la ponen en funcionamiento dentro del entorno virtual (generalmente denominado máquina guest o máquina virtual). La máquina virtual funciona como un archivo de datos único; por eso, tal como ocurre con cualquier archivo digital, es posible trasladarla de una computadora a otra, abrirla en cualquiera de ellas, y tener la tranquilidad de que funcionará de la misma forma.

Cuando el entorno virtual se está ejecutando, y un usuario o programa emite una instrucción que requiere recursos adicionales del entorno físico, el hipervisor transmite la solicitud al sistema físico y almacena los cambios en la caché. Todo esto sucede prácticamente a la misma velocidad que habría si este proceso se realizara dentro de la máquina física (en especial, si la solicitud se envía a través de un hipervisor open source diseñado a partir de la máquina virtual basada en el kernel [KVM]).

Tipos de virtualización

Virtualización de los datos

Los datos que se encuentran distribuidos en varias ubicaciones pueden consolidarse en una sola fuente. La virtualización de los datos posibilita que las empresas los traten como si fueran un suministro dinámico, ya que proporciona funciones de procesamiento que permiten reunir datos de varias fuentes, incorporar fuentes nuevas fácilmente y transformar los datos según las necesidades de los usuarios. Las herramientas que forman parte de este proceso interactúan con varias fuentes de datos y permiten tratarlas como si fueran solo una. Gracias a ello, cualquier aplicación o usuario puede obtener los datos que necesita, de la manera que los requiere en el momento justo.

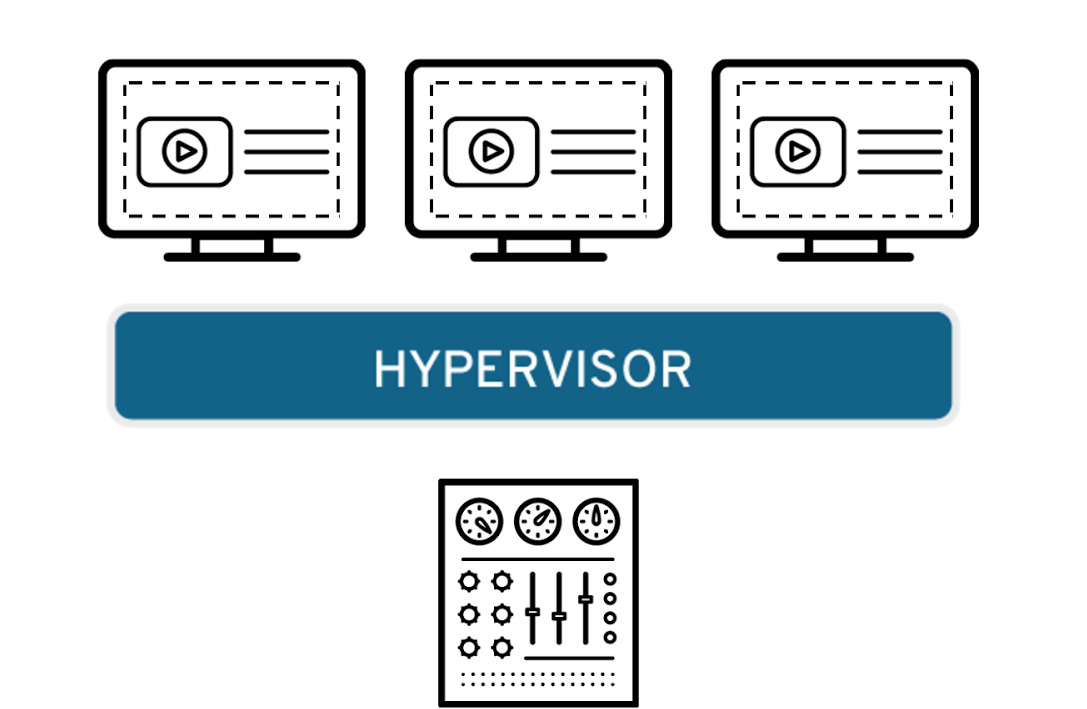

Virtualización de escritorios

La virtualización de escritorios suele confundirse con la virtualización de los sistemas operativos, la cual permite implementar muchos de estos en una sola máquina. Sin embargo, la primera posibilita que un administrador central o una herramienta de administración automatizada implementen entornos simulados de escritorio en cientos de máquinas físicas al mismo tiempo. A diferencia de los entornos de escritorio tradicionales que se instalan, configuran y actualizan físicamente en cada máquina, la virtualización de escritorios permite que los administradores realicen múltiples configuraciones, actualizaciones y controles de seguridad en todos los escritorios virtuales.

Virtualización de los servidores

Los servidores son computadoras diseñadas para procesar un gran volumen de tareas específicas de forma muy efectiva para que otras computadoras (portátiles o de escritorio) puedan ejecutar otros procesos. La virtualización de un servidor, que implica dividirlo para que sus elementos puedan utilizarse para realizar varias tareas, permite ejecutar más funciones específicas.

Virtualización de los sistemas operativos

Los sistemas operativos se virtualizan en el kernel, es decir, en sus administradores centrales de tareas. Es una forma útil de ejecutar los entornos de Linux y Windows de manera paralela. Las empresas también pueden insertar sistemas operativos virtuales en las computadoras, lo cual:

- Reduce los grandes gastos en sistemas de hardware, ya que las computadoras no requieren funciones tan inmediatas.

- Aumenta la seguridad porque todas las instancias virtuales se pueden supervisar y aislar.

- Limita el tiempo que se destina a los servicios de TI, como las actualizaciones de software.

Virtualización de las funciones de red

La virtualización de las funciones de red (NFV) separa las funciones clave de una red (como los servicios de directorio, el uso compartido de archivos y la configuración de IP) para distribuirlas entre los entornos. Cuando las funciones del software se independizan de las máquinas físicas donde se alojaban, las funciones específicas pueden empaquetarse en una nueva red y asignarse a un entorno. La virtualización de redes, que se utiliza con frecuencia en el sector de las telecomunicaciones, reduce la cantidad de elementos físicos (como conmutadores, enrutadores, servidores, cables y centrales) que se necesitan para crear varias redes independientes.

Beneficios de trasladar su infraestructura virtual a Red Hat

Porque una decisión de este tipo no solo implica la infraestructura misma, sino también la capacidad (o falta de ella) de la infraestructura para respaldar las tecnologías que dependen de ella. El hecho de establecer un contrato con un proveedor que resulta cada vez más costoso le impide invertir en tecnologías modernas, como las nubes, los contenedores y los sistemas de automatización.

Nuestras tecnologías de virtualización open source no están vinculadas a acuerdos de licencias empresariales cada vez más costosos; por el contrario, les ofrecemos a todas las personas el acceso completo al mismo código fuente en el que confían más del 90 % de las empresas de la lista Fortune 500*. Gracias a ello, nada le impide adoptar un enfoque ágil, implementar una nube híbrida o hacer uso de las tecnologías de automatización.

* Datos de los clientes de Red Hat y de la lista Fortune 500, junio de 2018