长期以来,红帽企业 Linux (RHEL) 系统管理员和开发人员一直依赖于一套特定的工具,并结合多年积累的直觉和经验来诊断问题。但随着环境变得越来越复杂,有效破译日志和解决问题所需的认知负荷也在增加。

今天,我们很高兴地宣布推出适用于 RHEL 的新模型上下文协议 (MCP) 服务器的开发人员预览版。这款新的 MCP 服务器旨在弥合 RHEL 和大型语言模型 (LLM) 之间的差距,开启更智能故障排除的新时代。

什么是 RHEL 的 MCP 服务器?

MCP 是一项允许 AI 模型与外部数据和系统交互的开放标准,最初由 Anthropic 发布,于 2025年12月捐赠给 Linux 基金会的代理式 AI 基金会。RHEL 的新 MCP 服务器现已提供开发人员预览,并使用此协议从支持 MCP 协议的 AI 应用(如 Claude Desktop 或 goose)提供对 RHEL 的直接上下文感知访问。

我们之前曾发布过适用于 红帽 Lightspeed 和 红帽 Satellite 的 MCP 服务器,它们支持了许多令人兴奋的用例。这款新的 MCP 服务器在这些用例的基础上进行了扩展,专为对 RHEL 系统进行深入故障排除而构建。

实现更智能的故障排除

通过新的 MCP 服务器将 LLM 连接到 RHEL,可实现以下用例:

- 智能日志分析:筛选日志数据非常繁琐。MCP 服务器允许 LLM 提取和分析 RHEL 系统日志。此功能支持 AI 驱动的根本原因分析和异常检测,帮助您将原始日志数据转化为可执行的情报。

- 性能分析:MCP 服务器可以访问有关 CPU 数量、负载平均值、内存信息以及运行中进程的 CPU 和内存使用情况的信息。这使 LLM 系统能够分析系统的当前状态,识别潜在的性能瓶颈,并提出其他与性能相关的建议。

为了帮助您以更安全的方式探索这些新功能,此开发人员预览版重点介绍只读 MCP 支持。MCP 服务器使 LLM 能够进行检查和推荐,并利用标准 SSH 密钥进行身份验证。它还可以配置日志文件访问和日志级别访问的允许列表。MCP 服务器不允许对您的 RHEL 系统进行开放式 shell 访问,因为 MCP 服务器运行的命令已经过预先审查。

示例用例

在这些示例中,我使用 goose AI 代理和 MCP 服务器来处理我的一个名为 rhel10.example.com 的 RHEL 10 系统。Goose 支持许多 LLM 提供商,包括在线托管提供商和本地托管提供商。我使用的是本地托管模型。

我已在 Fedora workstation 上安装了 goose 和 MCP 服务器,并使用 rhel10.example.com 设置了 SSH 密钥身份验证。

首先,我将使用提示符请求 LLM 帮助我检查 rhel10.example.com 系统的运行状况:

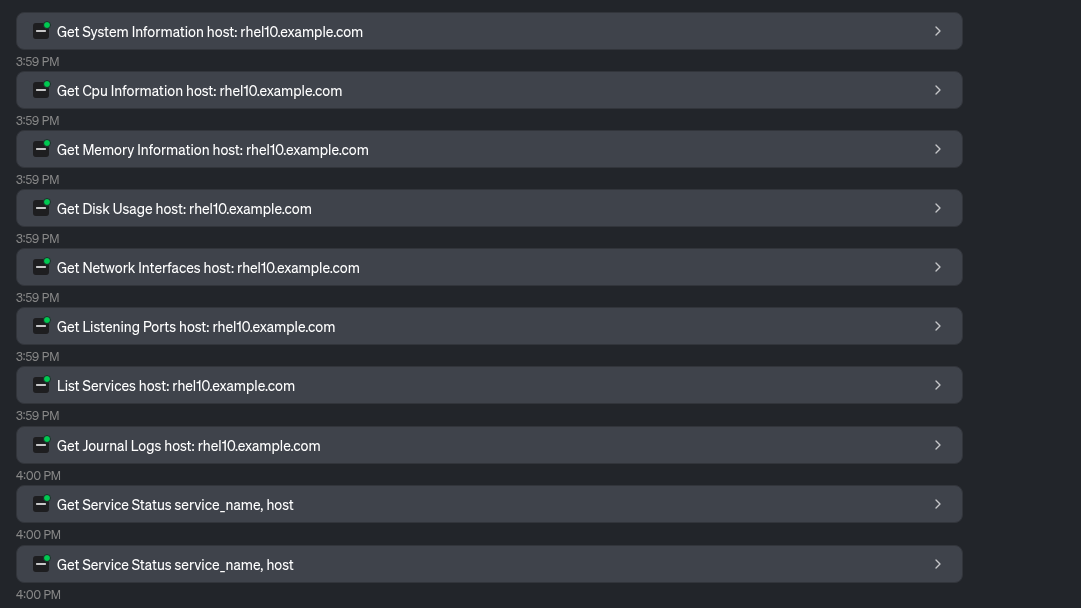

LLM 利用 MCP 服务器提供的许多工具来收集系统信息:

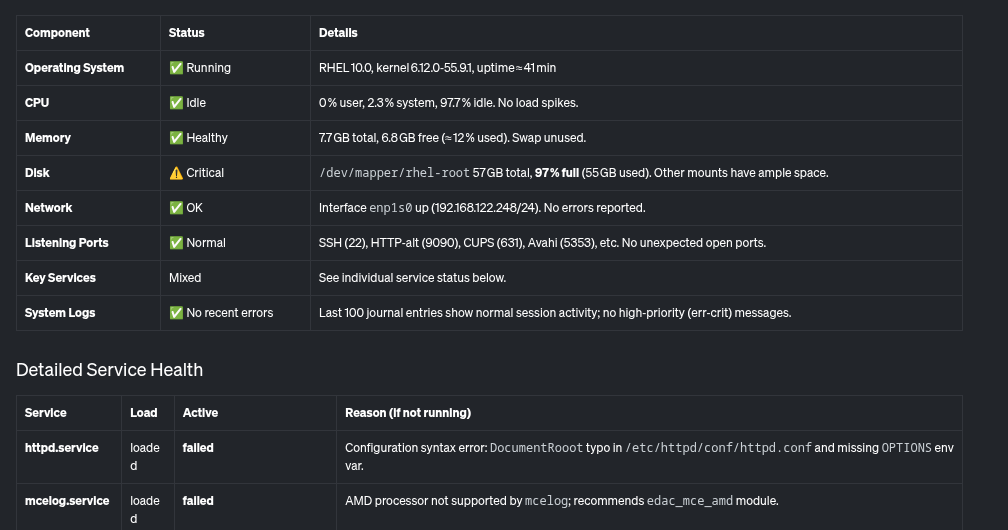

基于此,大语言模型提供系统及其运行状况的概述,包括此表:

此外,它还提供此摘要,指出需要解决的关键问题,例如几乎已满的根文件系统,以及系统上出现故障的几个服务。

我们来检查一下发现的问题。我将让 LLM 帮助我确定磁盘使用率如此之高的原因:

LLM 使用 MCP 服务器提供的工具来确定使用磁盘空间最多的对象:

据此,LLM 确定 /home/brian/virtual-machines 目录中有一个 25 GB 的文件,并且 /home/brian/.local 目录占用了 24 GB 空间:

最后,我还将请大语言模型帮助解决之前报告为失败的 httpd.service。

LLM 使用 MCP 服务器提供的 Read File 工具:

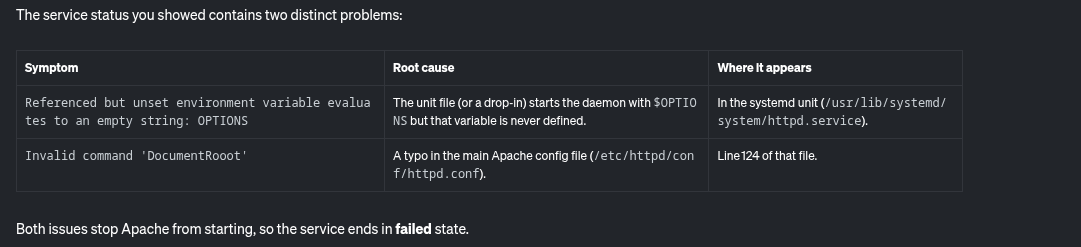

基于此,LLM 报告 httpd.service 失败的潜在原因:

此外,它还提供了一些纠正此问题的分步说明:

借助适用于 RHEL 的 MCP 服务器,我能够轻松识别此系统上与文件系统几乎已满和 httpd 服务故障相关的潜在问题并进行故障排除。

下一步是什么?

虽然我们从只读分析开始,但我们的路线图包括扩展到其他用例。要了解开发流程,请关注我们的上游 GitHub 存储库。我们欢迎上游贡献!我们非常希望收到您的反馈:增强请求、错误报告等。您可以通过 GitHub 或通过 Fedora AI/ML 特别兴趣小组 (SIG) 与团队联系。

准备好体验更智能的故障排除了吗?

适用于 RHEL 的 MCP 服务器现已推出开发人员预览版。连接您的 LLM 客户端应用,了解情境感知 AI 如何改变您管理 RHEL 的方式。如需开始使用,请参阅 红帽文档和上游文档。

关于作者

Brian Smith is a product manager at Red Hat focused on RHEL automation and management. He has been at Red Hat since 2018, previously working with public sector customers as a technical account manager (TAM).

Máirín Duffy is a Red Hat Distinguished Engineer and leads the Red Hat Enterprise Linux Lightspeed Incubation team at Red Hat as a passionate advocate for human-centered AI and open source. A recipient of the O’Reilly Open Source Award, Máirín first joined Red Hat as an intern in 2004 and has spent two decades in open source communities focusing on user experience in order to expand the reach of open source. A sought-after speaker and author, Mo holds 19 patents and authored 6 open source coloring books, including The SELinux Coloring Book.