红帽 OpenShift AI

红帽® OpenShift® AI 是一个平台,用于在混合云环境中大规模管理预测性 AI 模型和生成式人工智能(生成式 AI)模型的生命周期。

什么是红帽 OpenShift AI?

OpenShift AI 采用开源技术构建,能够提供值得信赖且运维一致的功能,助力团队开展实验、部署模型并交付创新应用。

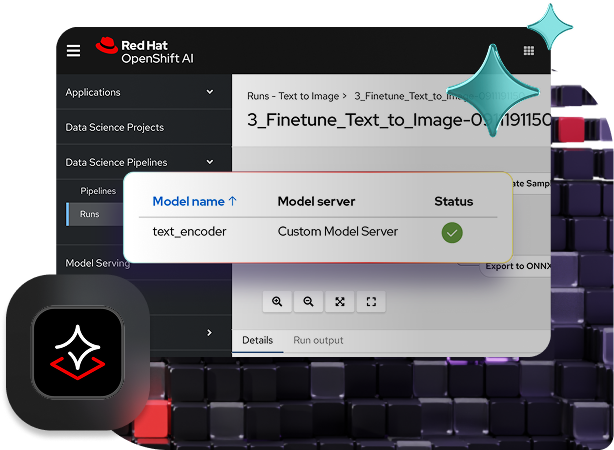

OpenShift AI 支持数据获取和准备、模型训练和微调、模型服务、模型监控及硬件加速。依托由硬件和软件合作伙伴组成的开放式生态系统,OpenShift AI 能够灵活满足特定用例的需求。

加速将依托 AI 的应用投入使用

这款一站式企业就绪型 AI 应用平台集结了红帽 Openshift AI 和红帽 OpenShift 成熟可靠的功能,能够促进团队间展开高效协作。数据科学家、工程师和应用开发人员可以在统一的平台上协同工作,从而提高一致性、安全性和可扩展性。

最新发布的 OpenShift AI 包含一系列精挑细选、经过优化的生产就绪型第三方模型,而且这些模型均已通过红帽 OpenShift AI 验证。有了对这一第三方模型目录的访问权限,您的团队能够更好地控制模型可访问性和可见性,从而满足安全性与政策要求。

此外,OpenShift AI 还借助经优化的 vLLM 框架实现分布式部署,以有效管控推理成本。为了进一步降低运维复杂性,它提供了高级工具来实现部署自动化,并支持自助访问模型、工具和资源。

减少 AI 基础架构管理时间

按需获取高性能模型,从而更轻松地实现自助服务、扩展和部署。 开发人员可省去复杂操作,同时保持控制权并优化成本。

模型即服务(MaaS)等功能目前处于开发人员预览阶段。该功能以 API 端点的形式提供 AI 访问途径,助力大规模实现私密且高效的 AI 部署。

经过测试且受支持的 AI/ML 工具

红帽会对 AI/ML 工具及模型服务进行测试、集成并提供支持,而无需您自行操作。OpenShift AI 借鉴了红帽 Open Data Hub 社区项目及 Kubeflow 等开源项目多年的孵化经验。

我们凭借丰富的经验和开源专业知识,提供了一个支持生成式 AI 的基础平台,让客户在制定生成式 AI 策略时拥有更多选择与更大的信心。

跨混合云的灵活性

红帽 OpenShift AI 既可以作为自助管理软件使用,也可作为 OpenShift 上的全托管云服务提供;借助这个既安全又灵活的平台,您可以选择在任何位置开发和部署模型,无论是在本地、公共云中还是在边缘。

适用于红帽 OpenShift AI 的 MCP 服务器

探索我们精挑细选的 MCP 服务器集合,这些来自技术合作伙伴的服务器可与红帽 OpenShift AI 集成。

模型上下文协议(MCP)是一种开源协议,可实现 AI 应用与外部服务之间的双向连接和标准化通信。

现在,您可利用这些 MCP 服务器,将企业工具和资源集成到 AI 应用和代理式工作流中。

利用 vLLM 进行优化,以实现快速且经济高效的大规模推理。

红帽 AI 推理服务器是红帽 AI 平台的一部分。它既可以作为独立产品使用,同时也已包含在红帽企业 Linux® AI 和红帽 OpenShift® AI 中。

能够满足您需求并按您意愿运行的 AI。

生成式 AI

制作文本和软件代码等新内容。

借助红帽 AI,您可以更快地运行您选择的生成式 AI 模型,同时减少资源消耗并降低推理成本。

预测性 AI

应用模式并预测未来结果。

借助红帽 AI,企业组织能够构建、训练、部署和监控预测模型,同时在混合云环境中始终保持一致性。

运营化 AI

创建支持大规模维护和部署 AI 的系统。

借助红帽 AI,在节省资源并确保遵守隐私法规的同时,管理与监控支持 AI 的应用的生命周期。

代理式 AI

构建在有限监督下执行复杂任务的工作流。

红帽 AI 为在现有应用中构建、管理和部署代理式 AI 工作流提供了灵活的方法和稳定的基础。

借助模型工作台实现协同工作

AI 中心与生成式 AI 工作室让平台工程师和 AI 工程师能够协同工作,从而更快地将生成式 AI 模型投入使用。

AI 中心支持平台工程师管理 LLM 与集中式 AI 工作负载,同时获取来自第三方模型验证的性能洞察分析。生成式 AI 工作室为 AI 工程师提供一个实操环境,可通过 Playground 与模型进行交互,并快速构建生成式 AI 应用原型。在将模型集成至生命周期流程之前,工程师可借助沙箱环境来测试聊天及检索增强生成(RAG)流程,从而验证模型的适用性。

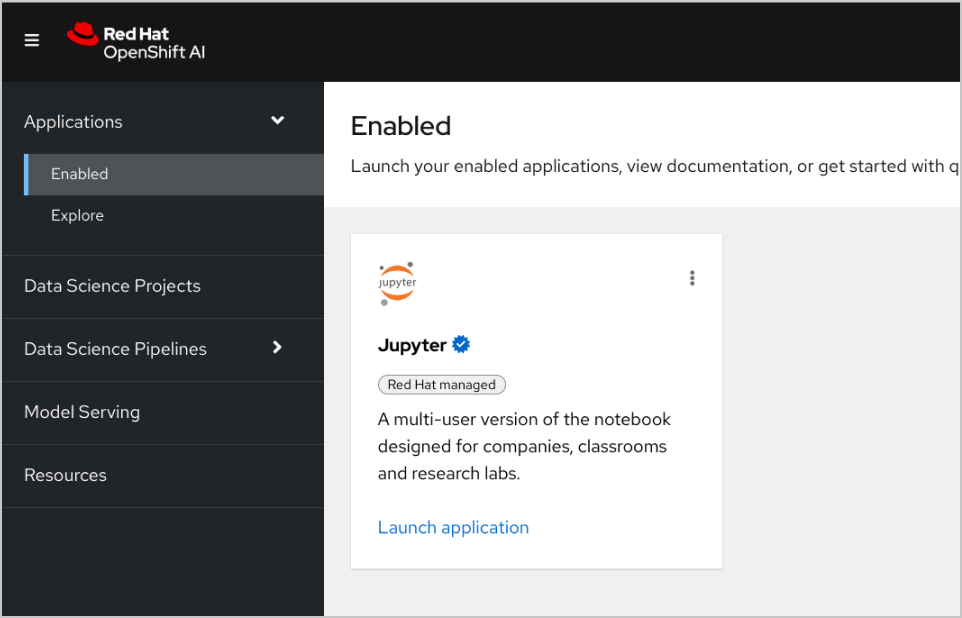

此外,数据科学家可以访问预构建或定制的集群镜像,使用偏好的 IDE 与框架来开展模型相关工作。红帽 OpenShift AI 会跟踪对 Jupyter、PyTorch、Kubeflow 及其他开源 AI 技术进行的更改。

借助红帽 OpenShift AI 实现模型服务与安全防护的规模化扩展

可通过经优化的 vLLM 版本(或您选择的其他模型服务器)来部署模型,将其集成到在本地、公共云或边缘运行的 AI 赋能应用。还可以基于对源 notebook 的更改来重新构建、重新部署和监控这些模型。

模型幻觉与偏差问题可能会损害模型的完整性,还会增加其规模化应用的难度。为帮助维护模型公平性、安全性和可扩展性,OpenShift AI 允许数据从业人员监控模型输出与训练数据之间的一致性。

偏差检测工具可以实时监控模型推理所使用的实际数据是否偏离原始训练数据。 此外,内置的 AI 防护机制可以保护模型输入和输出免受有害信息的影响,如辱骂性和亵渎性言论、个人数据或特定领域限制。

解决方案模式

使用红帽技术和 NVIDIA AI Enterprise 构建的 AI 应用

创建 RAG 应用

红帽 OpenShift AI 是一个用于构建数据科学项目并为依托 AI 的应用提供服务的平台。您可以集成支持 检索增强生成(RAG)所需的所有工具,这是一种从自己的参考文档中获取 AI 答案的方法。将 OpenShift AI 与 NVIDIA AI Enterprise 关联后,您可以尝试各种 大语言模型(LLM),以找到适用于您应用的最佳模型。

构建文档处理管道

要使用 RAG,首先需要将文档导入到一个向量数据库中。在示例应用中,我们将一组产品文档嵌入到 Redis 数据库中。由于这些文档经常更改,我们可以为此过程创建一个管道并定期运行,以确保始终拥有最新版本的文档。

浏览 LLM 目录

NVIDIA AI Enterprise 支持访问不同 LLM 的目录,因此您可以尝试不同的选择,并选取能够提供最佳效果的模型。这些模型托管在 NVIDIA API 目录中。设置 API 令牌后,您就可以直接从 OpenShift AI 使用 NVIDIA NIM 模型服务平台来部署模型。

选择合适的模型

在测试不同的 LLM 时,您可以让用户对每个生成的响应进行评分。您还可以设置一个 Grafana 监控面板,用于比较各个模型的评分、延迟和响应时间。然后,您就可以根据这些数据来选择最适合在生产环境中使用的 LLM。

2025 年红帽全球峰会和 AnsibleFest 大会 AI 客户案例集锦

土耳其航空公司通过实现企业范围内的数据访问,将部署速度提高了一倍。

JCCM 利用 AI 技术,改进了该地区的环境影响评估(EIA)流程。

Denizbank 将上市时间从数天缩短到数分钟。

Hitachi 借助红帽 OpenShift AI 在整个业务范围内实施了 AI。

如何试用红帽 OpenShift AI

开发人员沙盒

适合想要尝试在灵活的预配置环境中构建 AI 赋能应用的开发人员和数据科学家。

60 天试用

企业组织准备好评估 OpenShift AI 的全部功能后,可通过为期 60 天的产品试用体验这些功能。需要用到现有的红帽 OpenShift 集群。