概述

人工智能(AI)平台集机器学习模型的开发、训练和运行技术于一身,通常包括自动化功能、机器学习运维(MLOps)、预测性数据分析等。我们可以将其看作一个工作台,上面摆放着您要使用的所有工具,为您的构建和优化工作奠定了稳定的基础。

如今,随着 AI 技术的突飞猛进,选择 AI 平台和上手使用面临的选择越来越多。以下是需要注意的事项以及首要考虑因素。

AI 平台的类型

任何企业组织面临的第一个 AI 平台决策,便是要么购买预先配置的平台,要么在企业组织内部构建定制型平台。

购买 AI 平台

如果您希望快速部署 AI 应用、模型和算法,那购买全面预配置的 AI 平台是最佳选择。这类平台随附的工具、语言存储库和 API 均已经过测试,有一定的安全性和性能保障。一些供应商还提供预训练的基础模型和生成式 AI 模型。您还可以利用它们的技术支持和上手资源,将这些模型顺利融入您的现有环境和工作流。

热门的云提供商如今纷纷在其产品组合中加入了 AI 平台,其中包括 Amazon Web Services(AWS)Sagemaker、Google Cloud AI Platform、Microsoft Azure AI Platform 以及 IBM 的 watsonx.ai™ AI 开发平台。在许多情况下,AI 平台提供商还提供可与其他 AI 解决方案结合使用和集成的独立 AI 工具。

构建 AI 平台

为了满足特定使用场景或高级隐私的需求,一些企业组织需要全面定制和管理自己的 AI 平台。例如,Uber 开发了一款定制型 AI 平台,该平台可利用自然语言处理(NLP)和计算机视觉等技术来提升其 GPS 和碰撞检测功能。Syapse 是一家以数据为中心的医疗公司,该公司开发了一个依托 AI 技术的数据平台 Syapse Raydar®,该平台可将肿瘤数据转化为可作为行动依据的洞见。

构建自己的 AI 平台,您可以全面掌控环境,且可以根据您的业务的特定需求进行迭代。不过,要想构建一个平台并使其正常运行,需要的前期工作较多,并且无法将维护、支持和管理工作外包。

选择开源

开源社区正在不断推动人工智能和机器学习技术的进步。如果选择开源软件解决方案作为 AI 计划的基础平台,意味着您可以依靠由同行和从业人员组成的社区,他们会不断优化您最常用的框架和工具。许多企业组织都选择从开源工具着手,并在此基础上继续构建。Tensorflow 和 PyTorch 都是开源平台,可为 AI 应用的开发提供库和框架。

红帽资源

选择 AI 平台时要关注的能力

MLOps

机器学习运维(MLOps)是一组工作流实践,旨在简化 ML 模型的部署和维护过程。AI 平台应支持模型的训练、服务和监控等 MLOps 阶段。

大语言模型运维(LLMOps)是 MLOps 的一个子集,重点关注对生产环境中的大语言模型进行运维管理的一系列实践方法、技术和工具。LLM 可以执行文本生成、内容总结、信息分类等任务,但是会占用 GPU 的大量计算资源,这意味着您的 AI 平台需要足以容纳和支持 LLM 的输入和输出。

生成式 AI

生成式 AI 依靠基于大型数据集训练的神经网络及深度学习模型来创建新内容。在经过充分的训练后,该模型能够将从训练中学到的知识应用到实际场景中,这被称为 AI 推理。

生成式 AI 涵盖了许多最终用户与人工智能相关联的功能,例如生成文本和图片、数据增强、对话式 AI(例如聊天机器人)等。一定要注意的是,您选择的 AI 平台在支持生成式 AI 功能方面应达到速度和准确性要求。

可扩展性

可扩展的模型才是成功的模型。为了进行扩展,数据科学团队需要一个集中式解决方案,以便构建和部署 AI 模型、进行实验和微调以及与其他团队合作。这些都需要大量的数据以及计算能力,最重要的是,要有一个能够满足这些需求的平台。

模型取得成功后,您会希望在不同的环境中复制这些模型:本地环境、公共云平台以及边缘环境。可扩展的解决方案应支持在上述所有环境中进行部署。

自动化

当企业组织要投入生产的模型从少数几个发展到十几个或更多时,您就需要考虑自动化问题。数据科学管道的自动化可让您将最成功的流程转化为可重复的操作。这不仅可以加快您的工作流,还能带来更好且可预测性更高的用户体验,并提升可扩展性。还可以减少重复性任务,让数据科学家和工程师腾出时间进行创新、迭代和优化。

工具和集成功能

开发人员和数据科学家利用工具和集成功能来构建应用和模型并高效地进行部署。AI 平台需要能够支持您的团队已在使用的工具、语言和存储库,且可与您的整个技术堆栈和合作伙伴解决方案集成。

安全与合规

您应针对 AI 平台建立强大的安全实践来降低风险并保护数据。在培训、开发等日常运维中,扫描通用漏洞披露(CVE)并通过访问管理、网络分段和加密技术为应用和数据建立运维保护至关重要。

责任和监管

AI 平台还必须允许您以符合道德标准且合规的方式使用和监控数据。为了保护企业组织的数据和用户数据,选择一个对可见性、跟踪和风险管理策略的支持贯穿整个 ML 生命周期的平台非常重要。该平台还必须符合企业组织的现有数据合规性和安全性标准。

支持

预配置的端到端 AI 平台最重要的优势之一是其附带的技术支持。借助跨部署环境对错误的持续跟踪和修复,您的模型的执行效果会更好。一些 AI 平台提供商还通过提供上手和培训资源来帮助您的团队快速开始使用。如果企业组织选择利用开源工具自行构建平台,则建议考虑选择那些支持机器学习功能集和基础架构的供应商。

AI 平台使用场景

电信行业

在电信行业,全面的 AI 服务可以解决各种挑战,例如优化网络性能以及提高电信产品和服务的质量。其应用领域包括提高服务质量、增强视听效果以及防止客户流失。

医疗卫生

强大的 AI 平台可为医疗卫生环境带来变革性的助益,例如更快的诊断速度、临床研究的进步以及更多的患者服务。这些都有助于医生及其他医疗从业者提供更准确的诊断和治疗方案,从而改善患者的治疗效果。

制造业

依托机器学习技术的智能自动化正在改变制造业的整个供应链。工业机器人技术和预测性分析技术正在减轻重复性工作带来的负担,还可实时实施更有效的工作流。

红帽能如何提供帮助

就 AI 平台而言,我们会优先大规模构建灵活且值得信赖的 AI 解决方案。

红帽® AI 是我们专门针对企业组织需求而构建的 AI 产品组合,它筑基于深受客户信赖的红帽解决方案。

红帽 AI 可以为企业组织提供帮助:

- 快速采用 AI 并进行创新。

- 拆解交付 AI 解决方案的复杂流程。

- 轻松在任何位置部署。

灵活扩展

如果您已准备好进行扩展,我们的红帽 AI 平台将为开发人员提供构建、部署和管理支持 AI 的应用所需的工具。

通过受支持的持续协作,您能够以快速便捷的方式针对企业用例自定义 AI 模型应用。

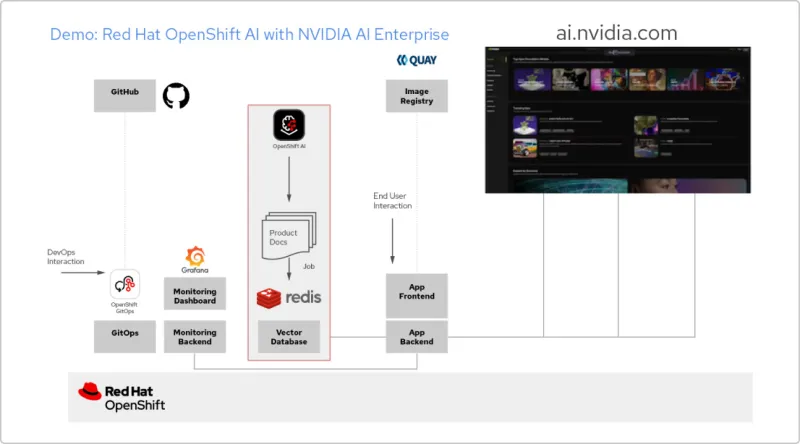

解决方案模式:利用红帽技术和 NVIDIA AI Enterprise 构建 AI 应用

创建 RAG 应用

红帽 OpenShift AI 是一个用于构建数据科学项目并为依托 AI 的应用提供服务的平台。您可以集成支持检索增强生成(RAG)所需的所有工具,这是一种从自己的参考文档中获取 AI 答案的方法。将 OpenShift AI 与 NVIDIA AI Enterprise 关联后,您可以尝试各种大语言模型(LLM),以找到适用于您应用的最佳模型。

构建文档处理管道

要使用 RAG,首先需要将文档导入到一个向量数据库中。在示例应用中,我们将一组产品文档嵌入到 Redis 数据库中。由于这些文档经常更改,我们可以为此过程创建一个管道并定期运行,以确保始终拥有最新版本的文档。

浏览 LLM 目录

NVIDIA AI Enterprise 支持访问不同 LLM 的目录,因此您可以尝试不同的选择,并选取能够提供最佳效果的模型。这些模型托管在 NVIDIA API 目录中。设置 API 令牌后,您就可以直接从 OpenShift AI 使用 NVIDIA NIM 模型服务平台来部署模型。

选择合适的模型

在测试不同的 LLM 时,您可以让用户对每个生成的响应进行评分。您还可以设置一个 Grafana 监控面板,用于比较各个模型的评分、延迟和响应时间。然后,您就可以根据这些数据来选择最适合在生产环境中使用的 LLM。

开启企业 AI 之旅:新手指南

此新手指南介绍了红帽 OpenShift AI 和红帽企业 Linux AI 如何加快您的 AI 采用之旅。