您肩负着将 AI 引入企业组织的重任,但从概念验证到生产就绪型应用,这段旅程往往充满了迷宫般的碎片化工具和复杂集成,尤其是对于代理式 AI 用例而言。真正的挑战不仅在于技术,还在于构建可扩展、可靠且可管理的 AI 策略。

标准化是应对这一挑战的主要要素,主要通过降低复杂性和提高效率来实现。通过在红帽 OpenShift AI 等平台上结合使用模型上下文协议(MCP)和 Llama Stack,您可以为 AI 应用创建统一且可移植的环境。

OpenShift AI 还支持集成您喜欢的任何其他代理式框架和组件,包括 LangChain、LangGraph 和 CrewAI 等工具。借助红帽提供的方法,您能够简化开发流程、优化运维效率,并为您的企业提供所需工具,助力 AI 开发人员和数据科学家等多支团队在可信且一致的环境中,将 AI 愿景转化为现实。

了解智能代理的构建块

要构建具有弹性的 AI 赋能型应用,您需要奠定这样的基础:使智能代理能够访问和使用企业的特定工具和数据。这需要两个关键组件:一是用于公开服务的标准化方式,二是用于与服务交互的统一框架。

这就是代理式 AI 的核心所在,即自主系统能够确定实现目标的最佳行动方案及所需工具。MCP 与 Llama Stack 组合在一起,为这些智能体提供了高效运维的框架。

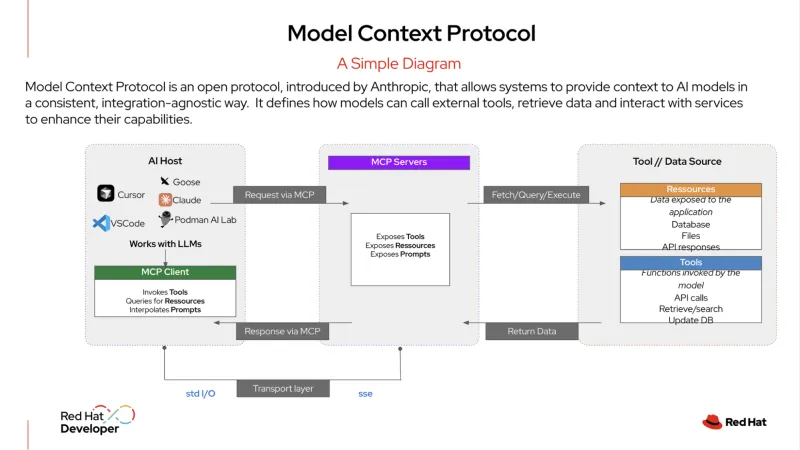

MCP 是一种开放协议,可标准化 AI 系统与外部工具和数据源的集成方式。它被描述为“用于 AI 应用的 USB-C 端口”。正如 USB-C 允许您插入任何兼容设备(显示器、硬盘驱动器或键盘)一样,MCP 服务器以标准化格式公开您企业组织的服务。

然后,AI 代理可以插入到该服务器,以发现和使用可用的工具,无论是数据库、客户关系管理(CRM)系统还是内部 API。该协议为 AI 代理提供了一种与服务连接的结构化方式,使其能够轻松获取执行任务所需的信息。

Llama Stack 是一个开源框架,为构建和部署生成式 AI(生成式人工智能)应用提供统一的 API 驱动型方法。它提供了一致且可移植的方式来抽象化 AI 开发和部署的复杂性,并包含一整套企业级工具,例如面向推理、检索增强生成(RAG)和 AI 代理的 API 等。它还提供了针对安全性、评估和可观测性的内置组件,帮助企业组织创建可靠且可扩展的生产就绪型 AI 应用。

代理式 AI 的实际应用示例

在企业 IT 领域,代理式 AI 可以处理需要动态决策的复杂、多步骤工作流。例如,与简单的、一对一的“请求和响应”模式不同,更先进的代理可充当自主服务台管理器,在最少人工干预的情况下解决问题。

以下示例展示了当用户针对“服务中断”提交工单时,此类代理可能会执行的操作:

- Llama Stack 接收初始工单。系统接收用户报告的服务中断事件,并将其归类为高优先级事件。

- 代理使用 MCP 并制定计划。代理使用 MCP 来识别和发现它有权访问的相关工具,如监控服务、日志分析工具和运行手册自动化系统。利用来自 MCP 的这些上下文信息,代理会制定一个多步骤计划,以调查和解决相关问题。

- 代理使用 MCP 与发现的工具通信,以执行计划。

- 首先使用监控工具来检查相关服务和依赖项的状态。

- 然后,调用日志分析工具来查看相关应用或红帽 OpenShift 容器的最新日志,以搜索错误。

- 一旦发现潜在问题(例如,pod 崩溃),则使用诊断工具来精准识别根本原因,例如网络策略配置错误或磁盘空间耗尽。

- 代理采取纠正措施。根据诊断结果,代理使用 MCP 调用预先批准的修复脚本,以重新启动 Pod 并清理磁盘空间。然后,它会重新检查服务状态,以确认问题已解决。

- 代理传达结果。代理使用内部工具将工单状态更新为“已解决”,包括所采取操作的摘要。然后,它会起草一条消息发送给用户,说明问题并确认服务已恢复正常,整个过程无需任何人工干预。

通过使用 MCP 来编排这些操作,代理能够作为自主且独立的服务台运行,从而减轻 IT 团队的手动工作负担,让他们有时间专注于更具战略意义的计划。

简化的开发和生产方法

Llama Stack 与 MCP 相结合,显著改善了开发人员的体验。您的开发人员无需针对特定的单体式堆栈进行构建,只需通过单个 API 即可使用标准化抽象层。这实现了强大的“内循环”开发方法,开发人能够使用单个 SDK 在本地计算机上构建和测试 AI 应用。

由于 API 是一致的,且服务通过标准化协议发现,开发人员可以确信,他们的应用在部署到企业级平台时将完全以相同方式运行。

在快速发展的 AI 环境中,这种可移植性至关重要。开发者现在可以使用某个模型构建应用,当出现更优或更具成本效益的新模型时,无需重写代码即可实现无缝切换。这可以减少开发时间和工作量,加速创新,并为从开发到生产阶段的过渡提供明确的途径。

实现 AI 工作负载的运维一致性

对于运维团队而言,管理各种 AI 模型和服务,这可能是增加复杂性的主要原因。但是,通过在 OpenShift AI 等平台上运行为您的企业组织量身定制的标准化 AI 堆栈,您可以获得一个集中且一致的环境。

OpenShift AI 提供了一个全面且值得信赖的平台,用于部署 LLM 和提供 LLM 服务,以及运行 RAG 应用所需的数据库。它还允许您的团队利用现有的微服务架构,并顺畅地连接到内部系统。

您的运维团队还可以使用标准的 GitOps 流程来部署和管理这些 AI 应用。这意味着,可以将用于传统云原生应用的相同工作流应用于 AI 工作负载,从而大规模简化管理和维护。它简化了从开发到生产的整个过程,并在混合云环境中提供运维一致性。

通过整合 Llama Stack 和 MCP 等开源技术的强大力量,并支持集成 LangChain、Haystack、LlamaIndex 和 PydanticAI 等其他代理式 AI 框架,红帽 AI 为在整个混合云环境中构建、部署和管理 AI 应用提供了可靠的基础。

了解更多

准备好开始了吗?通过我们的产品试用、咨询服务、培训与认证等,进一步了解红帽 AI。

关于作者

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.