Hoy, Red Hat anunció la disponibilidad de la versión tecnológica preliminar de Red Hat Enterprise Linux AI (RHEL AI), una plataforma de modelos base para desarrollar, probar y ejecutar de manera fluida los mejores modelos de IA generativa Granite con licencia open source para impulsar las aplicaciones empresariales. RHEL AI se basa en el proyecto open source InstructLab y combina los modelos de lenguaje de gran tamaño Granite con licencia open source de IBM Research y las herramientas de alineación de modelos de InstructLab, basadas en la metodología LAB (Large-scale Alignment for chatBots), en una imagen de RHEL de inicio optimizada que simplifica la implementación de servidores.

El principal objetivo de RHEL AI y del proyecto InstructLab es capacitar a los expertos en la materia para que aporten sus conocimientos y habilidades directamente a los modelos de lenguaje de gran tamaño. Esto les permite crear aplicaciones con IA integrada (como chatbots) de manera más eficiente. RHEL AI incluye todo lo necesario al:

- aprovechar la innovación de la comunidad mediante modelos, habilidades y conocimientos open source para el entrenamiento

- proporcionar a los expertos sin experiencia en ciencia de datos un conjunto de herramientas informáticas y un flujo de trabajo intuitivos que les permita realizar tareas de entrenamiento y ajuste

- empaquetar el software y el sistema operativo con facilitación de hardware optimizado para IA

- brindar apoyo a la empresa y protección en materia de propiedad intelectual

Antecedentes

Los modelos de lenguaje de gran tamaño (LLM) y los servicios que se basan en ellos (como GPT y chatGPT) son muy conocidos y cada vez más adoptados por las grandes empresas. Estos modelos suelen ser de código cerrado o tener una licencia personalizada. Recientemente, han comenzado a surgir varios modelos abiertos (como Mistral, Llama, OpenELM). Sin embargo, la apertura de algunos de estos modelos es limitada (por ejemplo: limitaciones en el uso comercial o falta de apertura en cuanto a los datos de entrenamiento y los parámetros de los transformadores, así como otros factores relacionados con la capacidad de reproducción). El factor más importante tal vez sea la ausencia de medios en los que las comunidades puedan colaborar y contribuir a los modelos para mejorarlos.

Hoy en día, los LLM son grandes y de uso general. Red Hat visualiza un mundo de modelos para usos específicos con costos y rendimiento optimizados, donde haya herramientas de MLOps de primera clase al alcance de la mano, en el que la privacidad, la soberanía y la confidencialidad de los datos sean protagonistas.

El proceso de entrenamiento para ajustar los LLM requiere contar con experiencia en ciencia de datos y puede ser costoso, tanto en términos del uso de recursos para el entrenamiento como del costo de los datos de entrenamiento de calidad superior.

Red Hat (junto con IBM y la comunidad open source) pretende cambiar esto. Propone introducir el flujo de trabajo familiar del colaborador de código abierto y los conceptos asociados, como las licencias permisivas (por ejemplo, Apache 2), en los modelos y las herramientas de colaboración abierta que permitan a una comunidad de usuarios crear y sumar aportes a los LLM. Esto también hará posible que un ecosistema de partners ofrezca propuestas y valor que faciliten las extensiones y la incorporación de información protegida por parte de las empresas.

¡Te presentamos Red Hat Enterprise Linux AI!

Red Hat Enterprise Linux AI está formado por cuatro componentes básicos distintos:

1. Modelos Granite abiertos

RHEL AI incluye modelos de lenguaje y código Granite de alto rendimiento y con licencia open source de la comunidad InstructLab, desarrollados en colaboración, con protección y soporte plenos de Red Hat. Estos modelos Granite cuentan con licencia Apache 2 y brindan un acceso transparente a las fuentes de datos y a los pesos del modelo.

Los usuarios pueden crear su propio LLM personalizado al entrenar los modelos base con sus propias habilidades y conocimientos. Pueden elegir si compartir el modelo entrenado y las habilidades y conocimientos adicionales con la comunidad o mantenerlos en privado. En la siguiente sección se incluye más información al respecto.

En la versión preliminar para desarrolladores, los usuarios tienen acceso al modelo (base) Granite 7b en inglés y al correspondiente modelo Granite 7b LAB (se incluye más información acerca de LAB más adelante).

En el futuro, Red Hat Enterprise Linux AI también incluirá otros modelos Granite, entre ellos, la familia de modelos de código Granite. Esté atento a las novedades.

2. Alineación de modelos InstructLab

LAB: Large-Scale Alignment for ChatBots es un método novedoso para la alineación de instrucciones y el ajuste de modelos de lenguaje de gran tamaño con un enfoque guiado por taxonomía que utiliza la generación de datos sintéticos de alta calidad. En términos más simples, permite que los usuarios personalicen un LLM por medio de conocimientos y habilidades específicos del dominio. Luego, InstructLab genera datos sintéticos de alta calidad que se utilizan para entrenar el LLM. Para evitar el olvido, se utiliza un búfer de reproducción. Para más información, puedes consultar la sección 3.3 del artículo científico.

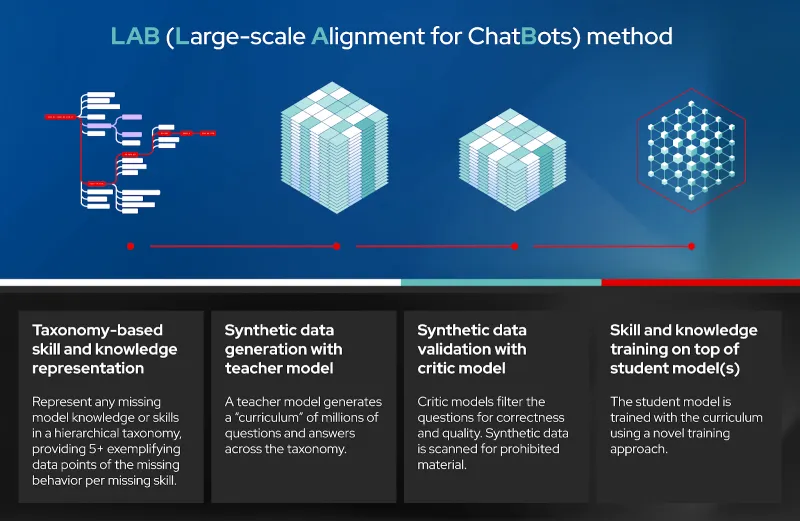

La técnica LAB consta de cuatro pasos distintos (consulta el diagrama):

- Representación de habilidades y conocimientos basada en una taxonomía

- Generación de datos sintéticos (GDS) mediante un modelo maestro

- Validación de datos sintéticos mediante un modelo crítico

- Entrenamiento de habilidades y conocimientos sobre el o los modelos alumno

Referencias:

Método LAB (Large-scale Alignment for ChatBots)

Representación de habilidades y conocimientos basada en una taxonomía | Generación de datos sintéticos (GDS) mediante un modelo maestro | Validación de datos sintéticos mediante un modelo crítico | Entrenamiento de habilidades y conocimientos sobre el o los modelos alumno |

Representa cualquier conocimiento o habilidad faltante del modelo en una taxonomía jerárquica y proporciona más de cinco puntos de datos ejemplificadores del comportamiento faltante por cada habilidad faltante. | Un modelo maestro genera un conjunto de millones de preguntas y respuestas en toda la taxonomía. | Los modelos críticos filtran las pregunta según su corrección y calidad. Los datos sintéticos se escanean en busca de material prohibido. | El modelo alumno se entrena con el conjunto mediante un enfoque de entrenamiento novedoso. |

InstructLab es el nombre del software que implementa la técnica LAB. Consiste de una interfaz de línea de comandos que interactúa con un repositorio git local de habilidades y conocimientos, que incluyen los nuevos añadidos por el usuario, para generar datos sintéticos, ejecutar el entrenamiento del LLM, entregar el modelo entrenado y chatear con él.

Para la versión preliminar para desarrolladores, InstructLab utiliza a) un flujo de trabajo de git para añadir habilidades y conocimientos; b) Mixtral, como modelo maestro para generar datos sintéticos; c) deepspeed, para un entrenamiento por etapas; y d) vllm, como servidor de inferencia. Además, las herramientas proporcionan puertas que permiten la revisión humana y los comentarios. Actualmente, trabajamos para añadir más herramientas que lo hagan más sencillo y escalable en el futuro. Como ocurre en cualquier proyecto open source, todos pueden participar de esta iniciativa.

InstructLab también es el nombre que recibe el proyecto de la comunidad open source que Red Hat inició en colaboración con IBM Research. El proyecto de la comunidad reúne las colaboraciones en una taxonomía pública con licencia Apache 2.0 mantenida por los mismos miembros. Periódicamente, se pone un modelo entrenado por LAB a disposición de la comunidad que incluye los aportes de la taxonomía comunitaria al modelo.

Referencias:

InstructLab: mecanismo impulsor de la innovación open source veloz (comunitaria y empresarial)

CLI InstructLab | Herramienta de clasificación y flujo de trabajo |

Los desarrolladores utilizan la CLI para desarrollar, probar y presentar habilidades como “pull requests”. | Se examina la calidad de las “pull requests” y se elige un subconjunto para esta instancia. |

Lanzamiento de modelos periódicos | Backend de InstructLab |

Las “pull requests” clasificadas se utilizan para ejecutar el flujo de backend (generación de datos sintéticos y entrenamiento en múltiples etapas). |

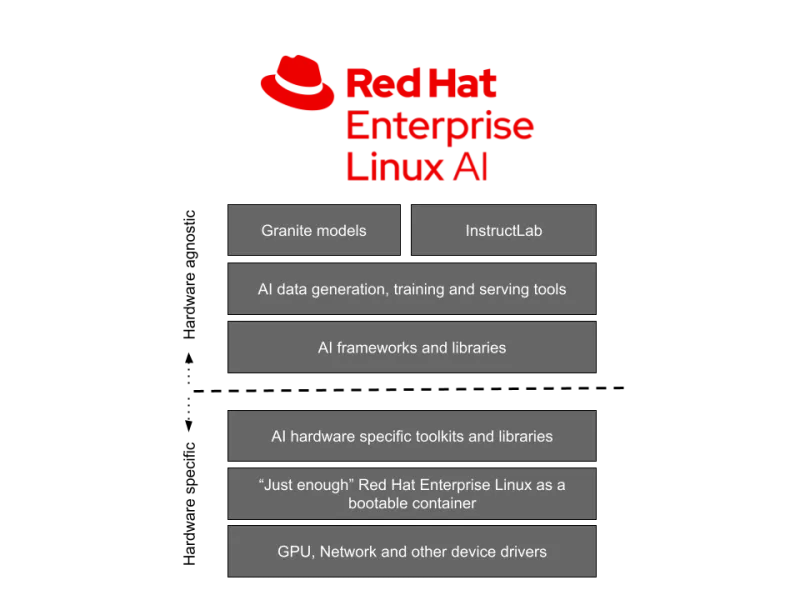

3. Red Hat Enterprise Linux de inicio optimizado para modelos Granite e InstructLab

Los modelos Granite y las herramientas de InstructLab mencionadas anteriormente se descargan e implementan en una imagen RHEL de inicio con una pila de software optimizada para los aceleradores de hardware más populares de proveedores como AMD, Intel y NVIDIA. Asimismo, estas imágenes de RHEL AI se iniciarán y ejecutarán en todo el Red Hat Certified Ecosystem, incluidas las nubes públicas (IBM Cloud está validada en la versión preliminar para desarrolladores) y en los servidores optimizados para AI de Dell, Cisco, HPE, Lenovo y SuperMicro. Las pruebas iniciales realizadas indican que se necesitan 320 GB de VRAM (4 GPU NVIDIA H100) o su equivalente para completar una sesión completa de InstructLab en un período de tiempo razonable.

Referencias:

Independiente del hardware | Modelos Granite | InstructLab |

Generación de datos de IA, entrenamiento y herramientas de servicio | ||

Marcos y bibliotecas de IA | ||

Específico del hardware | Conjuntos de herramientas y bibliotecas específicas para el hardware de IA | |

El Red Hat Enterprise Linux “suficiente” como contenedor de inicio | ||

GPU, Network y otros controladores de dispositivos | ||

4. Soporte empresarial, ciclo de vida y protección

En el momento de su disponibilidad general (GA), las suscripciones de Red Hat Enterprise Linux AI incluirán soporte empresarial, un ciclo de vida completo del producto que comenzará con el modelo y software Granite 7B y protección de la propiedad intelectual por parte de Red Hat.

Se debe tener presente que, para la versión preliminar para desarrolladores, Red Hat Enterprise Linux AI solo cuenta con soporte de la comunidad y no tiene soporte ni protección de Red Hat.

De la experimentación a la producción

A continuación, se incluye un enfoque en tres etapas sobre cómo empezar a realizar las primeras implementaciones en producción a gran escala:

- Paso 1: Puedes comenzar con una laptop (o computadora de escritorio) usando la CLI InstructLab open source. Esto hará que te familiarices con InstructLab y produzcas un modelo de baja fidelidad (qlora) que incorpore tus habilidades y conocimientos.

- Paso 2: Puedes iniciar Red Hat Enterprise Linux AI en un servidor bare-metal, una máquina virtual local o en la nube. A continuación, puedes añadir un conjunto de habilidades y conocimientos y entrenarlo para obtener un modelo entrenado y ajustado de alta fidelidad mediante InstructLab, con el que podrás chatear y que podrás integrar en tus aplicaciones.

- Paso 3: Para una producción a gran escala, puedes utilizar la misma metodología mencionada anteriormente (con RHEL AI), pero con el beneficio adicional de poder extender el entrenamiento a varios nodos para completarlo más rápidamente y lograr un mayor rendimiento con OpenShift AI. Además, OpenShift AI hace que sea mucho más fácil integrar tu modelo entrenado en tus aplicaciones nativas de la nube en modo de producción.

Referencias:

Paso 1: La CLI InstrucLab en una laptop/computadora de escritorio | Paso 2: InstructLab con RHEL AI en un servidor/MV en la nube híbrida | Paso 3: InstructLab con un clúster de OpenShift AI en la nube híbrida |

Aprende/Experimenta y produce un modelo de baja fidelidad | Primera sesión de producción de un modelo de alta fidelidad | Producción a gran escala |

Conclusión

Red Hat, junto con IBM, la comunidad open source y nuestros partners, ha emprendido un viaje increíble que llevará el poder de la innovación y la colaboración open source a los modelos de lenguaje de gran tamaño y el software empresarial abierto a las empresas y organizaciones. Creemos que esto es sólo el comienzo y que el futuro nos depara muchas oportunidades.

Te invitamos a que formes parte de ese viaje. Súmate a nuestra comunidad open source y empieza a contribuir.

Descarga la CLI InstructLab en tu laptop/computadora de escritorio para empezar a entrenar modelos Granite de código abierto o accede directamente a la versión preliminar para desarrolladores de RHEL AI. Si necesitas ayuda con la versión preliminar para desarrolladores, ponte en contacto con help-rhelai-devpreview@redhat.com.

Referencias

- Comunicado de prensa

- Main Landing Page for Red Hat Enterprise Linux AI

- Watch a video on how InstructLab lowers barriers to AI adoption

- Learn more about the open source-licensed Granite models

- InstructLab Community Page

- RHEL AI developer preview

- LAB: Large-Scale Alignment for ChatBots

- Granite code model family

- IBM research blog on Synthetic training for LLMs

- How to run RHEL AI on IBM Cloud

Sobre los autores

A 20+ year tech industry veteran, Jeremy is a Distinguished Engineer within the Red Hat OpenShift AI product group, building Red Hat's AI/ML and open source strategy. His role involves working with engineering and product leaders across the company to devise a strategy that will deliver a sustainable open source, enterprise software business around artificial intelligence and machine learning.

Más como éste

AI insights with actionable automation accelerate the journey to autonomous networks

Fast and simple AI deployment on Intel Xeon with Red Hat OpenShift

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Navegar por canal

Automatización

Las últimas novedades en la automatización de la TI para los equipos, la tecnología y los entornos

Inteligencia artificial

Descubra las actualizaciones en las plataformas que permiten a los clientes ejecutar cargas de trabajo de inteligecia artificial en cualquier lugar

Nube híbrida abierta

Vea como construimos un futuro flexible con la nube híbrida

Seguridad

Vea las últimas novedades sobre cómo reducimos los riesgos en entornos y tecnologías

Edge computing

Conozca las actualizaciones en las plataformas que simplifican las operaciones en el edge

Infraestructura

Vea las últimas novedades sobre la plataforma Linux empresarial líder en el mundo

Aplicaciones

Conozca nuestras soluciones para abordar los desafíos más complejos de las aplicaciones

Virtualización

El futuro de la virtualización empresarial para tus cargas de trabajo locales o en la nube