Durante mucho tiempo, los administradores de sistemas y los desarrolladores de Red Hat Enterprise Linux (RHEL) han confiado en un conjunto específico de herramientas para diagnosticar problemas, junto con años de experiencia e intuición acumuladas. Sin embargo, a medida que los entornos se vuelven más complejos, la carga cognitiva necesaria para descifrar los registros y solucionar los problemas de manera efectiva ha ido aumentando.

Hoy, nos complace anunciar la versión de prueba para desarrolladores de un nuevo servidor de protocolo de contexto de modelo (MCP) para Red Hat Enterprise Linux. Este nuevo servidor MCP está diseñado para cerrar la brecha entre RHEL y los modelos de lenguaje de gran tamaño (LLM), lo que permite una nueva era de resolución de problemas más inteligente.

¿Qué es el servidor MCP para RHEL?

MCP es un estándar abierto que permite que los modelos de inteligencia artificial interactúen con datos y sistemas externos, lanzado originalmente por Anthropic y donado en diciembre de 2025 a Agentic AI Foundation. El nuevo servidor MCP de Red Hat Enterprise Linux está ahora en versión de prueba para desarrolladores y utiliza este protocolo para brindar acceso directo y contextualizado a Red Hat Enterprise Linux desde las aplicaciones de inteligencia artificial que lo admiten, como Claude Desktop o goose.

Anteriormente, lanzamos servidores MCP para Red Hat Lightspeed y Red Hat Satellite, que permiten una serie de casos de uso interesantes. Este nuevo servidor MCP amplía estos casos de uso y está diseñado específicamente para la resolución de problemas en profundidad en los sistemas RHEL.

Habilitación de una resolución de problemas más inteligente

La conexión de tu LLM a RHEL con el nuevo servidor MCP posibilita casos de uso como los siguientes:

- Análisis de registros inteligente: Examinar los datos de los registros es tedioso. El servidor MCP permite que los LLM ingieran y analicen los registros del sistema RHEL. Esta función permite el análisis de la causa raíz y la detección de anomalías basados en la inteligencia artificial, lo que te permite convertir los datos de registro sin procesar en inteligencia procesable.

- Análisis del rendimiento: El servidor MCP puede acceder a información sobre la cantidad de CPU, el promedio de carga, información de la memoria y el uso de la CPU y la memoria de los procesos en ejecución. Esto permite que un sistema LLM analice el estado actual del sistema, identifique posibles cuellos de botella en el rendimiento y realice otras recomendaciones relacionadas con el rendimiento.

Para ayudarte a explorar estas nuevas funciones de una manera más segura, esta versión de prueba para desarrolladores se centra en la habilitación de MCP de solo lectura. El servidor MCP permite que un LLM inspeccione y recomiende, y utiliza claves SSH estándar para la autenticación. También se puede configurar con una lista de permitidos para el acceso a los archivos de registro y al nivel de acceso de los registros. El servidor MCP no permite el acceso de shell abierto a tu sistema RHEL, ya que los comandos que ejecuta el servidor MCP se evalúan previamente.

Ejemplos de casos de uso

En estos ejemplos, uso el agente de inteligencia artificial goose junto con el servidor MCP para trabajar con uno de mis sistemas RHEL 10 denominado rhel10.example.com. Goose admite varios proveedores de LLM, incluidos los proveedores alojados en línea y los alojados localmente. Estoy usando un modelo alojado localmente.

He instalado Goose y el servidor MCP en mi estación de trabajo Fedora, con la autenticación de clave SSH configurada con rhel10.example.com.

Comenzaré con una petición al LLM para que me ayude a verificar el estado del sistema rhel10.example.com:

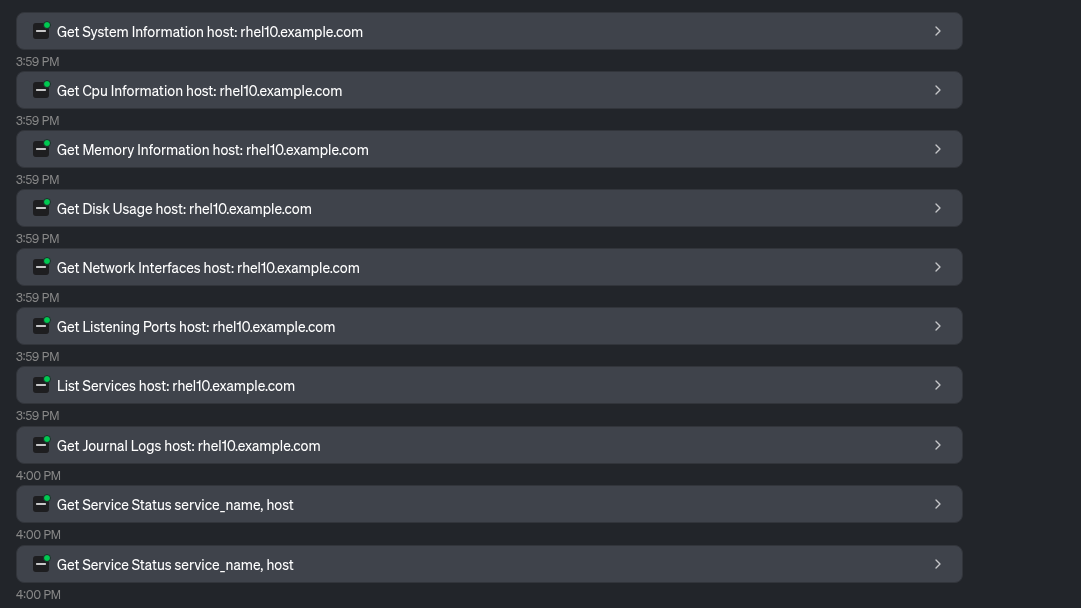

El LLM utiliza una serie de herramientas proporcionadas por el servidor MCP para recopilar información del sistema:

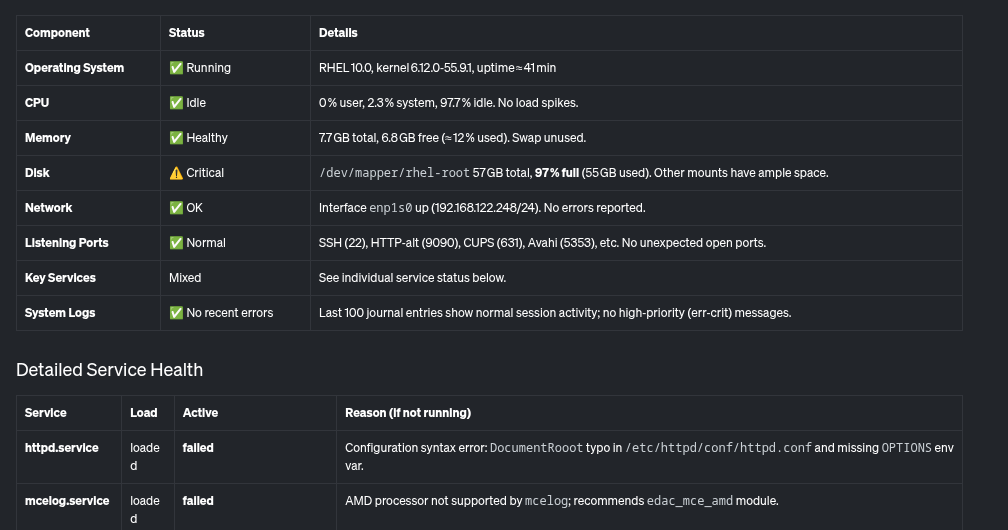

Según esto, el LLM proporciona una descripción general del sistema y su estado, incluida esta tabla:

Además, proporciona este resumen, señalando los problemas críticos que deben abordarse, como el sistema de archivos raíz casi lleno y un par de servicios que fallan en el sistema.

Examinemos los problemas identificados. Le pediré al LLM que me ayude a determinar por qué el uso del disco es tan alto:

El LLM utiliza herramientas proporcionadas por el servidor MCP para determinar qué está utilizando la mayor parte del espacio en disco:

Según esto, el LLM determina que el directorio /home/brian/virtual-machines tiene un archivo de 25 GB, y que el directorio /home/brian/.local está ocupando 24 GB de espacio:

Finalmente, también le pediré al LLM que me ayude con el servicio httpd.service, que se informó anteriormente como fallido.

El LLM utiliza la herramienta Read File proporcionada por el servidor MCP:

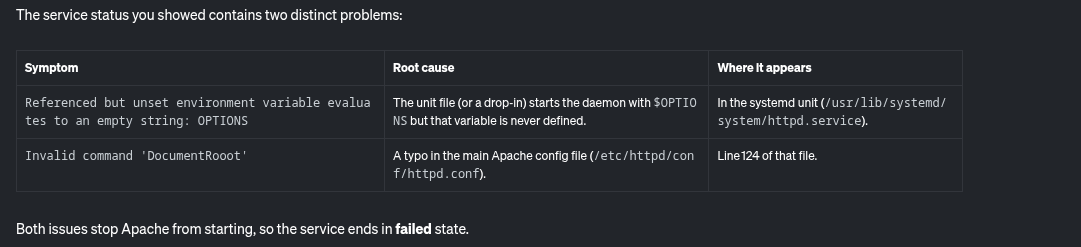

Según esto, el LLM informa sobre las causas potenciales del fallo de httpd.service:

Además, también proporciona algunas instrucciones paso a paso para corregir esto:

El servidor MCP para RHEL me permitió identificar y solucionar fácilmente los posibles problemas de este sistema relacionados con un sistema de archivos casi lleno y un servicio httpd defectuoso.

¿Qué sigue?

Si bien estamos comenzando con el análisis de solo lectura, nuestra hoja de ruta incluye expandirnos a casos de uso adicionales. Para seguir el proceso de desarrollo, consulta nuestro repositorio de GitHub upstream. ¡Agradecemos las contribuciones upstream! Estamos muy interesados en tus comentarios: solicitudes de mejora, informes de errores, etc. Puedes comunicarte con el equipo en GitHub o a través del grupo de interés especial (SIG) de inteligencia artificial/ML de Fedora.

¿Estás listo para experimentar una resolución de problemas más inteligente?

El servidor MCP para Red Hat Enterprise Linux ya está disponible en la versión de prueba para desarrolladores. Conecta tu aplicación cliente de LLM y observa cómo la inteligencia artificial contextual puede cambiar la forma en que gestionas RHEL. Para comenzar, consulta la documentación de Red Hat y la documentación upstream.

Prueba del producto

Prueba del producto Red Hat Enterprise Linux

Sobre los autores

Brian Smith is a product manager at Red Hat focused on RHEL automation and management. He has been at Red Hat since 2018, previously working with public sector customers as a technical account manager (TAM).

Máirín Duffy is a Red Hat Distinguished Engineer and leads the Red Hat Enterprise Linux Lightspeed Incubation team at Red Hat as a passionate advocate for human-centered AI and open source. A recipient of the O’Reilly Open Source Award, Máirín first joined Red Hat as an intern in 2004 and has spent two decades in open source communities focusing on user experience in order to expand the reach of open source. A sought-after speaker and author, Mo holds 19 patents and authored 6 open source coloring books, including The SELinux Coloring Book.

Más como éste

Innovation is a team sport: Top 10 stories from across the Red Hat ecosystem

Production-ready: Red Hat’s blueprint for 2026

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Navegar por canal

Automatización

Las últimas novedades en la automatización de la TI para los equipos, la tecnología y los entornos

Inteligencia artificial

Descubra las actualizaciones en las plataformas que permiten a los clientes ejecutar cargas de trabajo de inteligecia artificial en cualquier lugar

Nube híbrida abierta

Vea como construimos un futuro flexible con la nube híbrida

Seguridad

Vea las últimas novedades sobre cómo reducimos los riesgos en entornos y tecnologías

Edge computing

Conozca las actualizaciones en las plataformas que simplifican las operaciones en el edge

Infraestructura

Vea las últimas novedades sobre la plataforma Linux empresarial líder en el mundo

Aplicaciones

Conozca nuestras soluciones para abordar los desafíos más complejos de las aplicaciones

Virtualización

El futuro de la virtualización empresarial para tus cargas de trabajo locales o en la nube