기업에 AI를 도입할 때, 기술검증(POC)에서 프로덕션 레디 애플리케이션으로 전환하는 과정은 특히 에이전틱 AI 활용 사례의 경우 파편화된 툴과 복잡한 통합의 미로인 경우가 많습니다. 실제 과제는 기술만이 아니라 확장 가능하고, 안정적이며, 관리하기 쉬운 AI 전략을 구축하는 것입니다.

표준화는 복잡성을 줄이고 효율성을 높여 이러한 과제를 해결하는 주요 요소입니다. Red Hat OpenShift AI와 같은 플랫폼에서 MCP(Model Context Protocol)와 Llama Stack을 결합하여 AI 애플리케이션을 위한 이식 가능한 통합 환경을 구축할 수 있습니다.

또한 OpenShift AI는 LangChain, LangGraph, CrewAI 등의 툴을 포함하여 원하는 다른 모든 에이전트 프레임워크 및 구성 요소의 통합을 지원할 수 있습니다. Red Hat의 접근 방식은 개발을 간소화하고 운영을 간소화하며 기업이 AI 개발자 및 데이터 과학자와 같은 여러 팀의 역량을 강화하는 데 필요한 툴을 제공하여 신뢰할 수 있고 일관된 환경 내에서 AI 비전을 실현할 수 있도록 지원합니다.

인텔리전트 에이전트의 구성 요소 이해

복원력을 갖춘 AI 지원 애플리케이션을 구축하려면 인텔리전트 에이전트가 기업의 특정 툴과 데이터에 액세스하고 사용할 수 있도록 지원하는 기반이 필요합니다. 이를 위해서는 두 가지 핵심 구성 요소가 필요합니다. 하나는 서비스를 노출하는 표준화된 방법이고, 다른 하나는 서비스와 상호 작용하기 위한 통합 프레임워크입니다.

이것이 에이전트 AI의 핵심으로, 자율 시스템이 목표를 달성하는 데 필요한 최적의 작업 과정과 툴을 결정할 수 있습니다. MCP와 Llama Stack의 조합은 이러한 에이전트가 효과적으로 작동할 수 있는 프레임워크를 제공합니다.

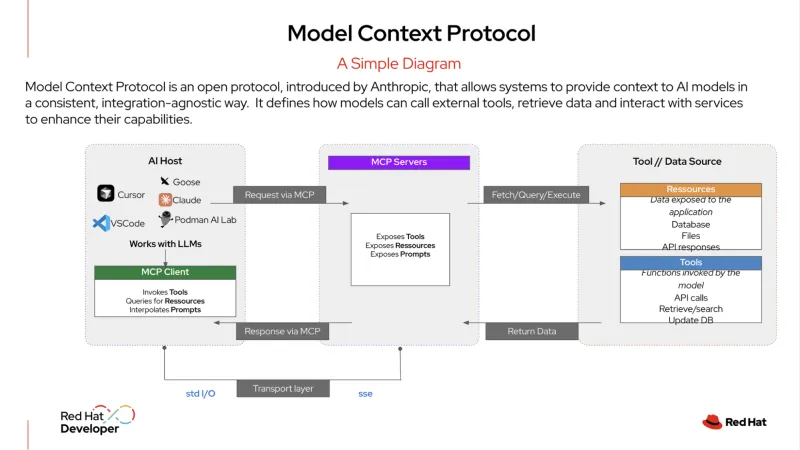

MCP는 AI 시스템이 외부 툴 및 데이터 소스와 통합되는 방식을 표준화하는 오픈 프로토콜입니다. "AI 애플리케이션을 위한 USB-C 포트"로 설명되어 왔습니다. USB-C를 사용하면 모니터, 하드 드라이브, 키보드 등 호환되는 모든 기기를 연결할 수 있듯이 MCP 서버는 조직의 서비스를 표준화된 형식으로 제공합니다.

그런 다음 AI 에이전트는 이 서버에 플러그인하여 데이터베이스, 고객 관계 관리(CRM) 시스템, 내부 API 등 사용 가능한 툴을 검색하고 사용할 수 있습니다. 이 프로토콜은 AI 에이전트가 서비스에 연결할 수 있는 정형화된 방식을 제공하므로 태스크를 수행하는 데 필요한 정보를 쉽게 얻을 수 있습니다.

Llama Stack은 생성형 AI(gen AI) 애플리케이션을 빌드하고 배포하기 위한 통합 API 기반 접근 방식을 제공하는 오픈소스 프레임워크입니다. AI 개발 및 배포의 복잡성을 추상화할 수 있는 일관되고 이식 가능한 방법을 제공하며, 추론, RAG(Retrieval-Augmented Generation), AI 에이전트를 위한 API와 같은 엔터프라이즈 툴 제품군을 포함합니다. 또한 안전, 평가, 관측성을 위한 빌트인 구성 요소를 제공하여 조직이 안정적이고 확장 가능한 프로덕션 레디 AI 애플리케이션을 개발할 수 있도록 지원합니다.

실행 중인 에이전틱 AI의 예

엔터프라이즈 IT에서 에이전틱 AI는 역동적인 의사 결정이 필요한 복잡한 다단계 워크플로우를 처리할 수 있습니다. 예를 들어, 단순한 일대일 요청 및 응답 대신 보다 정교한 에이전트가 자율적인 서비스 데스크 관리자 역할을 하여 최소한의 인적 개입으로 문제를 해결할 수 있습니다.

다음은 사용자가 "서비스 중단"에 대한 티켓을 제출할 때 이러한 종류의 에이전트가 수행할 수 있는 작업의 예입니다.

- Llama Stack은 초기 티켓을 받습니다. 시스템은 서비스 중단에 대한 사용자 보고서를 수신하고 이를 높은 우선 순위 인시던트로 분류합니다.

- 에이전트는 MCP를 사용하고 계획을 수립합니다. 에이전트는 MCP를 사용하여 모니터링 서비스, 로그 분석 툴, Runbook 자동화 시스템 등 액세스할 수 있는 관련 툴을 식별하고 검색합니다. 에이전트는 MCP의 이 컨텍스트를 사용하여 문제를 조사하고 해결하는 다단계 계획을 수립합니다.

- 에이전트는 검색된 툴과 통신하기 위해 MCP를 사용하여 계획을 실행합니다.

- 먼저 모니터링 툴을 사용하여 관련 서비스 및 종속성의 상태를 확인합니다.

- 그런 다음 로그 분석 툴을 호출하여 관련 애플리케이션 또는 Red Hat OpenShift 컨테이너의 최근 로그를 검토하고 오류를 검색합니다.

- 잠재적인 문제가 식별되면(예: 포드 충돌) 진단 툴을 사용하여 잘못 구성된 네트워크 정책 또는 전체 디스크와 같은 근본적인 문제를 정확히 찾아냅니다.

- 에이전트가 수정 작업을 수행합니다. 진단에 따라 MCP를 사용하여 사전 승인된 해결 스크립트를 호출하여 포드를 다시 시작하고 디스크 공간을 비웁니다. 그런 다음 서비스 상태를 다시 확인하여 문제가 해결되었는지 확인합니다.

- 에이전트는 결과를 전달합니다. 내부 툴을 사용하여 수행한 작업에 대한 요약을 포함하여 티켓 상태를 "해결됨"으로 업데이트합니다. 그런 다음 사용자에게 메시지 초안을 작성하여 문제를 설명하고 서비스가 다시 온라인 상태인지 확인합니다. 이 모든 작업은 단일 인적 접점 없이 이루어집니다.

에이전트는 MCP를 사용하여 이러한 작업을 오케스트레이션함으로써 자율적이고 독립적인 서비스 데스크로 운영할 수 있으므로 IT 팀의 수동 작업 부담이 줄어들어 더욱 전략적인 이니셔티브에 집중할 수 있습니다.

간소화된 개발 및 프로덕션 접근 방식

Llama Stack과 MCP를 함께 사용하면 개발자 경험이 크게 향상됩니다. 개발자는 특정 모놀리식 스택을 구축하는 대신 단일 API를 통해 표준화된 추상화 계층을 사용할 수 있습니다. 이를 통해 단일 SDK를 사용하여 로컬 머신에서 AI 애플리케이션을 빌드하고 테스트할 수 있는 강력한 "내부 루프" 개발 방법론을 사용할 수 있습니다.

API가 일관되고 표준화된 프로토콜을 통해 서비스가 검색되기 때문에 개발자는 애플리케이션이 엔터프라이즈급 플랫폼에 배포될 때 애플리케이션이 정확히 동일한 방식으로 작동한다는 확신을 가질 수 있습니다.

이러한 이식성은 빠르게 변화하는 AI 환경에서 매우 중요합니다. 개발자는 현재 하나의 모델을 사용하도록 애플리케이션을 구축할 수 있으며, 더 낫거나 더 비용 효율적인 새로운 모델이 등장하면 코드를 다시 작성할 필요 없이 해당 모델로 전환할 수 있습니다. 이를 통해 개발 시간과 노력을 줄이고, 혁신을 가속화하고, 개발에서 프로덕션으로 이동할 수 있는 명확한 경로를 제공합니다.

AI 워크로드를 위한 운영 일관성 확보

운영 팀의 경우 다양한 AI 모델과 서비스를 관리하는 것이 복잡성의 주요 원인이 될 수 있습니다. 그러나 OpenShift AI와 같은 플랫폼에서 조직에 맞게 표준화된 AI 스택을 실행하면 일관된 중앙화된 환경을 확보할 수 있습니다.

OpenShift AI는 LLM을 배포 및 제공하고 RAG 애플리케이션에 필요한 데이터베이스를 실행하기 위한 포괄적이고 신뢰할 수 있는 플랫폼을 제공합니다. 또한 팀은 기존 마이크로서비스 아키텍처를 활용하고 내부 시스템에 원활하게 연결할 수 있습니다.

또한 운영 팀은 표준 GitOps 프로세스를 사용하여 이러한 AI 애플리케이션을 배포하고 관리할 수 있습니다. 즉, 기존 클라우드 네이티브 애플리케이션에 사용되는 것과 동일한 워크플로우를 AI 워크로드에 적용할 수 있으므로 규모에 따른 관리 및 유지 관리가 간소화됩니다. 개발에서 프로덕션에 이르는 여정을 간소화하고 하이브리드 클라우드 환경 전반에서 운영 일관성을 제공합니다.

Llama Stack 및 MCP와 같은 오픈소스 기술의 힘을 결합하고, LangChain, Haystack, LlamaIndex, PydanticAI와 같은 다른 에이전트 기반 AI 프레임워크의 통합을 지원함으로써 Red Hat AI는 하이브리드 클라우드 전반에서 AI 애플리케이션을 구축, 배포 및 관리하기 위한 안정적인 기반을 제공합니다.

자세히 알아보기

시작할 준비가 되셨나요? 제품 체험판, 컨설팅 서비스, 교육 및 자격증 등을 통해 Red Hat AI에 대해 자세히 알아보세요.

리소스

적응형 엔터프라이즈: AI 준비성은 곧 위기 대응력

저자 소개

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.

유사한 검색 결과

Sovereign AI architecture: Scaling distributed training with Kubeflow Trainer and Feast on Red Hat OpenShift AI

AI quickstarts: An easy and practical way to get started with Red Hat AI

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

채널별 검색

오토메이션

기술, 팀, 인프라를 위한 IT 자동화 최신 동향

인공지능

고객이 어디서나 AI 워크로드를 실행할 수 있도록 지원하는 플랫폼 업데이트

오픈 하이브리드 클라우드

하이브리드 클라우드로 더욱 유연한 미래를 구축하는 방법을 알아보세요

보안

환경과 기술 전반에 걸쳐 리스크를 감소하는 방법에 대한 최신 정보

엣지 컴퓨팅

엣지에서의 운영을 단순화하는 플랫폼 업데이트

인프라

세계적으로 인정받은 기업용 Linux 플랫폼에 대한 최신 정보

애플리케이션

복잡한 애플리케이션에 대한 솔루션 더 보기

가상화

온프레미스와 클라우드 환경에서 워크로드를 유연하게 운영하기 위한 엔터프라이즈 가상화의 미래