Sua missão é incorporar a inteligência artificial à sua empresa, mas o caminho das provas de conceito até a implantação em produção costuma ser um labirinto de ferramentas fragmentadas e integrações complexas — especialmente em casos de uso de Agentic AI. O verdadeiro desafio não é somente a tecnologia, mas a criação de uma estratégia de IA que seja escalável, confiável e gerenciável.

A padronização é um fator fundamental para superar esse desafio, principalmente por reduzir a complexidade e aumentar a eficiência. Ao combinar o Model Context Protocol (MCP) e o Llama Stack em uma plataforma como o Red Hat OpenShift AI, você cria um ambiente unificado e portátil para suas aplicações de IA.

O OpenShift AI também é compatível com a integração de outros componentes e frameworks de agentes de sua preferência, incluindo ferramentas como LangChain, LangGraph e CrewAI, entre outras. A abordagem da Red Hat pode ajudar a simplificar o desenvolvimento, otimizar as operações e oferecer à sua empresa as ferramentas necessárias para capacitar várias equipes, como desenvolvedores de IA e cientistas de dados, a transformar sua visão de IA em realidade em um ambiente confiável e consistente.

Elementos básicos de um agente inteligente

Para criar aplicações resilientes habilitadas para IA, você precisa de uma base que permita que agentes inteligentes acessem e usem ferramentas e dados específicos da sua empresa. Isso exige dois componentes principais: uma maneira padronizada de expor seus serviços e um framework unificado para interagir com eles.

Essa é a essência da Agentic AI, em que um sistema autônomo pode determinar o melhor curso de ação e as ferramentas necessárias para alcançar uma meta. A combinação de MCP e Llama Stack fornece a estrutura para que esses agentes operem com eficiência.

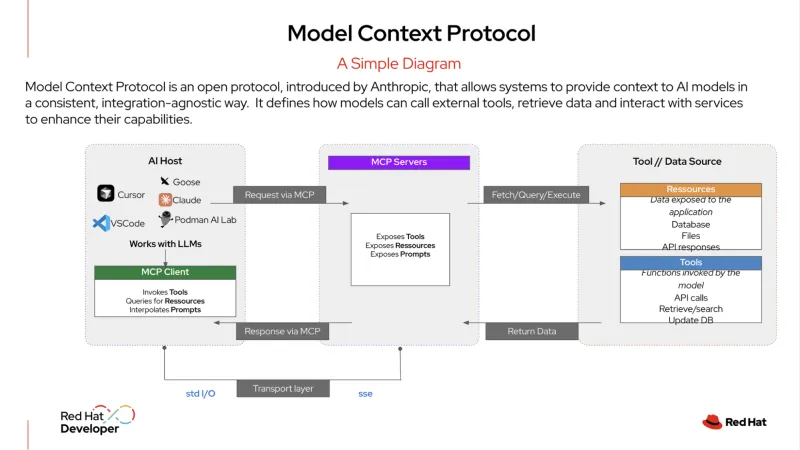

O MCP é um protocolo aberto que padroniza a integração dos sistemas de IA com ferramentas e fontes de dados externas. Descrevem-no como uma "porta USB-C para aplicações de IA". Assim como o USB-C permite que você conecte qualquer dispositivo compatível, seja um monitor, um disco rígido ou um teclado, um servidor MCP expõe os serviços da organização em um formato padronizado.

Um agente de IA pode se conectar a esse servidor para descobrir e usar as ferramentas disponíveis, seja um banco de dados, um CRM ou uma API interna. Esse protocolo oferece uma maneira estruturada para os agentes de IA se conectarem aos serviços, facilitando o acesso às informações necessárias para realizar tarefas.

O Llama Stack é um framework open source que oferece uma abordagem unificada e orientada por API para criar e implantar aplicações de IA generativa (gen AI). Ele oferece uma maneira consistente e portátil de abstrair as complexidades do desenvolvimento e implantação de IA e inclui um conjunto de ferramentas empresariais, como APIs para inferência, geração aumentada de recuperação (RAG) e agentes de IA. Ele também oferece componentes integrados para segurança, avaliação e observabilidade, ajudando as organizações a criar aplicações de IA prontas para produção que sejam confiáveis e escaláveis.

Um exemplo de Agentic AI em ação

Na TI empresarial, a Agentic AI pode lidar com fluxos de trabalho complexos e de várias etapas que exigem uma tomada de decisão dinâmica. Por exemplo, em vez de uma simples solicitação e resposta individuais, um agente mais sofisticado pode atuar como um gerente de service desk autônomo, resolvendo problemas com o mínimo de intervenção humana.

Veja um exemplo do que esse tipo de agente pode fazer quando um usuário envia um ticket reportando uma "interrupção de serviço":

- O Llama Stack recebe o ticket inicial. O sistema recebe o relatório do usuário sobre uma interrupção de serviço e o categoriza como um incidente de alta prioridade.

- O agente usa o MCP e formula um plano. O agente usa o MCP para identificar e descobrir as ferramentas relevantes às quais ele tem acesso, como um serviço de monitoramento, uma ferramenta de análise de log e um sistema de automação de runbook. Com o contexto obtido pelo MCP, o agente formula um plano de várias etapas para investigar e resolver o problema.

- O agente executa o plano usando o MCP para se comunicar com as ferramentas descobertas.

- Primeiro, ele usa uma ferramenta de monitoramento para verificar os status dos serviços e dependências relevantes.

- Em seguida, ele chama uma ferramenta de análise de logs para revisar os logs recentes de uma aplicação relacionada ou um container do Red Hat OpenShift, procurando por erros.

- Após identificar um problema potencial (por exemplo, um pod está falhando), ele usa uma ferramenta de diagnóstico para identificar o problema subjacente, como, por exemplo, uma política de rede configurada incorretamente ou um disco cheio.

- O agente executa uma ação corretiva. Com base no diagnóstico, ele usa o MCP para chamar um script de correção pré-aprovado para reiniciar o pod e limpar o espaço em disco. Em seguida, ele verifica novamente o status do serviço para confirmar a resolução do problema.

- O agente comunica o resultado. Ele usa uma ferramenta interna para atualizar o status do incidente para "resolvido", incluindo um resumo das ações realizadas. Em seguida, ele envia uma mensagem para o usuário, explicando o problema e confirmando que o serviço está online novamente, tudo sem um único ponto de contato humano.

Ao usar o MCP para orquestrar essas ações, o agente é capaz de operar como uma central de serviço autônoma e independente, reduzindo a carga manual das equipes de TI e dando a elas tempo para se concentrarem em iniciativas mais estratégicas.

Abordagem simplificada para desenvolvimento e produção

A combinação de Llama Stack e MCP melhora significativamente a experiência do desenvolvedor. Em vez de criar para um stack monolítico específico, seus desenvolvedores podem usar uma camada padronizada de abstração por meio de uma única API. Isso possibilita uma poderosa metodologia de desenvolvimento de "loop interno", na qual eles podem criar e testar suas aplicações de IA em uma máquina local usando um único SDK.

Como as APIs são consistentes e os serviços são descobertos por meio de um protocolo padronizado, seus desenvolvedores podem ter a certeza de que a aplicação funcionará exatamente da mesma maneira quando implantada em uma plataforma de nível empresarial.

Essa portabilidade é essencial em ambientes dinâmicos de IA. Um desenvolvedor pode compilar sua aplicação para usar um modelo atual e, se surgir um novo modelo melhor ou mais econômico, ele pode mudar para ele sem ter que reescrever seu código. Isso reduz o tempo e o esforço de desenvolvimento, acelera a inovação e oferece um caminho claro para migrar do desenvolvimento para a produção.

Consistência operacional para cargas de trabalho de IA

Para suas equipes de operações, gerenciar uma variedade de modelos e serviços de IA pode ser uma grande fonte de complexidade. No entanto, ao executar um stack de IA padronizado e personalizado para sua organização em uma plataforma como o OpenShift AI, você ganha um ambiente centralizado e consistente.

O OpenShift AI oferece uma plataforma abrangente e confiável para implantar e servir LLMs e executar os bancos de dados necessários para aplicações RAG. Ele também permite que suas equipes aproveitem as arquiteturas de microsserviços existentes e se conectem aos sistemas internos sem problemas.

Suas equipes de operações também podem usar os processos GitOps padrão para implantar e gerenciar essas aplicações de IA. Isso significa que os mesmos fluxos de trabalho usados para aplicações nativas em nuvem tradicionais podem ser aplicados a cargas de trabalho de IA, simplificando o gerenciamento e a manutenção em escala. Ele simplifica a jornada do desenvolvimento à produção e oferece consistência operacional nos ambientes de nuvem híbrida.

Ao combinar o poder das tecnologias open source, como o Llama Stack e o MCP, e permitir a integração de outros frameworks de Agentic AI, como LangChain, Haystack, LlamaIndex e PydanticAI, entre outros, o Red Hat AI oferece uma base confiável para criar, implantar e gerenciar aplicações de IA em toda a nuvem híbrida.

Mais informações

Vamos começar? Saiba mais sobre o Red Hat AI com nossas avaliações de solução, serviços de consultoria, treinamento e certificação e muito mais.

Recurso

A empresa adaptável: da prontidão para a IA à disrupção

Sobre os autores

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.

Mais como este

Empowering federated learning with multicluster management

Feature store: The front-end for all of your AI data pipelines

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Navegue por canal

Automação

Últimas novidades em automação de TI para empresas de tecnologia, equipes e ambientes

Inteligência artificial

Descubra as atualizações nas plataformas que proporcionam aos clientes executar suas cargas de trabalho de IA em qualquer ambiente

Nuvem híbrida aberta

Veja como construímos um futuro mais flexível com a nuvem híbrida

Segurança

Veja as últimas novidades sobre como reduzimos riscos em ambientes e tecnologias

Edge computing

Saiba quais são as atualizações nas plataformas que simplificam as operações na borda

Infraestrutura

Saiba o que há de mais recente na plataforma Linux empresarial líder mundial

Aplicações

Conheça nossas soluções desenvolvidas para ajudar você a superar os desafios mais complexos de aplicações

Virtualização

O futuro da virtualização empresarial para suas cargas de trabalho on-premise ou na nuvem