Debes incorporar la inteligencia artificial a tu organización, pero el trayecto desde una prueba de concepto hasta una aplicación preparada para la producción suele ser un laberinto de herramientas fragmentadas e integraciones complejas, especialmente para los casos prácticos de inteligencia artificial con agentes. El verdadero desafío no es solo la tecnología, sino construir una estrategia de inteligencia artificial que pueda ajustarse y que sea confiable y gestionable.

La estandarización es un factor primordial para afrontar este desafío, principalmente al reducir la complejidad y aumentar la eficiencia. Al combinar Model Context Protocol (MCP) y Llama Stack en una plataforma como Red Hat OpenShift AI, puedes crear un entorno unificado y portátil para tus aplicaciones de inteligencia artificial.

OpenShift AI también admite la integración de cualquier otros componentes y marcos con agentes que te gusten, incluidas herramientas como LangChain, LangGraph y CrewAI, entre otras. El enfoque de Red Hat puede ayudar a simplificar el desarrollo, optimizar las operaciones y proporcionar a tu organización las herramientas que necesita. Así, empoderarás a tus múltiples equipos, como los desarrolladores de inteligencia artificial y los científicos de datos, para que conviertan tu visión de la inteligencia artificial en una realidad dentro de un entorno confiable y consistente.

Comprensión de los componentes básicos de un agente inteligente

Para construir aplicaciones resistentes habilitadas para la inteligencia artificial, necesitas una base que permita que los agentes inteligentes accedan a las herramientas y los datos específicos de tu organización y los utilicen. Esto requiere dos elementos clave: una forma estandarizada de exponer tus servicios y un marco unificado para interactuar con ellos.

Esta es la esencia de la inteligencia artificial con agentes, donde un sistema autónomo puede determinar el mejor curso de acción y las herramientas necesarias para lograr un objetivo. La combinación de MCP y Llama Stack proporciona el marco para que estos agentes funcionen eficazmente.

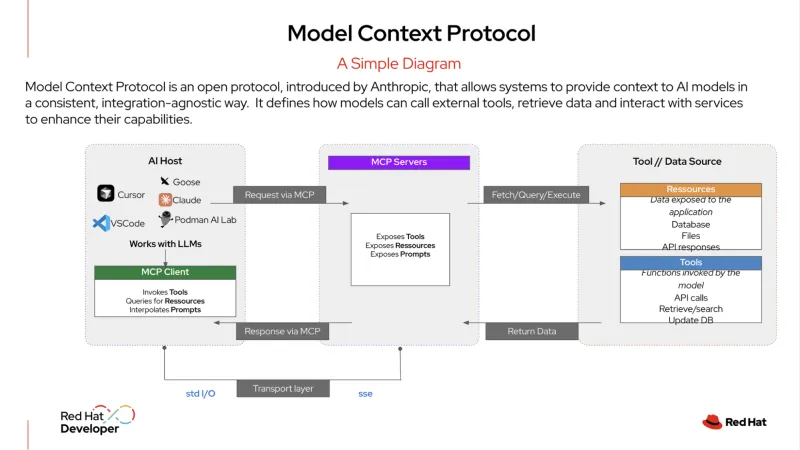

MCP es un protocolo abierto que estandariza cómo se integran tus sistemas de inteligencia artificial con las herramientas y las fuentes de datos externas. Se ha descrito como un "puerto USB-C para aplicaciones de inteligencia artificial". Así como el USB-C te permite conectar cualquier dispositivo compatible (un monitor, un disco duro o un teclado), un servidor MCP expone los servicios de tu organización en un formato estandarizado.

Un agente de inteligencia artificial puede conectarse a este servidor para descubrir y usar las herramientas disponibles, ya sea una base de datos, un sistema de gestión de relaciones con los clientes (CRM) o una interfaz de programación de aplicaciones (API) interna. Este protocolo proporciona una forma estructurada para que los agentes de inteligencia artificial se conecten con los servicios, lo que les facilita obtener la información que necesitan para llevar a cabo las tareas.

Llama Stack es un marco open source que ofrece un enfoque unificado basado en las API para construir e implementar aplicaciones de inteligencia artificial generativa (gen AI). Ofrece una forma consistente y portátil de abstraer las complejidades del desarrollo y la implementación de la inteligencia artificial, e incluye un conjunto de herramientas empresariales, como las interfaces de programación de aplicaciones (API) para la inferencia, la generación aumentada por recuperación (RAG) y los agentes de inteligencia artificial. También proporciona componentes integrados para la seguridad, la evaluación y el monitoreo, lo que ayuda a las organizaciones a crear aplicaciones de inteligencia artificial listas para la producción que sean confiables y escalables.

Ejemplo de la inteligencia artificial con agentes en acción

En la TI empresarial, la inteligencia artificial con agentes puede gestionar flujos de trabajo complejos y de varios pasos que requieren una toma de decisiones dinámica. Por ejemplo, en lugar de una simple solicitud y respuesta uno a uno, un agente más sofisticado puede actuar como administrador autónomo de servicios de soporte, resolviendo problemas con una intervención humana mínima.

Este es un ejemplo de lo que ese tipo de agente podría hacer cuando un usuario crea un ticket por una "interrupción del servicio":

- Llama Stack recibe el ticket inicial. El sistema recibe el informe del usuario sobre una interrupción del servicio y lo clasifica como un incidente de alta prioridad.

- El agente usa MCP y formula un plan. El agente usa el MCP para identificar y descubrir las herramientas relevantes a las que tiene acceso, como un servicio de monitoreo, una herramienta de análisis de registros y un sistema de automatización de runbooks. Con este contexto del MCP, el agente formula un plan de varios pasos para investigar y resolver el problema.

- El agente ejecuta el plan mediante MCP para comunicarse con las herramientas descubiertas.

- Primero usa una herramienta de monitoreo para verificar el estado de los servicios y las dependencias relevantes.

- Luego, llama a una herramienta de análisis de registros para revisar los registros recientes de una aplicación relacionada o un contenedor de Red Hat OpenShift, en busca de errores.

- Una vez que se identifica un problema potencial (por ejemplo, un pod se bloquea), utiliza una herramienta de diagnóstico para identificar el problema subyacente, como una política de red mal configurada o un disco lleno.

- El agente realiza una acción correctiva. Según el diagnóstico, usa MCP para invocar un script de corrección aprobado previamente para reiniciar el pod y borrar el espacio en disco. Luego, vuelve a verificar el estado del servicio para confirmar que se ha resuelto el problema.

- El agente comunica el resultado. Usa una herramienta interna para actualizar el estado del ticket a "resuelto", incluido un resumen de las acciones realizadas. Luego, redacta un mensaje para el usuario, explica el problema y confirma que el servicio está nuevamente en línea, todo sin un solo punto de contacto humano.

Al usar el MCP para orquestar estas acciones, el agente puede funcionar como una mesa de servicio autónoma y autosuficiente, lo que reduce la carga manual de los equipos de TI y les da tiempo para centrarse en iniciativas más estratégicas.

Un enfoque optimizado para el desarrollo y la producción

La combinación de Llama Stack y MCP mejora significativamente la experiencia del desarrollador. En lugar de construir para una pila monolítica específica, tus desarrolladores pueden usar una capa estandarizada de abstracción a través de una única interfaz de programación de aplicaciones (API). Esto permite una metodología de desarrollo de "bucle interno" potente, donde pueden construir y probar sus aplicaciones de inteligencia artificial en una máquina local con un solo kit de desarrollo de software (SDK).

Debido a que las API son consistentes y los servicios se descubren a través de un protocolo estandarizado, tus desarrolladores pueden confiar en que su aplicación funcionará exactamente de la misma manera cuando se implemente en una plataforma de nivel empresarial.

Esta portabilidad es vital en el entorno de inteligencia artificial que cambia rápidamente. Un desarrollador puede construir su aplicación para usar un modelo hoy y, si surge un nuevo modelo que es mejor o más rentable, puede cambiar a este sin tener que volver a escribir su código. Esto reduce el tiempo y el esfuerzo de desarrollo, acelera la innovación y proporciona un camino claro para pasar del desarrollo a la producción.

Obtener consistencia operativa para las cargas de trabajo de inteligencia artificial

Para tus equipos de operaciones, la gestión de una diversa variedad de modelos y servicios de inteligencia artificial puede ser una fuente importante de complejidad. Sin embargo, si ejecutas una stack de inteligencia artificial estandarizada y adaptada a tu organización en una plataforma como OpenShift AI, obtienes un entorno centralizado y consistente.

OpenShift AI proporciona una plataforma integral y confiable para implementar y prestar servicios de modelos de lenguaje de gran tamaño (LLMs) y ejecutar las bases de datos necesarias para las aplicaciones RAG. También permite que tus equipos aprovechen sus arquitecturas de microservicios actuales y se conecten a los sistemas internos sin problemas.

Tus equipos de operaciones también pueden usar sus procesos estándar de GitOps para implementar y gestionar estas aplicaciones de inteligencia artificial. Esto significa que los mismos flujos de trabajo que se usan para las aplicaciones tradicionales nativas de la nube se pueden aplicar a las cargas de trabajo de inteligencia artificial, lo que simplifica la gestión y el mantenimiento a escala. Crea un recorrido simplificado desde el desarrollo hasta la producción y proporciona consistencia operativa en todos tus entornos de nube híbrida.

Al combinar el poder de las tecnologías open source, como Llama Stack y MCP, y al permitir la integración de otros marcos de inteligencia artificial con agentes, como LangChain, Haystack, LlamaIndex y PydanticAI, entre otros, Red Hat AI proporciona una base confiable para construir, implementar y gestionar aplicaciones de inteligencia artificial en toda tu nube híbrida.

Más información

¿Estás listo para comenzar? Obtén más información sobre Red Hat AI a través de las pruebas de nuestros productos, los servicios de consultoría, la formación y la certificación, y mucho más.

Recurso

La empresa adaptable: Motivos por los que la preparación para la inteligencia artificial implica prepararse para los cambios drásticos

Sobre los autores

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.

Más como éste

AI quickstarts: An easy and practical way to get started with Red Hat AI

Looking ahead to 2026: Red Hat’s view across the hybrid cloud

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Navegar por canal

Automatización

Las últimas novedades en la automatización de la TI para los equipos, la tecnología y los entornos

Inteligencia artificial

Descubra las actualizaciones en las plataformas que permiten a los clientes ejecutar cargas de trabajo de inteligecia artificial en cualquier lugar

Nube híbrida abierta

Vea como construimos un futuro flexible con la nube híbrida

Seguridad

Vea las últimas novedades sobre cómo reducimos los riesgos en entornos y tecnologías

Edge computing

Conozca las actualizaciones en las plataformas que simplifican las operaciones en el edge

Infraestructura

Vea las últimas novedades sobre la plataforma Linux empresarial líder en el mundo

Aplicaciones

Conozca nuestras soluciones para abordar los desafíos más complejos de las aplicaciones

Virtualización

El futuro de la virtualización empresarial para tus cargas de trabajo locales o en la nube