-

Prodotti e documentazione Red Hat AI

Una piattaforma di prodotti e servizi per lo sviluppo e il deployment dell'IA nel cloud ibrido.

Red Hat AI Enterprise

Crea, sviluppa e distribuisci applicazioni basate sull'IA nel cloud ibrido.

Red Hat AI Inference Server

Ottimizza le prestazioni dei modelli con vLLM per un'inferenza rapida e conveniente in modo scalabile.

Red Hat Enterprise Linux AI

Sviluppa, testa ed esegui modelli di IA generativa con funzionalità di inferenza ottimizzate.

Red Hat OpenShift AI

Crea e distribuisci applicazioni e modelli basati sull'IA in modo scalabile negli ambienti ibridi.

-

Formazione Concetti di base

-

Partner per l'IA

Red Hat OpenShift AI

Red Hat® OpenShift® AI è una piattaforma di IA studiata per la gestione del ciclo di vita dei modelli di IA predittiva e di IA generativa (IA gen) negli ambienti cloud ibridi complessi.

Cos'è Red Hat OpenShift AI?

Soluzione basata su tecnologie open source, OpenShift AI offre funzionalità affidabili e coerenti con cui i team possono mettere alla prova le proprie competenze, distribuire i modelli e rilasciare applicazioni innovative.

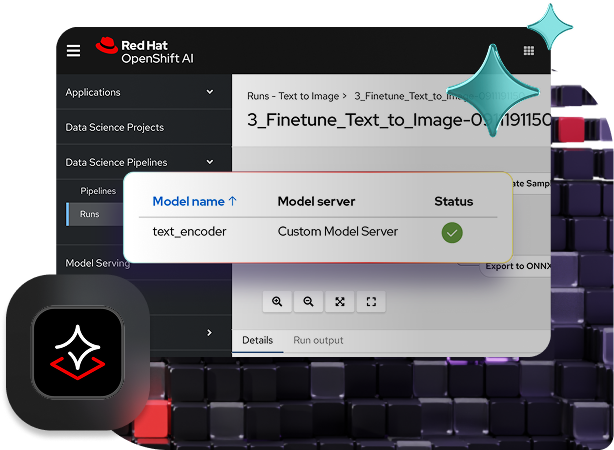

OpenShift AI semplifica l'acquisizione e la preparazione dei dati, l'addestramento e il fine tuning dei modelli, il model serving, il monitoraggio dei modelli e l'accelerazione dell'hardware. In combinazione con le soluzioni hardware e software offerte dall'ampio ecosistema di partner open source, OpenShift AI assicura tutta la flessibilità necessaria per affrontare scenari di utilizzo specifici.

Accelera il passaggio in produzione delle app basate sull'IA

Promuovi la collaborazione fra i team coniugando le funzionalità comprovate di Red Hat OpenShift AI e Red Hat OpenShift in un'unica piattaforma enterprise-ready per le applicazioni di IA. Operando su una piattaforma comune, data scientist, ingegneri e sviluppatori di app potranno beneficiare di maggiore coerenza, sicurezza e scalabilità.

L'ultima versione di OpenShift AI include un catalogo di modelli di terze parti ottimizzati, pronti per la produzione e convalidati per l'utilizzo con Red Hat OpenShift AI. Questi modelli di terze parti migliorano il controllo sull'accessibilità e sulla visibilità dei modelli e aiutano così a soddisfare i requisiti di sicurezza e delle policy.

Inoltre, grazie al suo framework vLLMottimizzato, OpenShift AI permette di ridurre i costi legati all'inferenza per il model serving distribuito. Contribuisce anche a ridurre la complessità operativa mettendo a disposizione strumenti avanzati per l'automazione dei deployment e l'accesso self service a modelli, strumenti e risorse.

Caratteristiche e vantaggi

Gestione semplificata dell'infrastruttura di IA

Usufruisci dell'accesso on demand ai modelli ad alte prestazioni che semplificano il self service, la scalabilità e il model serving. In questo modo si riduce la complessità, si migliora il controllo e si ottimizzano i costi.

La funzionalità Models-as-a-Service (MaaS), attualmente in anteprima per sviluppatori, permette di accedere ai modelli di IA tramite endpoint API, favorendo la confidenzialità e la distribuzione scalabile dell'IA.

Strumenti di AI/ML supportati e testati

Red Hat testa, integra e supporta gli strumenti di AI/ML e il model serving. OpenShift AI si basa sul progetto della community Open Data Hub e su altri progetti open source, come Kubeflow.

Grazie alla nostra lunga esperienza e alla nostra conoscenza dell'open source siamo in grado di offrire ai clienti una base flessibile, affidabile ed efficace che supporta le loro strategie di IA gen.

Flessibilità nel cloud ibrido

Disponibile come software autogestito o come servizio cloud completamente gestito su OpenShift, Red Hat OpenShift AI offre una piattaforma flessibile e sicura che permette di scegliere liberamente dove sviluppare e distribuire i modelli (on premise, nel cloud pubblico o all'edge).

Le procedure consigliate di Red Hat

Red Hat Services offre competenza, formazione e supporto per aiutare i clienti a superare le sfide poste dall'IA, a prescindere dal livello di automazione raggiunto in azienda.

Che si tratti di creare il prototipo di una soluzione di IA, ottimizzare il deployment della piattaforma di IA o perfezionare le strategie di MLOps, i clienti possono contare sull'assistenza del team Red Hat Consulting.

llm-d guida il lavoro degli sviluppatori

Red Hat OpenShift AI include llm-d, un framework open source che risolve le sfide dell'inferenza dell'IA distribuita su larga scala.

Garantire la scalabilità dei modelli su un insieme distribuito di GPU incrementa il controllo e l'osservabilità. Suddividendo la pipeline di inferenza in servizi modulari e intelligenti, le aziende possono ottimizzare gli LLM complessi su larga scala.

Server MCP per Red Hat OpenShift AI

Scopri il catalogo di server MCP offerti dai partner tecnologici che garantiscono l'integrazione lineare con Red Hat OpenShift AI.

Il Model Context Protocol (MCP) è un protocollo open source che consente la connessione bidirezionale e la comunicazione standardizzata tra le applicazioni di IA e i servizi esterni.

Le aziende possono sfruttare i server MCP per integrare gli strumenti e risorse aziendali nelle applicazioni di IA e nei flussi di lavoro di Agentic AI.

Ottimizza con vLLM per un'inferenza rapida, conveniente e scalabile.

Red Hat AI Inference Server è parte integrante della piattaforma Red Hat AI. È disponibile come prodotto standalone ed è incluso in Red Hat Enterprise Linux® AI e Red Hat OpenShift® AI.

Quando l'IA si adatta alle tue esigenze e alle tue condizioni.

IA generativa

Genera nuovi contenuti, come testi e codice software.

Red Hat AI ti consente di eseguire i modelli di IA generativa che preferisci, più velocemente, con meno risorse e costi di inferenza inferiori.

IA predittiva

Collega i modelli e prevedi i risultati futuri.

Con Red Hat AI le organizzazioni possono creare, addestrare, distribuire e monitorare i modelli predittivi, mantenendo la coerenza nel cloud ibrido.

Gestione operativa dell'IA

Crea sistemi che supportino la manutenzione e il deployment dell'IA in modo scalabile.

Con Red Hat AI puoi gestire e monitorare il ciclo di vita delle applicazioni basate sull'IA, risparmiando sulle risorse e garantendo la conformità alle normative sulla privacy.

Agentic AI

Crea flussi di lavoro che eseguono attività complesse con una supervisione limitata.

Red Hat AI offre un approccio flessibile e una base robusta per la creazione, la gestione e il deployment dei flussi di lavoro di Agentic AI all'interno delle applicazioni esistenti.

Partnership

Amplia le funzionalità di Red Hat OpenShift AI con altri servizi e prodotti integrati.

NVIDIA e Red Hat offrono una piattaforma scalabile e altamente flessibile con cui i clienti possono accelerare diversi scenari di utilizzo dell'IA.

Intel® e Red Hat aiutano le aziende a velocizzare l'adozione dell'IA e a semplificare l'esecuzione dei modelli di AI/ML.

IBM e Red Hat collaborano per offrire approcci open source innovativi in grado di velocizzare lo sviluppo dell'IA, in particolare grazie all'uso di IBM watsonx.aiTM, un componente enterprise-ready per la creazione dei modelli.

Starburst Enterprise e Red Hat migliorano la precisione e la rilevanza delle informazioni grazie all'analisi rapida dei dati distribuiti su più piattaforme.

Collaborazione negli ambienti di lavoro dei modelli

L'AI Hub e il Gen AI Studio favoriscono la collaborazione fra gli ingegneri della piattaforma e quelli dell'IA affinché possano rilasciare i modelli di IA gen in produzione più rapidamente.

L'AI Hub semplifica la gestione degli LLM centralizzando i carichi di lavoro di IA e fornendo informazioni sulle prestazioni derivanti da strumenti di convalida dei modelli di terze parti. Il Gen AI Studio offre un ambiente pratico dove gli utenti possono interagire con i modelli e creare rapidamente prototipi delle applicazioni di IA gen nell'interfaccia di test. Prima dell'integrazione nel ciclo di vita gli utenti possono anche verificare l'idoneità del modello grazie alla sandbox dove sperimentare i flussi di conversazione e retrieval augmented generation (RAG).

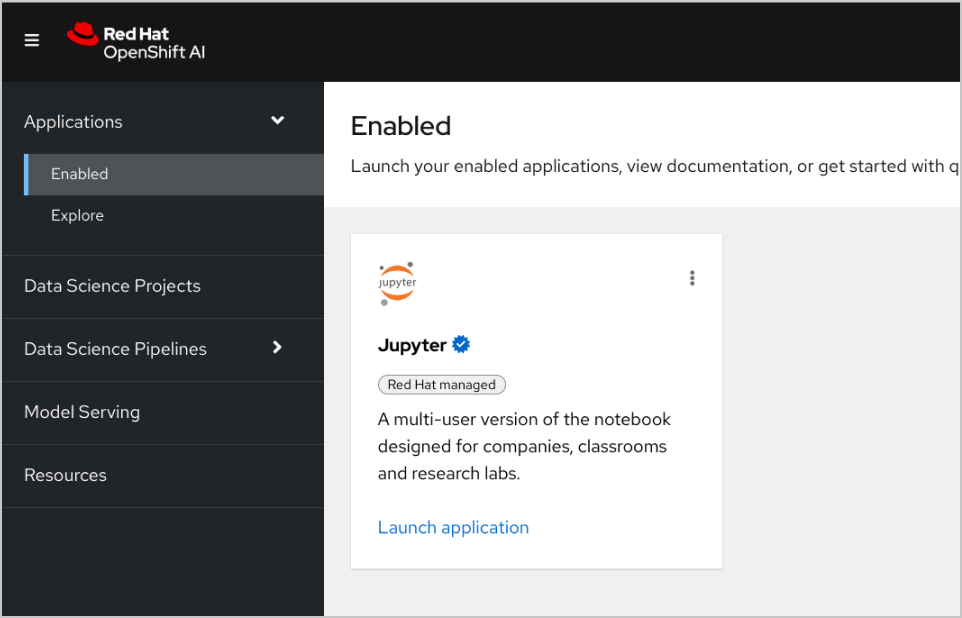

Inoltre, i data scientist possono accedere a immagini di cluster predefinite o personalizzate per lavorare sui modelli utilizzando l'IDE e i framework che preferiscono. Red Hat OpenShift AI tiene traccia delle modifiche a Jupyter, PyTorch, Kubeflow e ad altre tecnologie di IA open source.

Model serving e sicurezza scalabili con Red Hat OpenShift AI

I modelli si possono distribuire e integrare in applicazioni basate sull'IA on premise, nel cloud pubblico o all'edge utilizzando una versione ottimizzata di vLLM (o altri server dei modelli). Questi modelli si possono inoltre ricreare, ridistribuire e monitorare in base alle modifiche del notebook sorgente.

Le allucinazioni e i pregiudizi possono compromettere l'integrità e la scalabilità dei modelli. Per assicurare equità, sicurezza e scalabilità, OpenShift AI consente di monitorare l'allineamento tra gli output del modello e i dati di addestramento.

Gli strumenti di rilevamento dei drift sono in grado di monitorare quando i dati in tempo reale utilizzati per l'inferenza del modello si discostano dai dati di addestramento originali. Gli AI Guardrail sono presenti anche per proteggere gli input e gli output del modello da informazioni dannose, come discorsi offensivi e blasfemi, dati personali o restrizioni specifiche del dominio.

Analisi della soluzione

Applicazioni IA con Red Hat e NVIDIA AI Enterprise

Crea un'applicazione RAG

Red Hat OpenShift AI è una piattaforma per creare progetti di data science e distribuire applicazioni abilitate all'IA. Puoi integrare tutti gli strumenti che ti servono per supportare la tecnologia retrieval augmented generation (RAG), un metodo per ottenere le risposte dell'IA dai tuoi documenti di riferimento. Quando connetti OpenShift AI con NVIDIA AI Enterprise, puoi fare alcune prove con gli LLM (Large Language Model) per trovare il modello ideale per la tua applicazione.

Sviluppa una pipeline per i documenti

Se vuoi usare la tecnologia RAG, per prima cosa devi inserire i tuoi documenti in un database vettore. Nella nostra app di esempio, integriamo una serie di documenti di prodotto in un database Redis. Visto che questi documenti vengono modificati spesso, possiamo creare una pipeline da eseguire periodicamente per tale processo in modo da disporre sempre della versione più recente.

Sfoglia il catalogo degli LLM

NVIDIA AI Enterprise ti offre l'accesso a un catalogo di diversi modelli LLM, così potrai fare diverse prove e scegliere quello che offre risultati migliori. I modelli sono ospitati nel catalogo delle API di NVIDIA. Una volta che hai impostato un token API, puoi eseguire il deployment di un modello utilizzando la piattaforma di distribuzione dei modelli NVIDIA NIM direttamente da OpenShift AI.

Scegli il modello giusto

Mentre fai alcune prove con i diversi modelli LLM, i tuoi utenti possono valutare ogni risposta generata. Puoi configurare una dashboard di monitoraggio Grafana per confrontare le valutazioni, oltre che i tempi di risposta e di latenza di ogni modello. Potrai quindi sfruttare questi dati per scegliere il miglior modello LLM da usare nel tuo ambiente di produzione.

Storie dei clienti relative all'IA dall'evento Red Hat Summit e AnsibleFest 2025

Turkish Airlines ha raddoppiato i tempi di deployment grazie all'accesso ai dati in tutta l'organizzazione.

JCCM ha migliorato i processi di valutazione di impatto ambientale (VIA) della regione utilizzando l'IA.

DenizBank ha accelerato i tempi di rilascio passando da pochi giorni a pochi minuti.

Hitachi ha reso operativa l'IA nell'intera azienda con Red Hat OpenShift AI.

Come provare Red Hat OpenShift AI

Sandbox per sviluppatori

Per sviluppatori e data scientist che desiderano sperimentare la creazione di applicazioni basate sull'IA in un ambiente flessibile e predefinito.

Prova di 60 giorni

Non appena la tua organizzazione sarà pronta, esplora tutte le capacità di OpenShift AI con una versione di prova di 60 giorni. È necessario un cluster Red Hat OpenShift esistente.