Vous êtes chargé d'intégrer l'IA dans votre organisation, mais le parcours entre une preuve de concept et une application prête pour la production représente souvent un labyrinthe d'outils fragmentés et d'intégrations complexes, en particulier pour les cas d'utilisation de l'IA agentique. Le véritable défi n'est pas que d'ordre technologique. Il s'agit aussi d'élaborer une stratégie d'IA évolutive, fiable et gérable.

La standardisation constitue un facteur primordial pour relever ce défi, notamment parce qu'elle réduit la complexité et augmente l'efficacité. L'association de Model Context Protocol (MCP) et Llama Stack sur une plateforme telle que Red Hat OpenShift AI permet de créer un environnement unifié et portable pour vos applications d'IA.

La solution OpenShift AI peut également prendre en charge l'intégration de tous les autres cadres et composants agentiques que vous appréciez, y compris, entre autres, des outils tels que LangChain, LangGraph et CrewAI. L'approche de Red Hat permet de simplifier le développement, de rationaliser l'exploitation et de fournir à votre entreprise les outils nécessaires pour permettre à plusieurs équipes, comme les développeurs en IA et les data scientists, de concrétiser votre vision de l'IA dans un environnement fiable et cohérent.

La compréhension des éléments de base d'un agent intelligent

Pour créer des applications résilientes basées sur l'IA, il est nécessaire de disposer d'une base qui permet aux agents intelligents d'accéder aux outils et aux données spécifiques de votre entreprise et de les utiliser. Ce processus exige deux composants clés : une méthode standardisée pour exposer vos services et un cadre unifié pour interagir avec eux.

Cela constitue l'essence de l'IA agentique, où un système autonome est en mesure de déterminer un plan d'action pertinent et les outils nécessaires pour atteindre un objectif. La combinaison de MCP et Llama Stack fournit le cadre pour que ces agents puissent fonctionner efficacement.

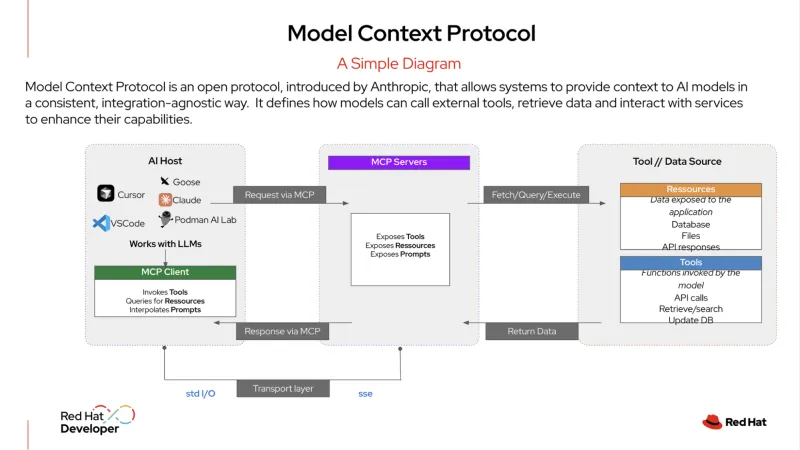

MCP constitue un protocole ouvert qui standardise la manière dont vos systèmes d’IA s’intègrent aux outils externes et aux sources de données. Il est souvent décrit comme un « port USB-C pour les applications d’IA ». De même que l'USB-C permet de brancher n'importe quel appareil compatible (un écran, un disque dur ou un clavier), un serveur MCP expose les services de votre organisation dans un format standardisé.

Un agent d'IA peut ensuite se connecter à ce serveur pour découvrir et utiliser les outils disponibles, qu'il s'agisse d'une base de données, d'un système de gestion de la relation client (CRM) ou d'une API interne. Ce protocole fournit aux agents d'IA un moyen structuré de se connecter aux services, ce qui leur permet d'obtenir facilement les informations dont ils ont besoin pour effectuer des tâches.

Llama Stack constitue une structure à code source ouvert qui fournit une approche unifiée et basée sur des API pour la création et le déploiement d’applications d’IA générative. Elle offre un moyen cohérent et portable de simplifier le développement et le déploiement de l'IA, et inclut une suite d'outils d'entreprise tels que des API pour l'inférence, la génération augmentée par récupération (RAG) et des agents d'IA. Elle inclut également des composants intégrés pour la sécurité, l'évaluation et l'observabilité, ce qui permet aux entreprises de créer des applications d'IA fiables, évolutives et prêtes pour la production.

Exemple d'IA agentique en action

En informatique d'entreprise, l'IA agentique peut gérer des flux de travail complexes à plusieurs étapes qui imposent des prises de décision dynamiques. Par exemple, au lieu d’une simple requête/réponse individuelle, un agent sophistiqué peut jouer le rôle de gestionnaire de centre d’assistance autonome, résolvant les problèmes avec une intervention humaine minimale.

Voici un exemple de ce que ce type d’agent peut faire lorsqu’un utilisateur envoie un ticket pour une « interruption de service »

- Llama Stack reçoit le ticket initial. Le système reçoit le rapport de l'utilisateur concernant une interruption de service et la catégorise en tant qu'incident de haute priorité.

- L'agent utilise MCP et élabore un plan. L'agent utilise le protocole MCP pour identifier et découvrir les outils pertinents auxquels il a accès, par exemple un service de surveillance, un outil d'analyse des journaux et un système d'automatisation des runbooks. Avec ce contexte du MCP, l’agent formule un plan en plusieurs étapes pour étudier et résoudre le problème.

- L'agent exécute le plan à l'aide de MCP pour communiquer avec les outils découverts.

- Il utilise d’abord un outil de surveillance pour vérifier l’état des services et des dépendances pertinents.

- Il appelle ensuite un outil d'analyse des journaux pour examiner les journaux récents d'une application connexe ou d'un conteneur Red Hat OpenShift à la recherche d'erreurs.

- Dès qu'un problème potentiel est identifié (par exemple, un pod qui tombe en panne), il utilise un outil de diagnostic pour identifier le problème sous-jacent, par exemple une politique réseau mal configurée ou un disque plein.

- L'agent prend des mesures correctives. Sur la base du diagnostic, il utilise MCP pour appeler un script de correction pré-approuvé afin de redémarrer le pod et de nettoyer l'espace disque. Il vérifie ensuite à nouveau l'état du service pour confirmer que le problème est résolu.

- L’agent communique le résultat. Il utilise un outil interne pour attribuer au ticket le statut « résolu », y compris un résumé des actions prises. L'agent envoie ensuite un message à l'utilisateur pour expliquer le problème et confirmer que le service est de nouveau en ligne, le tout sans intervention humaine.

L'utilisation du protocole MCP pour orchestrer ces actions permet à l'agent de fonctionner comme un centre d'assistance autonome qui élimine la charge manuelle des équipes informatiques et leur permet ainsi de se concentrer sur des initiatives stratégiques.

Une approche rationalisée du développement et de la production

La combinaison de Llama Stack et MCP améliore considérablement l'expérience de l'équipe de développement. Au lieu de développer pour une pile monolithique spécifique, vos développeurs peuvent utiliser une couche d'abstraction standardisée via une API unique. Cette approche permet l'adoption d'une méthode de développement en « boucle interne » efficace, qui permet de créer et tester des applications d'IA sur une machine locale à l'aide d'un seul SDK.

Comme les API sont cohérentes et que les services sont découverts via un protocole standardisé, vos développeurs ont l'assurance que leur application fonctionnera exactement de la même façon lorsqu'elle sera déployée sur une plateforme d'entreprise.

Cette portabilité constitue un élément essentiel dans l'environnement d'IA en constante évolution. Les développeurs peuvent concevoir leur application sur la base d'un seul modèle, et si un nouveau modèle offrant une performance accrue ou une rentabilité optimisée apparaît, ils peuvent y migrer sans avoir à réécrire leur code. En plus d'accélérer l'innovation, cette approche permet de réduire les délais et les efforts de développement, et d'établir une voie claire pour le passage du développement à la production.

Assurer la cohérence opérationnelle des charges de travail d'IA

Pour vos équipes d'exploitation, la gestion d'un large éventail de modèles et de services d'IA peut constituer une source majeure de complexité. Toutefois, l'exécution d'une pile d'IA standardisée et adaptée à votre entreprise sur une plateforme telle qu'OpenShift AI vous permet de bénéficier d'un environnement centralisé et cohérent.

OpenShift AI fournit une plateforme complète et fiable pour le déploiement et la mise à disposition des grands modèles de langage, ainsi que pour l'exécution des bases de données nécessaires aux applications RAG. Elle permet également à vos équipes de tirer parti de leurs architectures de microservices existantes et de se connecter facilement aux systèmes internes.

Vos équipes d'exploitation peuvent également utiliser leurs processus GitOps standard pour déployer et gérer ces applications d'IA. Ainsi, les mêmes flux de travail utilisés pour les applications natives du cloud traditionnelles peuvent être appliqués aux charges de travail d'IA, avec à la clé une simplification de la gestion et de la maintenance à grande échelle. Cette solution simplifie le passage du développement à la production et assure la cohérence de l'exploitation dans l'ensemble de vos environnements de cloud hybride.

En associant la puissance de technologies à code source ouvert telles que Llama Stack et MCP, et en permettant l'intégration d'autres cadres d'IA agentique tels que LangChain, Haystack, LlamaIndex et PydanticAI, la solution Red Hat AI fournit une base fiable pour la création, le déploiement et la gestion des applications d'IA dans l'ensemble de votre cloud hybride.

En savoir plus

Vous souhaitez vous lancer ? Apprenez-en plus sur Red Hat AI grâce à nos essais de produits, nos services de consulting, nos formations et certifications, et bien plus encore.

Ressource

L'entreprise adaptable : quand s'adapter à l'IA signifie s'adapter aux changements

À propos des auteurs

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.

Plus de résultats similaires

AI insights with actionable automation accelerate the journey to autonomous networks

Fast and simple AI deployment on Intel Xeon with Red Hat OpenShift

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Parcourir par canal

Automatisation

Les dernières nouveautés en matière d'automatisation informatique pour les technologies, les équipes et les environnements

Intelligence artificielle

Actualité sur les plateformes qui permettent aux clients d'exécuter des charges de travail d'IA sur tout type d'environnement

Cloud hybride ouvert

Découvrez comment créer un avenir flexible grâce au cloud hybride

Sécurité

Les dernières actualités sur la façon dont nous réduisons les risques dans tous les environnements et technologies

Edge computing

Actualité sur les plateformes qui simplifient les opérations en périphérie

Infrastructure

Les dernières nouveautés sur la plateforme Linux d'entreprise leader au monde

Applications

À l’intérieur de nos solutions aux défis d’application les plus difficiles

Virtualisation

L'avenir de la virtualisation d'entreprise pour vos charges de travail sur site ou sur le cloud