-

Produits et documentation Red Hat AI

Plateforme de produits et de services pour le développement et le déploiement de l'IA dans le cloud hybride.

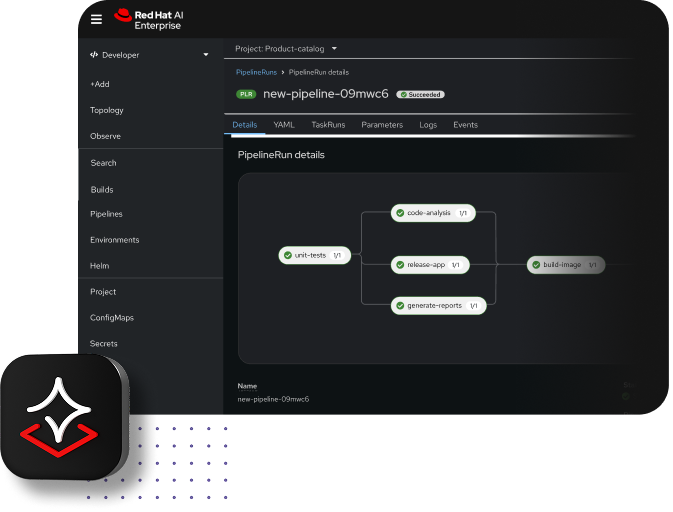

Red Hat AI Enterprise

Créez, développez et déployez des applications basées sur l'IA dans le cloud hybride.

Red Hat AI Inference Server

Optimisation des performances des modèles avec le vLLM pour des inférences rapides et rentables à grande échelle.

Red Hat Enterprise Linux AI

Développez, testez et exécutez des modèles d'IA générative avec des capacités d'inférence optimisées.

Red Hat OpenShift AI

Assemblage et déploiement de modèles et d'applications basés sur l'IA à grande échelle dans des environnements hybrides.

-

Se former Notions de base

Ressources techniques

-

Partenaires pour l'IA

Red Hat AI

Tirez parti de l'IA grâce aux ressources et aux informations dont vous disposez, en bénéficiant de toute la latitude dont vous avez besoin.

Basée sur des technologies Open Source, l'offre Red Hat® AI est conçue pour vous aider à concevoir et exécuter des solutions d'IA en toute confiance.

Red Hat AI facilite l'utilisation de l'IA pour les entreprises

Découvrez Red Hat AI Enterprise, une plateforme qui permet de passer de l'expérimentation à la mise à l'échelle mondiale de l'IA en toute simplicité. Compatible avec tous les modèles, sur tout type de matériel et d'environnement, elle offre des fonctionnalités d'inférence, de personnalisation des modèles, de déploiement et de gestion.

Vos modèles. Vos données. Vos choix.

Une exploitation optimale des applications d'IA requiert une inférence rapide et rentable. C'est pourquoi la gamme Red Hat AI fournit une plateforme unifiée et flexible, dotée de llm-d, un framework d'inférence distribuée à grande échelle.

Basé sur le succès de vLLM, llm-d s'appuie sur la valeur éprouvée de Kubernetes et assure un traitement cohérent et efficace, gage de performances prévisibles.

Outre l'efficacité, la transition vers l'IA agentique requiert un framework interopérable pour connecter les modèles, les données et les workflows d'IA dans l'ensemble du cloud hybride.

L'introduction d'une couche d'API unifiée basée sur une pile Llama ouvre la voie au développement d'une gamme étendue de fonctionnalités d'IA. Cette approche implique l'intégration du protocole MCP (Model Context Protocol), qui simplifie le déploiement et l'exploitation de l'IA agentique à grande échelle dans des environnements de production.

Mardi 17 février à 11h EST (16h UTC)

What's new and what's next with Red Hat AI

Rejoignez nos experts qui vous présenteront les dernières améliorations apportées à Red Hat AI.

Gamme Red Hat AI

La plateforme d'IA intégrée Red Hat AI Enterprise permet de déployer et gérer des modèles, agents et applications rentables et efficaces.

En plus d'unifier les cycles de vie des modèles et des applications, elle offre des fonctionnalités essentielles, telles que le réglage des modèles, l'inférence hautes performances et la gestion des workflows d'IA agentique. Cette plateforme flexible est compatible avec tout type de modèle et de matériel, dans tous les environnements.

Red Hat AI Inference Server optimise l'inférence des modèles dans le cloud hybride pour des déploiements plus rapides et rentables.

Optimisé par vLLM, ce serveur fournit un accès à des modèles tiers validés et optimisés sur Hugging Face. Il inclut en outre des outils de compression de LLM.

Red Hat OpenShift® AI s'appuie sur les fonctionnalités de Red Hat OpenShift pour fournir une plateforme d'IA fiable et évolutive qui permet d'entraîner, de régler, de déployer et de surveiller des modèles d'apprentissage automatique.

Red Hat Enterprise Linux® AI est une plateforme prête à l'emploi conçue pour l'exécution cohérente de grands modèles de langage (LLM) sur des serveurs individuels.

Elle inclut des fonctionnalités d'inférence exécutées sur le mode image qui permettent une inférence rapide et rentable dans le cloud hybride, tirant parti de vLLM pour optimiser le débit et réduire la latence.

Performances éprouvées pour des résultats concrets

Les solutions Red Hat AI permettent d'accéder à des modèles tiers prêts à l'emploi et validés, capables de s'exécuter efficacement avec vLLM sur notre plateforme.

Utilisez-les pour tester vos performances de modèles, optimiser l'inférence et explorer des pistes de simplification pour accélérer l'adoption de l'IA.

L'IA à votre service, selon vos conditions

IA générative

Produisez des contenus, comme du texte et du code logiciel.

La gamme Red Hat AI vous permet d'exécuter plus rapidement les modèles d'IA générative de votre choix, en utilisant moins de ressources et en réduisant les coûts d'inférence.

IA prédictive

Mettez en relation des schémas et prévoyez des résultats futurs.

Grâce à la gamme Red Hat AI, les entreprises peuvent développer, entraîner, surveiller et mettre à disposition des modèles prédictifs, tout en assurant la cohérence dans le cloud hybride.

Mise en œuvre de l'IA

Créez des systèmes qui prennent en charge la maintenance et le déploiement de l'IA à grande échelle.

Grâce à la gamme Red Hat AI, gérez et surveillez le cycle de vie des applications basées sur l'IA, tout en économisant des ressources et en garantissant la conformité avec les réglementations en matière de confidentialité.

IA agentique

Créez des workflows capables de réaliser des tâches complexes avec une supervision limitée.

La gamme Red Hat AI propose une approche flexible et une base solide pour concevoir, gérer et déployer des workflows d'IA agentique dans vos applications existantes.

Plus de partenaires pour l'IA. De nouvelles pistes d'innovation.

Nos clients bénéficient à la fois des connaissances de spécialistes et de technologies pour en faire plus avec l'IA. Divers partenaires technologiques s'efforcent d'obtenir une certification de compatibilité avec nos solutions.

Témoignages client du Red Hat Summit et d'AnsibleFest 2025 en lien avec l'IA

Avec un accès aux données à l'échelle de l'entreprise, Turkish Airlines a pu déployer des systèmes deux fois plus vite.

La JCCM a amélioré les processus d'évaluation environnementale de la région grâce à l'IA.

DenizBank a fait passer le délai de mise sur le marché de plusieurs jours à quelques minutes seulement.

Hitachi a mis en œuvre l'IA dans toutes ses activités avec Red Hat OpenShift AI.

Guides de démarrage rapide pour l'IA

Des exemples pratiques issus de notre communauté pour aider nos clients actuels à se lancer.

Red Hat AI en action

Ortec Finance accélère sa croissance et réduit le délai de mise sur le marché

Ortec Finance, fournisseur mondial de technologies et de solutions pour la gestion des risques et des rendements, distribue des modèles d'AA sur Microsoft Azure Red Hat OpenShift et adopte les solutions de la gamme Red Hat AI.

DenizBank donne plus d'autonomie à ses data scientists

DenizBank développe des modèles d'IA pour la gestion des emprunts de ses clients et la détection des fraudes. Depuis l'adoption de Red Hat AI, ses data scientists ont gagné en autonomie au niveau du contrôle des données.

Posez des bases fiables

Dans le monde entier, des entreprises utilisent notre gamme variée de solutions (infrastructures de cloud hybride, services d'applications, développement d'applications cloud-native et automatisation) pour distribuer des services informatiques sur toutes les infrastructures de manière rapide et économique.

Red Hat Enterprise Linux

Pour faciliter les déploiements d'applications sur site, à la périphérie du réseau et jusque dans le cloud, dans un environnement d'exploitation flexible

Red Hat OpenShift

Pour créer et déployer des applications à grande échelle tout en modernisant les anciennes

Red Hat Ansible

Automation Platform

Automation Platform

Pour créer, gérer et faire évoluer de façon dynamique les processus automatisés dans l'ensemble de l'entreprise

Red Hat AI

Pour personnaliser des modèles à taille réduite avec des données pertinentes pour l'entreprise, et pour développer et déployer des solutions d'IA dans des environnements de cloud hybride