O que são e para que servem as plataformas de inteligência artificial?

Uma plataforma de inteligência artificial (IA) é uma coleção integrada de tecnologias para desenvolver, treinar e executar modelos de machine learning (aprendizado de máquina). Isso normalmente envolve recursos de automação, operações de machine learning (MLOps), análise preditiva de dados e muito mais. Pense nisso como um workbench, que representa todas as ferramentas com as quais você precisa trabalhar, oferecendo uma base estável para criar e refinar soluções.

As plataformas de IA permitem que empresas e desenvolvedores criem aplicações alimentadas por inteligência artificial sem precisar gerenciar todas as complexidades subjacentes. Quando se trata de escolher uma plataforma de IA, há cada vez mais opções. Confira abaixo o que você deve buscar e considerar.

Tipos de plataformas de IA

A primeira decisão que a empresa terá que tomar em relação à plataforma de inteligência artificial é entre comprar uma opção pré-configurada ou criar uma plataforma personalizada internamente.

Compre uma plataforma de IA

Se você quiser implantar rapidamente aplicações de IA, modelos e algoritmos, a melhor opção é comprar uma plataforma abrangente e pré-configurada. Essas plataformas vêm com ferramentas, repositórios de linguagem e APIs previamente testadas, para garantir segurança e desempenho. Alguns fornecedores oferecem uma base previamente treinada e modelos de inteligência artificial generativa. Seus recursos de suporte e integração facilitam a adaptação aos ambientes e fluxos de trabalho.

Os provedores de nuvem mais conhecidos estão ampliando seus portfólios com plataformas de IA, incluindo Amazon Web Services (AWS) Sagemaker, Google Cloud AI Platform, Microsoft Azure AI Platform e watsonx.ai™ AI Studio da IBM. Em muitos casos, os provedores de plataforma de IA também oferecem ferramentas independentes que podem ser associadas e integradas a outras soluções de IA.

Crie uma plataforma de IA

Para atender a casos de uso específicos ou necessidades avançadas de privacidade, algumas empresas precisam personalizar e gerenciar sua própria plataforma de inteligência artificial. A Uber, por exemplo, desenvolveu uma plataforma de IA personalizada que usa tecnologias como NLP (Processamento de Linguagem Natural) e visão computacional para melhorar os recursos de GPS e detecção de colisões. A Syapse, uma empresa de saúde com foco em dados, criou o Syapse Raydar®, uma plataforma com tecnologia de IA que transforma dados de oncologia em insights acionáveis.

Ao criar uma plataforma de IA, você tem controle total sobre o ambiente e pode iterar conforme as necessidades específicas da sua empresa. No entanto, essa abordagem requer mais preparação antes de colocar a plataforma em funcionamento. A manutenção, o suporte e o gerenciamento não podem ser terceirizados.

Escolha soluções open source

As comunidades open source estão impulsionando os avanços em inteligência artificial e machine learning. Escolher uma solução open source como a base para suas iniciativas de inteligência artificial significa que você pode contar com uma comunidade de colegas e profissionais que aprimoram constantemente os frameworks e as ferramentas que você mais usa. Muitas empresas usam ferramentas open source como ponto de partida e começam a criar a partir delas. O Tensorflow e o PyTorch são plataformas open source que oferecem bibliotecas e frameworks para o desenvolvimento de aplicações de IA.

Acesse a biblioteca de conteúdos da Red Hat

Principais recursos

MLOps

As operações de machine learning (MLOps) são um conjunto de práticas de fluxo de trabalho destinadas a otimizar o processo de implantação e manutenção de modelos de machine learning (ML). Uma plataforma de inteligência artificial deve oferecer suporte para as fases de MLOps, como treinamento, disponibilização e monitoramento de modelos.

Large Language Model Operations (LLMOps) são um subconjunto do MLOps voltado às práticas, técnicas e ferramentas utilizadas para o gerenciamento operacional de grandes modelos de linguagem em ambientes de produção. Large Language Models (LLM) podem realizar tarefas como geração de texto, resumo de conteúdo e categorização de informações. No entanto, eles consomem uma grande quantidade de recursos computacionais das GPUs, o que significa que sua plataforma de IA precisa ter bastante capacidade de processamento para acomodar e suportar entradas e saídas de LLM.

IA generativa

A IA generativa depende de modelos de deep learning e redes neurais treinados com grandes conjuntos de dados para criar novos conteúdos. Com treinamento suficiente, o modelo consegue aplicar o aprendizado do treinamento e aplicá-lo a situações reais, o que é chamado de inferência de IA.

A inteligência artificial generativa abrange muitas das funções que os usuários finais associam à inteligência artificial, como geração de texto e imagem, aumento de dados, inteligência artificial conversacional (como chatbots) e muito mais. É importante que sua plataforma de IA ofereça suporte aos recursos de IA generativa com velocidade e precisão.

Escalabilidade

Os modelos de inteligência artificial só serão bem-sucedidos se forem escaláveis. Para escalar, as equipes de ciências de dados precisam de uma solução centralizada para criar e implantar modelos de IA, fazer testes e ajustes, além de colaborar com outras equipes. Tudo isso exige uma quantidade muito grande de dados e capacidade computacional e, mais importante, uma plataforma para administrar tudo.

Uma vez que os modelos sejam bem-sucedidos, você poderá reproduzi-los em diferentes ambientes: on-premises, em plataformas de nuvem pública e na edge. Uma solução escalável oferecerá suporte à implantação em todas essas áreas de ocupação.

Automação

Com o aumento na quantidade de modelos que sua organização deseja lançar, será necessário considerar a automação. Automatizar seus pipelines de ciência de dados permite transformar seus processos de maior sucesso em operações repetíveis. Isso não apenas acelera os fluxos de trabalho, mas incrementa a escalabilidade e gera experiências melhores e mais previsíveis para os usuários. Além disso, elimina tarefas repetitivas e dá mais tempo aos cientistas de dados e engenheiros para inovar, iterar e refinar.

Ferramentas e integrações

Desenvolvedores e cientistas de dados dependem de ferramentas e integrações para criar aplicações e modelos e implantá-los com eficiência. Sua plataforma de inteligência artificial precisa oferecer suporte às ferramentas, linguagens e repositórios que suas equipes já utilizam enquanto se integram a todo o seu stack de tecnologia e às soluções dos parceiros.

Segurança e regulamentações

Reduza os riscos e proteja seus dados, definindo práticas de segurança sólidas com sua plataforma de IA. Durante todas as operações diárias de treinamento e desenvolvimento, é essencial buscar vulnerabilidades e exposições comuns (CVEs) e definir uma proteção operacional para aplicações e dados por meio de gerenciamento de acesso, segmentação de rede e criptografia.

Responsabilidade e governança

Sua plataforma de IA também deve possibilitar que você use e monitore dados para cumprir com os padrões éticos e evitar violações de conformidade. Para proteger os dados da sua empresa e do usuário, é importante escolher uma plataforma que ofereça estratégias de visibilidade, rastreamento e gerenciamento de riscos por todo o ciclo de vida de ML. A plataforma também deve cumprir os padrões de segurança e conformidade de dados da sua empresa.

Suporte

Um dos benefícios mais importantes de uma plataforma de inteligência artificial pré-configurada e completa é o suporte que ela oferece. Seus modelos terão melhor desempenho com o rastreamento e a correção de erros escaláveis pelas implantações. Alguns provedores de plataforma de IA oferecem recursos de integração e treinamento para ajudar suas equipes a começar rapidamente. Quem prefere criar a própria plataforma com ferramentas open source talvez deva escolher fornecedores de suporte para infraestrutura e conjuntos de funções de machine learning.

Casos de uso

Telecomunicações

Os serviços de inteligência artificial abrangentes podem simplificar diferentes processos de telecomunicações, como a otimização do desempenho da rede e a melhoria da qualidade de produtos e serviços do setor. As aplicações incluem qualidade do serviço aprimorada, melhorias audiovisuais e prevenção de perda de clientes.

Setor de saúde

Uma plataforma de IA robusta pode transformar ambientes de saúde, proporcionando diagnósticos mais rápidos, avanços na pesquisa clínica e democratização dos serviços médicos. Tudo isso pode melhorar os resultados dos pacientes, porque ajuda os médicos e outros profissionais de saúde a oferecer diagnósticos e planos de tratamentos mais precisos.

Manufatura

A automação inteligente com machine learning está transformando a indústria por toda a cadeia de produção. A robótica industrial e a análise preditiva estão reduzindo a carga de tarefas repetitivas e implementando fluxos de trabalho mais eficazes em tempo real.

Como a Red Hat pode ajudar

Quando se trata de plataformas de inteligência artificial (IA), priorizamos criar soluções confiáveis e flexíveis em escala.

Red Hat® AI é nosso portfólio de produtos de inteligência artificial, desenvolvido com base em soluções em que nossos clientes confiam.

O Red Hat AI pode auxiliar as organizações a:

- Adotar a IA e inovar rapidamente.

- Reduzir as complexidades da entrega de soluções de inteligência artificial.

- Implante em qualquer ambiente.

Escale com flexibilidade

Se tudo estiver pronto para escalar, nossa plataforma do Red Hat AI oferece aos desenvolvedores ferramentas para criar, implantar e gerenciar aplicações com inteligência artificial.

Com colaboração contínua e suporte, você pode personalizar suas aplicações de modelo de IA para seus casos de uso empresariais com rapidez e facilidade.

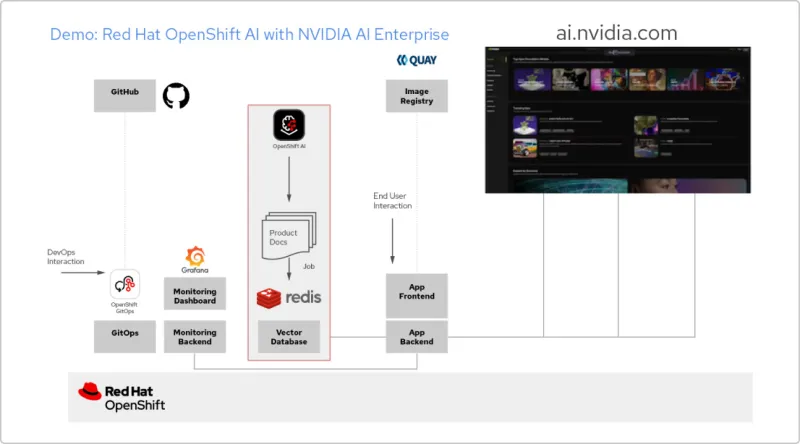

Apps de IA com a Red Hat e o NVIDIA AI Enterprise

Crie uma aplicação com RAG

O Red Hat OpenShift AI é uma plataforma para criar projetos de ciência de dados e disponibilizar aplicações com IA. Você pode integrar todas as ferramentas para dar suporte à Geração Aumentada por Recuperação (RAG), um método para receber respostas da IA a partir dos seus próprios documentos de referência. Quando você conecta o OpenShift AI ao NVIDIA AI Enterprise, é possível testar large language models (LLMs) para encontrar o melhor modelo para sua aplicação.

Crie um pipeline de documentos

Para usar a RAG, primeiro você precisa ingerir seus documentos em um banco de dados vetorial. Na nossa app de exemplo, inserimos um conjunto de documentos da solução em um banco de dados do Redis. Como esses documentos mudam com frequência, criamos um pipeline para esse processo que executaremos periodicamente. Dessa forma, sempre teremos as versões mais recentes dos documentos.

Confira o catálogo de LLM

O NVIDIA AI Enterprise oferece um acesso a um catálogo de diferentes LLMs para que você tenha opções diversas e selecione o modelo com os melhores resultados. Os modelos são hospedados no catálogo da API da NVIDIA. Depois de configurar um token de API, é possível implantar um modelo usando o NVIDIA NIM que disponibiliza a plataforma diretamente a partir do OpenShift AI.

Como escolher o modelo ideal

Conforme você testa LLMs diferentes, seus usuários podem avaliar cada resposta gerada. Você pode configurar um dashboard de monitoramento do Grafana para comparar as avaliações e o tempo de resposta e latência de cada modelo. Depois, use esses dados para escolher o melhor LLM para a produção.

Introdução à IA empresarial: um guia para iniciantes

Leia este guia para iniciantes e descubra como o Red Hat OpenShift AI e o Red Hat Enterprise Linux AI podem ajudar a acelerar sua jornada de adoção da inteligência artificial.