The real estate bubble of 2008 made shockwaves worldwide. This was so significant an event that the US economy only this year was determined to have recovered to pre-bubble levels. But this event also resulted in all sorts of other shockwaves -- regulatory ones.

To address these regulatory needs for Wall Street, Red Hat Storage teamed up with Hortonworks to build an enterprise grade big data risk management solution. At the recent Strata+Hadoop World, Vamsi Chemitiganti (chief architect, financial services) presented the solution in a session -- which you can see for yourself at the bottom of this post.

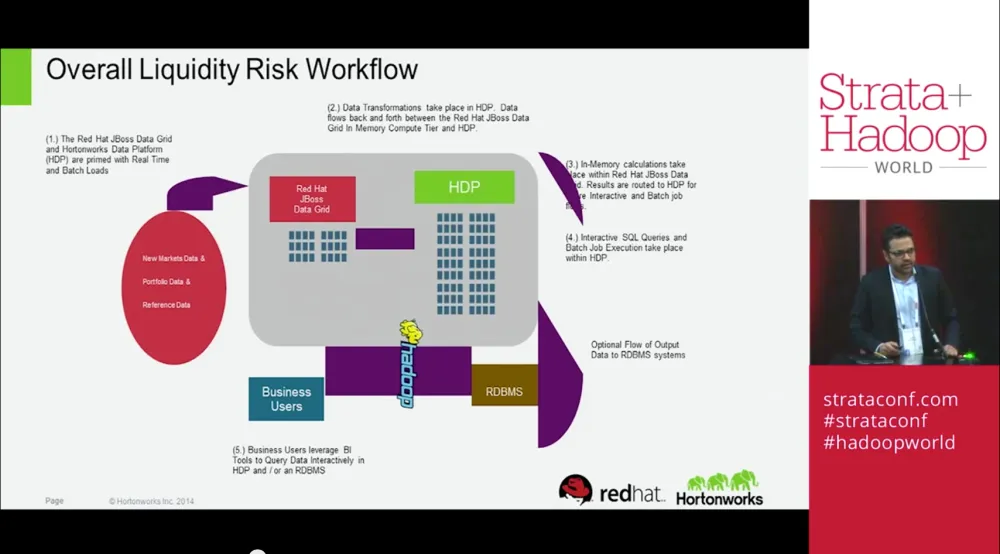

The slide does a great job of breaking down the workflow. To spare your eyes, here are the steps:

- The Red Hat JBoss Data Grid and Hortonworks Data Platform (HDP) are primed with Real Time and Batch Loads

- Data Transformations take place in HDP. Data flows back and forth between the Red Hat JBoss Data Grid in Memory Compute Tier and HDP

- In-Memory calculations take place within Red Hat JBoss Data Grid. Results are routed to HDP where Interactive and Batch job loads

- Interactive SQL Queries and Batch Job Execution take place within HDP

- Business users leverage business intelligence tools to query data interactive in HDP and/or a relational database management system (RDBMS).

Check out the full session right here:

저자 소개

채널별 검색

오토메이션

기술, 팀, 인프라를 위한 IT 자동화 최신 동향

인공지능

고객이 어디서나 AI 워크로드를 실행할 수 있도록 지원하는 플랫폼 업데이트

오픈 하이브리드 클라우드

하이브리드 클라우드로 더욱 유연한 미래를 구축하는 방법을 알아보세요

보안

환경과 기술 전반에 걸쳐 리스크를 감소하는 방법에 대한 최신 정보

엣지 컴퓨팅

엣지에서의 운영을 단순화하는 플랫폼 업데이트

인프라

세계적으로 인정받은 기업용 Linux 플랫폼에 대한 최신 정보

애플리케이션

복잡한 애플리케이션에 대한 솔루션 더 보기

가상화

온프레미스와 클라우드 환경에서 워크로드를 유연하게 운영하기 위한 엔터프라이즈 가상화의 미래