Was ist Retrieval-Augmented Generation?

Retrieval-Augmented Generation (RAG) ist eine Methode zur Verbesserung der Qualität und Relevanz von Antworten aus einer generativen KI-Anwendung. Dabei wird das vorab trainierte Wissen eines Large Language Models (LLM) mit externen Ressourcen verknüpft. Diese Ressourcen werden dann segmentiert, in einer Vektordatenbank indiziert und als Referenzmaterial zur Extraktion für das LLM zur Lieferung genauerer Antworten genutzt.

RAG ist deshalb so hilfreich, weil es das LLM anweist, spezifische aktuelle Informationen aus Ihren ausgewählten Sources of Truth abzurufen. Zu diesen Quellen zählen Daten-Repositories, Textsammlungen oder bereits vorhandene Dokumentation.

Unternehmen können außerdem mit RAG Geld sparen, da es ein Kundenerlebnis bereitstellt, ohne dass Ausgaben für das Training und Fine Tuning eines Modells anfallen. Auch Ressourcen lassen sich so sparen, da damit bei der Abfrage eines LLM statt umfassender Dokumente nur die relevantesten Informationen gesendet werden.

RAG im Vergleich zu regulären LLM-Ausgaben

LLMs nutzen Machine Learning- und NLP-Techniken (Natural Language Processing), um menschliche Sprache zu verstehen und zu generieren. KI-Inferenz bezeichnet die operative Phase von KI, in der das Modell das im Training Gelernte auf reale Situationen anwenden kann.

LLMs können zwar im Bereich Kommunikation und Datenverarbeitung von unglaublichem Nutzen sein, bringen aber auch Nachteile mit sich:

- LLMs werden mit allgemein verfügbaren Daten trainiert, die aber möglicherweise nicht die konkreten Informationen enthalten, auf die sie sich beziehen sollen, etwa interne Daten Ihres Unternehmens.

- LLMs haben einen Wissensstichtag, das heißt, dass die Informationen, mit denen sie trainiert wurden, nicht kontinuierlich aktualisiert werden. Dadurch kann es passieren, dass diese Quellen irgendwann veraltet und nicht mehr relevant sind.

- LLMs wollen gefallen. Statt keine Antwort auszugeben, präsentieren sie daher manchmal falsche oder veraltete Informationen, auch bekannt als „Halluzinationen“.

Wenn Sie eine RAG-Architektur in ein LLM-basiertes Frage-Antwort-System implementieren, ermöglichen Sie die Kommunikation zwischen dem LLM und den von Ihnen ausgewählten zusätzlichen Wissensquellen. Das LLM ist in der Lage, Querverweise zu ziehen und sein internes Wissen zu ergänzen. So bietet es Nutzenden eine zuverlässigere und genauere Ausgabe zu ihrer Abfrage.

Red Hat Ressourcen

Welche Vorteile bietet RAG?

Mit den Abfragemechanismen einer RAG-Architektur lassen sich zusätzliche Datenquellen nutzen, die über das allgemeine Training eines LLM hinausgehen. Wenn Sie Ihr LLM über RAG auf eine Basis aus externen, überprüfbaren Fakten aufsetzen, bietet das verschiedene Vorteile:

Genauigkeit

RAG stellt einem LLM Quellen zur Verfügung, die es zitieren kann, damit Nutzende diese Behauptungen überprüfen können. Sie können eine RAG-Architektur auch so gestalten, dass sie mit „Ich weiß es nicht“ auf eine Frage antwortet, die von ihrem Wissen nicht abgedeckt ist. Da RAG insgesamt die Wahrscheinlichkeit reduziert, dass ein LLM falsche oder irreführende Information ausgibt, kann es das Vertrauen bei Nutzenden erhöhen.

Kosteneffizienz

Das Retraining und Fine Tuning von LLMs ist kostspielig und zeitaufwendig. Das Gleiche gilt, wenn Sie ein Basismodell von Grund auf entwickeln und mit domainspezifischen Information trainieren, etwa um einen Chatbot zu entwerfen. Mit RAG können Nutzende nicht nur neue Daten in ein LLM eingeben, sondern auch Informationsquellen austauschen oder aktualisieren, indem sie einfach nur ein Dokument oder eine Datei hochladen.

RAG kann auch Inferenzkosten reduzieren. LLM-Abfragen sind teuer. Bei einem lokalen Modell beanspruchen sie Ihre eigene Hardware, und wenn Sie einen externen Service über eine API (Application Programming Interface) nutzen, summiert sich der gemessene Verbrauch in Ihrer Rechnung. Anstatt ein ganzes Referenzdokument auf einmal an ein LLM zu senden, lassen sich mit RAG lediglich die relevanten Blöcke des Referenzmaterials senden, was die Größe von Abfragen reduziert und so die Effizienz verbessert.

Kontrollmöglichkeiten bei der Entwicklung

Verglichen mit traditionellen Fine Tuning-Methoden bietet RAG eine verständlichere und unkompliziertere Möglichkeit, Feedback zu erhalten, Troubleshooting durchzuführen und Probleme bei Anwendungen zu beheben. Der Hauptvorteil von RAG-Architekturen für Entwicklungsteams besteht darin, dass sie damit von domainspezifischen und aktualisierten Informationen profitieren.

Datensouveränität und Datenschutz

Vertrauliche Informationen für das Fine Tuning eines LLM-Tools zu nutzen, war bisher immer ein riskantes Unterfangen, da LLMs Informationen aus ihren Trainingsdaten preisgeben können. RAG bietet eine Lösung für diese datenschutzrechtlichen Bedenken, da damit vertrauliche Informationen vor Ort verbleiben können, selbst wenn sie für ein lokales LLM oder ein vertrauenswürdiges externes LLM genutzt werden. Eine RAG-Architektur kann auch so eingerichtet werden, dass der Abruf vertraulicher Informationen auf verschiedene Autorisierungsstufen beschränkt wird. Abhängig von ihrer Stufe bei der Sicherheitsüberprüfung können bestimmte Nutzende dann nur auf bestimmte Informationen zugreifen.

Wie funktioniert RAG?

RAG-Architekturen rufen Daten von externen Quellen ab, verarbeiten sie im Kontext eines LLM und generieren dann basierend auf dem Mix an Quellen eine Antwort. Dieser Prozess umfasst 3 Hauptphasen: Datenvorbereitung, Abruf und Generierung.

Schritt 1: Datenvorbereitung (für den Abruf)

- Beschaffen und Laden von Dokumentation: Ermitteln und beschaffen Sie die Quelldokumente, die Sie mit dem LLM teilen wollen. Dabei sollten Sie sicherstellen, dass diese in einem für das LLM verständlichen Format gespeichert sind. Das sind oft Textdateien, Datenbanktabellen oder PDFs. Abgesehen vom Quellformat müssen die Dokumente außerdem in eine Textdatei konvertiert werden, bevor sie in die Vektordatenbank eingebettet werden können. Dieser Prozess ist auch bekannt als ETL (Extract, Transform, Load). ETL stellt sicher, dass die Rohdaten bereinigt und für die Anforderungen von Storage, Analyse und Machine Learning strukturiert sind.

Transformieren: Durch „Text Splitting“ oder „Chunking“, also das Aufteilen des Texts in Blöcke, werden die Dokumente für den Datenabruf vorbereitet. Dabei werden die aktualisierten Dokumente geparst und basierend auf bestimmten Merkmalen in zusammengehörigen „Chunks“ oder Blöcken katalogisiert. So ist es etwa für das Modell möglicherweise einfacher, Dokumente zu durchsuchen und abzurufen, die nach Absätzen formatiert sind, als Dokumente mit Tabellen und Abbildungen.

Chunking kann nach Aspekten wie Semantik, Sätze, Tokens, Formatierung, HTML-Zeichen oder Codetyp erfolgen. Viele Open Source-Frameworks können Unternehmen bei der Aufnahme von Dokumenten unterstützen, darunter LlamaIndex und LangChain.

Einbetten: Einbettungen nutzen ein spezialisiertes ML-Modell (ein Vektoreinbettungsmodell), das Daten in numerische Vektoren umwandelt. Dadurch können Sie mathematische Operationen anwenden, um Gemeinsamkeiten und Unterschiede zwischen Daten zu bestimmen. Mithilfe von Einbettung können Sie Text (oder Bilder) in einen Vektor umwandeln, der die wesentliche Bedeutung des Inhalts erfasst und unwichtige Details aussondert. Beim Einbettungsprozess könnte einem Datenblock etwa ein numerischer Wert wie [1,2, -0,9, 0,3] zugeordnet werden, mit dem er dann in einem größeren System indiziert wird, der sogenannten Vektordatenbank.

Die RAG-Architektur kann dank dieser numerischen Werte in der Vektordatenbank Assoziationen zwischen den Blöcken von Inhalten einfacher kennzeichnen und die Daten besser organisieren, um so das Abrufen zu optimieren. Ziel der Indexierung ist, die Vektoren so zu strukturieren, dass ähnliche Konzepte in benachbarten Koordinaten gespeichert werden. So würden etwa „Kaffee“ und „Tee“ eng beieinander positioniert werden. Auch „Heißgetränk“ wäre in der Nähe. Konzepte wie „Handy“ und „Fernseher“, die in keinem Zusammenhang dazu stehen, würden weiter weg positioniert werden. Die Distanz oder Nähe zwischen 2 Vektorpunkten hilft dem Modell bei der Entscheidung, welche Informationen es abrufen und in der Ausgabe für die Nutzeranfrage mit einbeziehen soll.

- Speichern: Die gebündelten Daten aus mehreren Quellen – die von Ihnen ausgewählten externen Dokumente und das LLM – werden in einem zentralen Repository gespeichert.

Schritt 2: Abruf

Wenn die Daten in der Vektordatenbank katalogisiert sind, suchen Algorithmen darin nach Informationsschnipseln, die für die Nutzerabfrage relevant sind, und rufen diese dann ab. Frameworks wie LangChain unterstützen viele verschiedene Abrufalgorithmen, darunter solche, die auf Gemeinsamkeiten bei Daten basieren, wie etwa Semantik, Metadaten oder übergeordnete Dokumente.

Wenn Endbenutzende in offenen Domains Informationen abfragen, stammen diese von indizierten Dokumenten im Internet. Der Zugriff darauf erfolgt dabei über die API der Informationsquelle. In geschlossenen Domains von Unternehmen hingegen, wo Informationen vertraulich behandelt und vor externen Quellen geschützt werden müssen, kann der Abruf über eine RAG-Architektur lokal erfolgen und so für mehr Sicherheit sorgen.

Zum Schluss werden die abgerufenen Daten in den Prompt eingefügt und zur Verarbeitung an das LLM gesendet.

Schritt 3: Generierung

- Ausgabe: Den Nutzenden wird eine Antwort präsentiert. Wenn die RAG-Methode wie beabsichtigt funktioniert, erhalten die Nutzenden eine genaue Antwort auf Grundlage des als Quelle bereitgestellten Wissens.

Best Practices und wichtige Aspekte von RAG

Für die optimale Funktion von RAG sind Effizienz und Standardisierung die Voraussetzung.

vLLM ist ein Inferenzserver und eine Engine, die LLMs dabei hilft, Berechnungen in großem Umfang effektiver durchzuführen. vLLM verwendet eine Technik namens Paged Attention zur Arbeitsspeicherverwaltung, die die Latenz (Verzögerung) bei der endgültigen Antwort reduziert. Diese Geschwindigkeit und Effizienz machen vLLM ideal für den Einsatz im „Generierungs“-Teil eines RAG-Systems, um sicherzustellen, dass Nutzende ihre Antwort so schnell wie möglich erhalten.

Um eine Datenstandardisierung in der gesamten RAG-Pipeline zu erreichen, sollten Sie die Verwendung des Model Context Protocol (MCP) in Betracht ziehen. MCP ermöglicht dem RAG-System den Zugriff auf verschiedene externe Datenquellen, ohne dass individuelle, komplexe Integrationen erstellt werden müssen. Durch die Schaffung einer standardisierten Schnittstelle mit MCP kann ein RAG-System einfacher skaliert und gewartet werden, wenn neue Datenquellen eingeführt werden.

Bei der Entwicklung eines ML-Modells ist es wichtig, qualitativ hochwertige Quelldokumente zu finden, da die Ausgabe nur so gut sein kann wie die Daten Ihrer Eingabe. Systeme, die verzerrte oder einseitige Informationen erzeugen, sind ein ernst zu nehmendes Problem für Unternehmen, die KI nutzen. Um solche Verzerrungseffekte in Ihrer Ausgabe zu vermeiden, sollten Sie unbedingt darauf achten, dass Ihre Quelldokumente keine voreingenommenen Informationen enthalten – also einseitige Darstellungen, die privilegierten Gruppen einen systematischen Vorteil und unprivilegierten Gruppen einen systematischen Nachteil verschaffen.

Stellen Sie beim Beschaffen von Daten für eine RAG-Architektur auch sicher, dass die Daten in Ihren Quelldokumenten ordnungsgemäß zitiert wurden und aktuell sind. Zusätzlich sollten menschliche Fachkräfte die Ausgabe bewerten, bevor Sie ein Modell für ein größeres Publikum bereitstellen. Und selbst nach dem Deployment des Modells in der Produktion sollte die Qualität der Ergebnisse weiterhin von solchen Fachkräften bewertet werden.

Was unterscheidet RAG von anderen Methoden zum Trainieren und Verarbeiten von Daten?

Sich die Unterschiede zwischen Datentrainingsmethoden und RAG-Architekturen deutlich zu machen, kann Ihnen dabei helfen, strategische Entscheidungen zum Einsatz der passenden KI-Ressource für Ihre Anforderungen zu treffen. Dabei ist es gut möglich, dass Sie gleichzeitig mehrere Methoden einsetzen. Im Folgenden sehen wir uns daher einige gängige Methoden und Prozesse für die Arbeit mit Daten an und vergleichen sie mit RAG.

RAG im Vergleich zu Prompt Engineering

Prompt Engineering ist die einfachste und am wenigsten technische Weise, mit einem LLM zu interagieren. Prompt Engineering beinhaltet das Schreiben von Anweisungen, das ein Modell in einer bestimmten Reihenfolge ausführen soll, damit bei einer Nutzeranfrage eine gewünschte Ausgabe generiert wird. Verglichen mit RAG erfordert Prompt Engineering weniger Daten, da es nur diejenigen nutzt, mit denen das Modell vorab trainiert wurde, und ist kostengünstiger, da es nur vorhandene Tools und Modelle nutzt. Es ist jedoch nicht in der Lage, Ausgaben anhand von aktuellen oder sich ändernden Informationen zu generieren. Die Qualität der Ausgabe hängt außerdem von der Formulierung des Prompts ab, sodass es zu inkonsistenten Antworten kommen kann.

Wenn Sie nach einer nutzungsfreundlichen und kosteneffizienten Möglichkeit suchen, Informationen zu allgemeinen Themen ohne viele Einzelheiten zu extrahieren, kann Prompt Engineering für Sie die bessere Wahl sein.

RAG im Vergleich zu semantischer Suche

Semantik bezieht sich auf die wissenschaftliche Beschäftigung mit der Bedeutung von Wörtern. Die semantische Suche ist eine Methode zum Parsen von Daten, die den Zweck und Kontext einer Suchanfrage berücksichtigt.

Dabei werden NLP und Machine Learning genutzt, um die Anfrage zu entschlüsseln und Daten zu finden, die eine sinnvollere und genauere Antwort liefern als die, die ein simpler Schlüsselwortabgleich bereitstellen würde. Mit anderen Worten: Mit der semantischen Suche kann die Lücke geschlossen werden, die zwischen der Nutzeranfrage und den zur Generation einer Antwort verwendeten Daten besteht.

Wenn Sie beispielsweise eine Anfrage zu einem „Traumurlaub“ tippen, würde das Modell dank der semantischen Suche verstehen, dass Sie vermutlich Informationen zu einem „idealen“ Urlaub wollen. Statt eine Antwort zu Träumen zu liefern, würde das Modell Ihnen eine Antwort geben, die für Ihre Absicht mehr Relevanz hat – etwa ein All-inclusive-Paket für einen Strandurlaub.

Die semantische Suche ist ein Teil von RAG, und RAG nutzt sie während der Abfrage der Vektordatenbank, um Ergebnisse zu erzeugen, die sowohl für den Kontext richtig und genau als auch aktuell sind.

RAG im Vergleich zu Pretraining

Beim Pretraining handelt es sich um die Anfangsphase des LLM-Trainings, bei der das LLM von einem sehr großen Datensatz lernt und so ein grobes Verständnis der Sprache erlangt. Ähnlich dem menschlichen Gehirn, das Nervenbahnen aufbaut, wenn wir neue Dinge lernen, wird beim Pretraining ein neuronales Netzwerk in einem LLM erstellt, wenn dieses mit Daten trainiert wird.

Verglichen mit RAG ist das Pretraining eines LLM teurer, kann länger dauern und mehr Rechenressourcen erfordern – etwa Tausende von GPUs. Wenn Sie Zugriff auf einen wirklich umfassenden Datensatz haben, der das trainierte Modell bedeutend beeinflussen kann, und Ihrem LLM ein integriertes, grundlegendes Verständnis bestimmter Themen oder Konzepte geben wollen, kann Pretraining die bessere Wahl für Sie sein.

RAG im Vergleich zu Fine Tuning

RAG-Architektur definiert, was ein LLM wissen muss. Fine Tuning hingegen definiert, wie das Modell reagieren soll. Fine Tuning beschreibt den Prozess, ein vortrainiertes LLM mit einem kleineren, gezielteren Datensatz weiterzutrainieren. Dadurch kann das Modell allgemeine Muster erlernen, die sich nicht mit der Zeit verändern.

Oberflächlich betrachtet scheinen sich RAG und Fine Tuning zu ähneln, es gibt aber Unterschiede. So sind beim Fine Tuning für die Modellerstellung beispielsweise sehr viele Daten und erhebliche Rechenressourcen erforderlich, es sei denn, Sie nutzen PEFT-Techniken (parametereffizientes Fine Tuning).

RAG hingegen kann Informationen aus einem einzigen Dokument abrufen und bedarf sehr viel weniger Rechenressourcen. Darüber hinaus ist es viel zeitaufwendiger und schwieriger, Halluzinationen durch Fine Tuning eines LLM zu reduzieren, während sich RAG in dieser Hinsicht als sehr effektiv erwiesen hat.

Oft ist es für ein Modell von Vorteil, sowohl Fine Tuning als auch RAG-Architektur zu nutzen. Wenn Sie jedoch bereits Zugriff auf eine enorm große Menge an Daten und Ressourcen haben und diese Daten sich relativ selten oder wenig ändern, oder wenn Sie an einer spezialisierten Aufgabe arbeiten, die eine individuellere Analyse als die des Frage-Antwort-Formats von RAG erfordert, kann Fine Tuning für Sie besser geeignet sein.

Use Cases für RAG

Es gibt viele potenzielle Use Cases für eine RAG-Architektur. Im Folgenden beleuchten wir einige der gängigsten.

Kundenservice: Durch das Programmieren eines Chatbots, der Kundenanfragen anhand wichtiger Informationen aus einem bestimmten Dokument beantwortet, lassen sich Servicetickets schneller abwickeln, was auch zu einem effektiveren Kundensupportsystem führt.

Generieren von Erkenntnissen: Mit RAG können Sie aus bereits vorhandenen Dokumenten lernen. Nutzen Sie eine RAG-Architektur, um ein LLM mit Jahresberichten, Marketingdokumenten, Social Media-Beiträgen, Kundenbewertungen, Umfrageergebnissen, Forschungsdokumenten oder anderen Materialien zu verknüpfen. Sie finden dann Antworten, die Ihnen dabei helfen, Ihre Ressourcen besser zu verstehen. Sie können RAG auch direkt mit Live-Datenquellen verbinden, etwa Social Media-Feeds, Websites oder andere häufig aktualisierte Quellen. Dadurch können Sie hilfreiche Antworten in Echtzeit generieren.

Informationssysteme im Gesundheitswesen: RAG-Architekturen können Systeme verbessern, die medizinische Informationen oder Empfehlungen bereitstellen. RAG bietet die Möglichkeit, Aspekte wie die persönliche medizinische Vorgeschichte, Terminplanungsservices und neueste medizinische Forschung und Richtlinien zu prüfen, und kann so das Gesundheitswesen dabei unterstützen, Patientinnen und Patienten mit den erforderlichen Services und Supportstellen zu vernetzen.

Wie Red Hat helfen kann

Red Hat® AI, unser KI-Produktportfolio, basiert auf den vertrauenswürdigen Lösungen, die unsere Kunden bereits nutzen. Dank dieser Basis bleiben unsere Produkte auch weiterhin zuverlässig, flexibel und skalierbar.

Mit Red Hat AI können Unternehmen:

- KI schnell einführen und Innovationen schaffen

- Die Komplexitäten beim Bereitstellen von KI-Lösungen umgehen

- KI in vielen verschiedenen Umgebungen bereitstellen

Zusammenarbeit und Kontrolle von Entwicklungsteams

Mit den KI-Lösungen von Red Hat können Unternehmen die RAG-Architektur in ihren LLMOps-Prozess implementieren, indem sie die zugrunde liegende Workload-Infrastruktur bereitstellen.

Insbesondere Red Hat® OpenShift® AI– eine flexible, skalierbare MLOps-Plattform – bietet Entwicklungsteams die Tools zum Entwickeln, Bereitstellen und Verwalten KI-fähiger Anwendungen. Sie stellt die zugrunde liegende Infrastruktur zur Unterstützung einer Vektordatenbank bereit, erstellt Einbettungen, fragt LLMs ab und verwendet die Abrufmechanismen, die zum Erzielen eines Ergebnisses erforderlich sind.

Durch eine unterstützte kontinuierliche Zusammenarbeit können Sie Ihre KI-Modellanwendungen schnell und einfach an die Use Cases Ihres Unternehmens anpassen.

Lösungs-Pattern: KI-Apps mit Red Hat und NVIDIA AI Enterprise

Entwickeln einer RAG-Anwendung

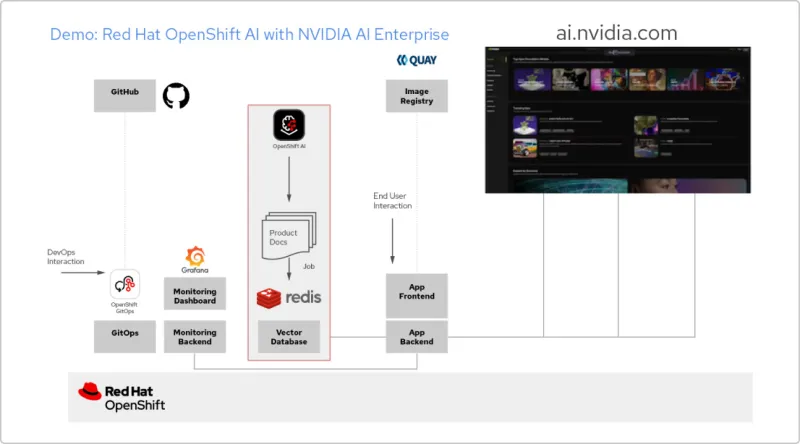

Red Hat OpenShift AI ist eine Plattform für das Entwickeln von Data Science-Projekten und das Bereitstellen KI-gestützter Anwendungen. Sie können sämtliche Tools integrieren, die für die Unterstützung von Retrieval-Augmented Generation (RAG), einer Methode zum Abrufen von KI-Antworten aus Ihren eigenen Referenzdokumenten, erforderlich sind. Wenn Sie OpenShift AI mit NVIDIA AI Enterprise kombinieren, können Sie mit Large Language Models (LLMs) experimentieren und so das optimale Modell für Ihre Anwendung finden.

Erstellen einer Pipeline für Dokumente

Damit Sie RAG nutzen können, müssen Sie Ihre Dokumente zunächst in eine Vektordatenbank aufnehmen. In unserer Beispielanwendung integrieren wir mehrere Produktdokumente in eine Redis-Datenbank. Da sich diese Dokumente häufig ändern, können wir für diesen Prozess eine Pipeline erstellen, die wir regelmäßig ausführen, damit wir immer die aktuellen Versionen der Dokumente zur Verfügung haben.

Durchsuchen des LLM-Katalogs

Mit NVIDIA AI Enterprise können Sie auf einen Katalog verschiedener LLMs zugreifen. So können Sie verschiedene Möglichkeiten ausprobieren und das Modell auswählen, das die optimalen Ergebnisse erzielt. Die Modelle werden im NVIDIA API-Katalog gehostet. Sobald Sie ein API-Token eingerichtet haben, können Sie ein Modell mit der NVIDIA NIM Model Serving-Plattform direkt über OpenShift AI bereitstellen.

Auswählen des richtigen Modells

Beim Testen verschiedener LLMs können Ihre Nutzerinnen und Nutzer die einzelnen generierten Antworten bewerten. Sie können ein Grafana Monitoring Dashboard einrichten, um die Bewertungen sowie die Latenz- und Antwortzeiten der einzelnen Modelle zu vergleichen. Anhand dieser Daten können Sie dann das optimale LLM für den Produktionseinsatz auswählen.

Erste Schritte mit KI für Unternehmen: Ein Guide für den Einsatz

In diesem Guide für den Einstieg erfahren Sie, wie Red Hat OpenShift AI und Red Hat Enterprise Linux AI die KI-Einführung beschleunigen können.