Überblick

Eine Plattform für Künstliche Intelligenz (KI-Plattform) ist eine integrierte Sammlung von Technologien zum Entwickeln, Trainieren und Ausführen von ML-Modellen (Maschinelles Lernen). Dazu gehören in der Regel Automatisierungsfunktionen, MLOps (Machine Learning Operations), prädiktive Datenanalysen und mehr. Sie können sich die Plattform wie eine Werkbank vorstellen: Sie verfügt über sämtliche Tools oder Werkzeuge, mit denen Sie arbeiten müssen, und bietet Ihnen eine stabile Basis, auf der Sie aufbauen und die Sie anpassen können.

Bei der Wahl einer passenden KI-Plattform steht Ihnen eine wachsende Zahl an Möglichkeiten zur Verfügung. Im Folgenden finden Sie wichtige Faktoren, auf die Sie achten sollten.

Welche Arten von KI-Plattformen gibt es?

Bei der Wahl einer passenden KI-Plattform müssen Unternehmen zunächst entscheiden, ob sie eine vorkonfigurierte Plattform erwerben oder intern eine benutzerdefinierte Plattform entwickeln möchten.

Eine KI-Plattform erwerben

Wenn Sie KI-Anwendungen, -Modelle und -Algorithmen schnell bereitstellen möchten, ist der Erwerb einer umfassenden, vorkonfigurierten KI-Plattform die beste Option. Solche Plattformen verfügen über Tools, Sprach-Repositories und APIs, die vorab auf Sicherheit und Performance getestet wurden. Einige Anbieter bieten außerdem vorab trainierte Basis- und generative KI-Modelle an. Dank Support und Onboarding-Ressourcen lassen sie sich reibungslos in Ihre bestehenden Umgebungen und Workflows integrieren.

Viele beliebte Cloud-Anbieter erweitern ihre Portfolios derzeit um KI-Plattformen, darunter Amazon Web Services (AWS) SageMaker, Google Cloud AI Platform, Microsoft Azure AI Platform und watsonx.ai™ AI Studio von IBM. Viele KI-Plattformen bieten auch Standalone-KI-Tools, die zusammen mit anderen KI-Lösungen genutzt oder in diese integriert werden können.

Eine KI-Plattform entwickeln

Manche Unternehmen müssen ihre eigene KI-Plattform vollständig anpassen und verwalten, um bestimmten Use Cases oder hohen Datenschutzanforderungen gerecht zu werden. Uber entwickelte beispielsweise eine benutzerdefinierte KI-Plattform, die auf Technologien wie NLP (Natural Language Processing) und maschinellem Sehen basiert und dem Unternehmen ein optimiertes GPS und bessere Unfallerkennungsfunktionen bietet. Syapse, ein datenorientiertes Unternehmen im Gesundheitswesen, hat mit Syapse Raydar® eine KI-gestützte Datenplattform entwickelt, die onkologische Daten in verwertbare Erkenntnisse umwandelt.

Wenn Sie eine eigene KI-Plattform entwickeln, haben Sie die vollständige Kontrolle über die Umgebung und können entsprechend Ihrer besonderen geschäftlichen Anforderungen iterieren. Dieser Ansatz erfordert jedoch mehr Vorarbeit, um die Plattform einsatzbereit zu machen. Außerdem können dabei Wartung, Support und Verwaltung nicht ausgelagert werden.

Open Source-Lösungen

Open Source Communities treiben den Fortschritt in den Bereichen künstliche Intelligenz und maschinelles Lernen voran. Mit einer Open Source-Softwarelösung als Basis für Ihre KI-Initiativen setzen Sie auf eine Community von Peers und KI-Fachkräften und können darauf vertrauen, dass die Frameworks und Tools, die Sie am meisten nutzen, kontinuierlich verbessert werden. Viele Organisationen beginnen mit Open Source-Tools und bauen darauf auf. Open Source-Plattformen wie TensorFlow und PyTorch bieten Libraries und Frameworks für die Entwicklung von KI-Anwendungen.

Red Hat Ressourcen

Welche Funktionen beinhaltet eine KI-Plattform?

MLOps

MLOps (Machine Learning Operations) besteht aus mehreren Workflow-Praktiken mit dem Ziel, Deployment und Wartung von ML-Modellen zu optimieren. Eine KI-Plattform sollte MLOps-Phasen wie das Trainieren, Bereitstellen und Überwachen von Modellen unterstützen.

LLMOps (Large Language Model Operations) ist ein Teilbereich von MLOps, der sich auf die Praktiken, Techniken und Tools bezieht, die für das operative Management von großen Sprachmodellen in Produktivumgebungen eingesetzt werden. LLMs können Aufgaben wie das Generieren von Text, das Zusammenfassen von Inhalten und das Kategorisieren von Informationen ausführen. Dazu greifen sie jedoch auf ein bedeutendes Ausmaß an Computing-Ressourcen der GPUs zurück. Ihre KI-Plattform muss also über ausreichend Leistung verfügen, um LLM-Eingaben und -Ausgaben zu unterstützen.

Generative KI

Generative KI basiert auf neuronalen Netzwerken und Deep Learning-Modellen, die auf sehr großen Datensätzen trainiert werden, um neue Inhalte zu erstellen. Mit ausreichendem Training kann das Modell das Gelernte aus dem Training anwenden und auf reale Situationen übertragen, was als KI-Inferenz bezeichnet wird.

Generative KI umfasst viele Funktionen, die Endbenutzende mit künstlicher Intelligenz in Verbindung bringen, darunter Text- und Bilderzeugung, Datenerweiterung, dialogorientierte KI wie Chatbots und vieles mehr. Es ist wichtig, dass Ihre KI-Plattform die erforderliche Geschwindigkeit und Genauigkeit für generative KI-Funktionen ermöglicht und unterstützt.

Skalierbarkeit

Modelle können auf Dauer nur dann erfolgreich sein, wenn sie skalierbar sind. Um skalieren zu können, brauchen Data Science-Teams eine zentrale Lösung, die das Entwickeln und Bereitstellen von KI-Modellen, Experimente und Fine Tuning sowie die Zusammenarbeit mit anderen Teams ermöglicht. Dafür sind riesige Datenmengen und eine enorme Rechenleistung erforderlich – und natürlich eine Plattform, die dies bewältigen kann.

Sobald Ihre Modelle erfolgreich sind, können Sie diese in unterschiedlichen Umgebungen reproduzieren: On-Premise, auf Public Cloud-Plattformen und am Edge. Eine skalierbare Lösung unterstützt Deployments in Ihrer gesamten Infrastruktur.

Automatisierung

Wenn Ihr Unternehmen nicht mehr nur einige wenige Modelle in der Produktion bereitstellen möchte, sondern mit der Zeit ein ganzes Dutzend oder mehr einsetzt, sollten Sie sich mit Automatisierung befassen. Mit automatisierten Data Science-Pipelines können Sie erfolgreiche Prozesse in wiederholbare Abläufe umwandeln. Dadurch beschleunigen Sie nicht nur Ihre Workflows, sondern sorgen auch für eine bessere Skalierbarkeit und ein optimiertes Benutzererlebnis mit einer höheren Vorhersagbarkeit. Sie beseitigen damit außerdem Routineaufgaben und entlasten so Ihre Data Scientists und Engineers, sodass ihnen mehr Zeit für Innovationen und zum Iterieren und Anpassen von Modellen bleibt.

Tools und Integrationen

Entwicklungsteams und Data Scientists sind beim Entwickeln und effizienten Bereitstellen von Anwendungen und Modellen auf Tools und Integrationen angewiesen. Ihre KI-Plattform muss daher die Tools, Sprachen und Repositories unterstützen, die Ihre Teams bereits nutzen, und gleichzeitig die Integration mit Ihrem gesamten Technologie-Stack sowie mit Partnerlösungen ermöglichen.

Sicherheit und Regulierung

Mindern Sie Risiken und schützen Sie Ihre Daten, indem Sie strenge Sicherheitspraktiken für Ihre KI-Plattform einführen. Bei den täglichen Trainings- und Entwicklungsabläufen ist das Scannen auf CVEs (Common Vulnerabilities and Exposures) von entscheidender Bedeutung. Außerdem sollten Sie mithilfe von Zugriffsverwaltung, Netzwerksegmentierung und Verschlüsselung für den operativen Schutz von Anwendungen und Daten sorgen.

Verantwortung und Governance

Ihre KI-Plattform sollte Ihnen die Möglichkeit bieten, Daten so zu nutzen und zu überwachen, dass ethische Standards gewahrt und Compliance-Verstöße vermieden werden. Für den Schutz sowohl von Unternehmensdaten als auch von Nutzerdaten ist es wichtig, dass die gewählte Plattform Transparenz, Nachverfolgung und Risikomanagementstrategien bietet – und zwar für den gesamten ML-Lifecycle. Die Plattform muss außerdem die bestehenden Compliance- und Sicherheitsstandards für Daten in Ihrem Unternehmen erfüllen.

Support

Einer der größten Vorteile einer vorkonfigurierten End-to-End-KI-Plattform ist der damit einhergehende Support. Die kontinuierliche Nachverfolgung von Bugs und die entsprechenden Behebungsmaßnahmen für sämtliche Deployments verbessern die Performance Ihrer Modelle. Einige Anbieter von KI-Plattformen stellen auch Onboarding- und Trainingsressourcen zur Verfügung, um Ihren Teams den Einstieg zu erleichtern. Unternehmen, die ihre eigene Plattform mit Open Source-Tools erstellen möchten, sollten einen Anbieter wählen, der Support für ML-Funktionen und -Infrastruktur bietet.

Wo werden KI-Plattformen eingesetzt?

Telekommunikation

Umfassende KI-Services können verschiedene Bereiche der Telekommunikationsbranche optimieren – von der Netzwerk-Performance bis hin zur Qualität von Produkten und Services. Typische Use Cases sind die Optimierung der Servicequalität, audiovisuelle Verbesserungen und Abwanderungsprävention.

Gesundheitswesen

Eine robuste KI-Plattform kann für transformative Vorteile in vielen Bereichen des Gesundheitswesens sorgen, wie etwa schnellere Diagnosen, Fortschritte in der klinischen Forschung und erweiterter Zugriff auf Patientenservices. Dadurch werden auch die Ergebnisse für Patientinnen und Patienten verbessert, da ärztliches und anderes medizinisches Fachpersonal genauere Diagnosen stellen und besser abgestimmte Behandlungspläne entwickeln kann.

Fertigung

Intelligente, ML-gestützte Automatisierung transformiert die gesamte Lieferkette in der Fertigung. Industrieroboter und prädiktive Analysen entlasten Teams von repetitiven Aufgaben und implementieren effektivere Workflows in Echtzeit.

Wie Red Hat helfen kann

Bei KI-Plattformen priorisieren wir die Entwicklung flexibler, zuverlässiger KI-Lösungen in großem Umfang.

Red Hat® AI, unser KI-Produktportfolio, basiert auf den vertrauenswürdigen Lösungen, die unsere Kunden bereits nutzen.

Mit Red Hat AI können Unternehmen:

- KI schnell einführen und Innovationen schaffen

- Die Komplexitäten beim Bereitstellen von KI-Lösungen umgehen

- In vielen verschiedenen Umgebungen bereitstellen

Flexibles Skalieren

Wenn Sie skalieren möchten, bietet die KI-Plattform von Red Hat Entwicklungsteams die erforderlichen Tools zum Entwickeln, Bereitstellen und Verwalten von KI-fähigen Anwendungen.

Durch eine unterstützte kontinuierliche Zusammenarbeit können Sie Ihre KI-Modellanwendungen schnell und einfach an die Use Cases Ihres Unternehmens anpassen.

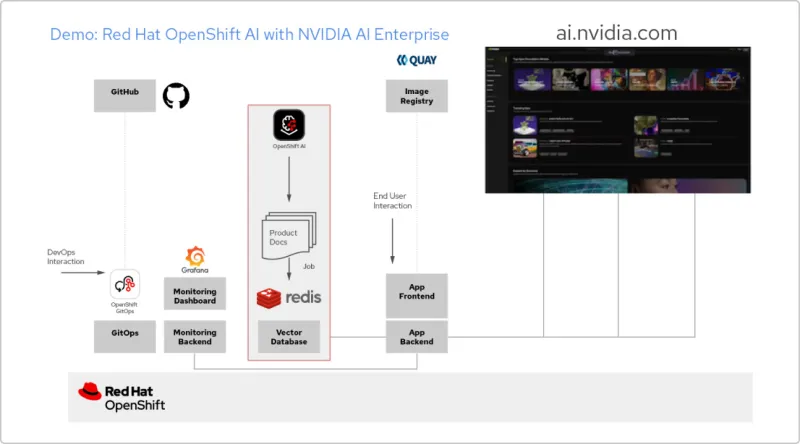

Lösungs-Pattern: KI-Anwendung mit Red Hat und NVIDIA AI Enterprise

Entwickeln einer RAG-Anwendung

Red Hat OpenShift AI ist eine Plattform für das Entwickeln von Data Science-Projekten und Bereitstellen von KI-gestützten Anwendungen. Sie können sämtliche Tools integrieren, die für die Unterstützung von Retrieval-Augmented Generation (RAG), einer Methode zum Abrufen von KI-Antworten aus Ihren eigenen Referenzdokumenten, erforderlich sind. Wenn Sie OpenShift AI mit NVIDIA AI Enterprise kombinieren, können Sie mit Large Language Models (LLMs) experimentieren und so das optimale Modell für Ihre Anwendung finden.

Erstellen einer Pipeline für Dokumente

Damit Sie RAG nutzen können, müssen Sie Ihre Dokumente zunächst in eine Vektordatenbank aufnehmen. In unserer Beispielanwendung integrieren wir eine Anzahl von Produktdokumenten in eine Redis-Datenbank. Da sich diese Dokumente häufig ändern, können wir für diesen Prozess eine Pipeline erstellen, die wir regelmäßig ausführen, damit wir immer die aktuellsten Versionen der Dokumente zur Verfügung haben.

Durchsuchen des LLM-Katalogs

Mit NVIDIA AI Enterprise können Sie auf einen Katalog verschiedener LLMs zugreifen. So können Sie verschiedene Möglichkeiten ausprobieren und das Modell auswählen, das die optimalen Ergebnisse erzielt. Die Modelle werden im NVIDIA API-Katalog gehostet. Sobald Sie ein API-Token eingerichtet haben, können Sie ein Modell mit der NVIDIA NIM Model Serving-Plattform direkt über OpenShift AI bereitstellen.

Auswählen des richtigen Modells

Beim Testen verschiedener LLMs können Ihre Nutzerinnen und Nutzer die einzelnen generierten Antworten bewerten. Sie können ein Grafana Monitoring Dashboard einrichten, um die Bewertungen sowie die Latenz- und Antwortzeiten der einzelnen Modelle zu vergleichen. Anhand dieser Daten können Sie dann das optimale LLM für den Produktionseinsatz auswählen.

Erste Schritte mit KI für Unternehmen: Ein Guide für den Einsatz

In diesem Guide für den Einstieg erfahren Sie, wie Red Hat OpenShift AI und Red Hat Enterprise Linux AI die KI-Einführung beschleunigen können.