Red Hat Enterprise Linux (RHEL) のシステム管理者と開発者は、長年にわたって蓄積された直感と経験に基づき、特定のツールセットを使用して問題を診断してきました。しかし、環境が複雑化するにつれて、ログを効果的に解析し、問題をトラブルシューティングするために必要な認知負荷が増大しています。

ここで、RHEL 向けの新しい Model Context Protocol (MCP) サーバーの開発者プレビューを発表できることを嬉しく思っています。この新しい MCP サーバーは、RHEL と大規模言語モデル (LLM) 間のギャップを埋めるように設計されており、よりスマートなトラブルシューティングの新時代を促進します。

RHEL の MCP サーバーとは

MCP は、AI モデルが外部データやシステムと対話できるようにするオープンスタンダードであり、元々は Anthropic によってリリースされ、2025 年 12 月に Linux Foundation の Agentic AI Foundation に寄贈されました。RHEL の新しい MCP サーバーは現在開発者プレビューとして利用可能であり、このプロトコルを使用して、Claude Desktop や goose など、MCP プロトコルをサポートする AI アプリケーションから RHEL への直接的なコンテキスト認識型アクセスを可能にします。

Red Hat は以前に Red Hat Lightspeed および Red Hat Satellite 向けの MCP サーバーをリリースしましたが、これにより数多くのユースケースが可能になりました。この新しい MCP サーバーはこれらのユースケースでさらに拡張し、RHEL システムでの詳細なトラブルシューティング専用に構築されています。

スマートなトラブルシューティングが可能に

新しい MCP サーバーを使用して LLM を RHEL に接続すると、次のようなユースケースが実現します。

- インテリジェントなログ分析: ログデータの精査は面倒な作業です。しかし MCP サーバーにより、LLM は RHEL システムログを取り込んで分析することができます。この機能を使用すると、AI 駆動型の根本原因の分析と異常検出が可能になり、未加工のログデータを実用的なインテリジェンスに変換することができます。

- パフォーマンス分析: MCP サーバーは、CPU 数、平均負荷、メモリー情報、実行中のプロセスの CPU およびメモリー使用量に関する情報にアクセスできます。これにより、LLM システムはシステムの現在の状態を分析し、潜在的なパフォーマンス上のボトルネックを特定し、パフォーマンスに関する推奨事項を提案できます。

これらの新機能をより安全な方法で試せるように、この開発者プレビューでは読み取り専用 MCP の有効化に焦点を当てています。MCP サーバーは、LLM による検査と推奨を有効にし、認証に標準の SSH キーを使用します。また、ログファイルのアクセスやログレベルのアクセスの許可リストを設定することも可能です。MCP サーバーで実行されるコマンドは事前に精査されているため、MCP サーバーは RHEL システムへのオープンシェルアクセスを許可しません。

ユースケースの例

以下の例では、goose AI エージェントと MCP サーバーを使用して、rhel10.example.com という名前の RHEL 10 システムの 1 つを操作しています。Goose は、ホスト型オンラインプロバイダーやローカルでホストされるプロバイダーなど、多数の LLM プロバイダーをサポートしています。ローカルでホストされるモデルを使用しています。

Fedora ワークステーションに goose と MCP サーバーをインストールし、rhel10.example.com で SSH キー認証を設定しました。

まず、rhel10.example.com システムの正常性を確認するように LLM に指示します。

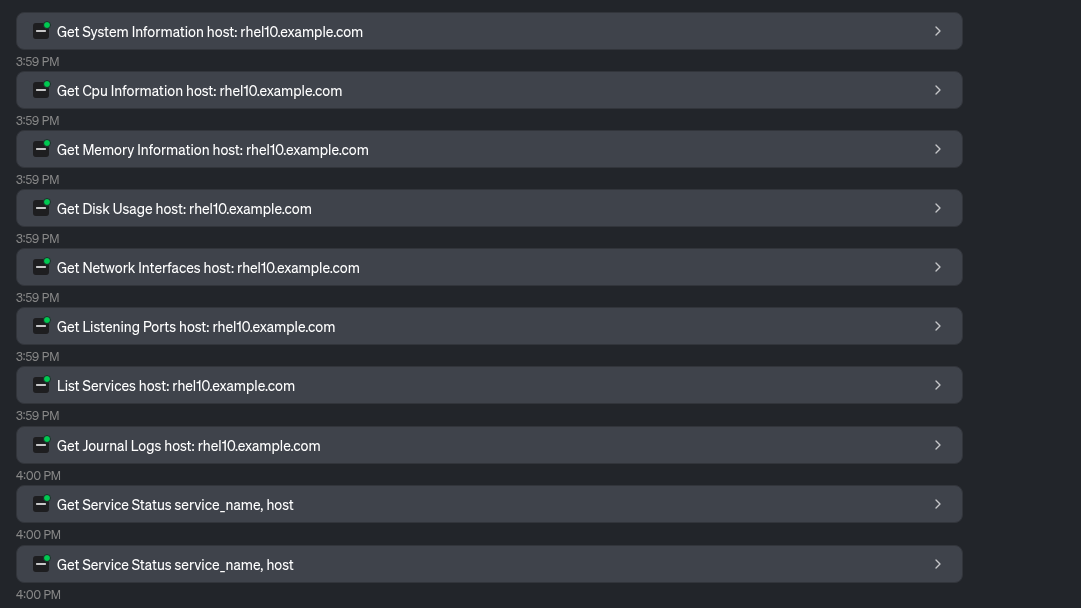

LLM は、MCP サーバーによって提供される多数のツールを利用して、システム情報を収集します。

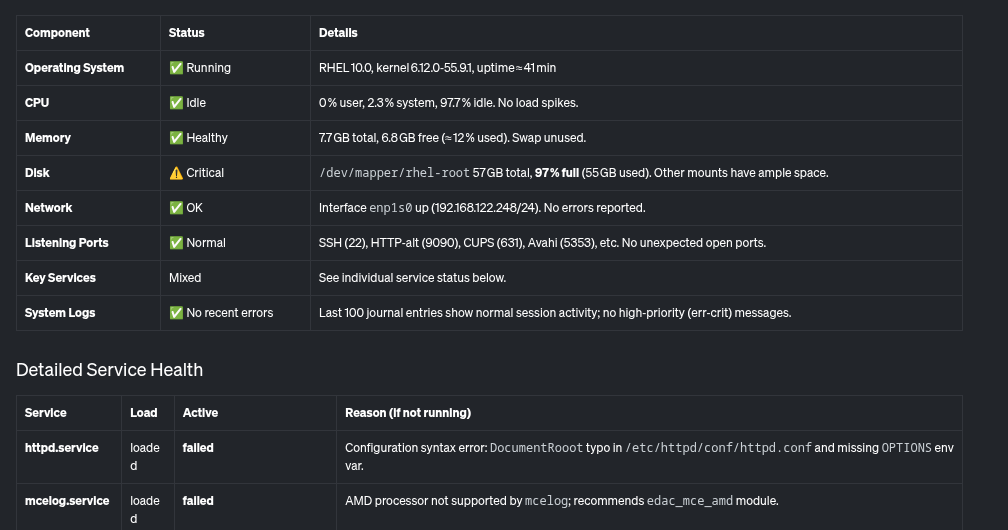

これに基づいて、LLM は次の表のようなシステムとその正常性の概要を示します。

さらに、ほぼ満杯の root ファイルシステムや、システム上で失敗しているいくつかのサービスなど、対処が必要な重要な問題を指摘する概要も提供します。

どのように問題が特定されるかを見てみましょう。LLM を使って、ディスク使用量が非常に多い理由の特定を試みます。

LLM は MCP サーバーが提供するツールを使用して、最もディスク容量を使用しているものを特定します。

これに基づいて、LLM は /home/brian/virtual-machines ディレクトリに 25 GB のファイルがあり、/home/brian/.local ディレクトリが 24 GB の容量を使用していることを特定します。

最後に、前に失敗したと報告された httpd.service についても LLM に問い合わせます。

LLM は、MCP サーバーによって提供されるファイル読み取りツールを使用します。

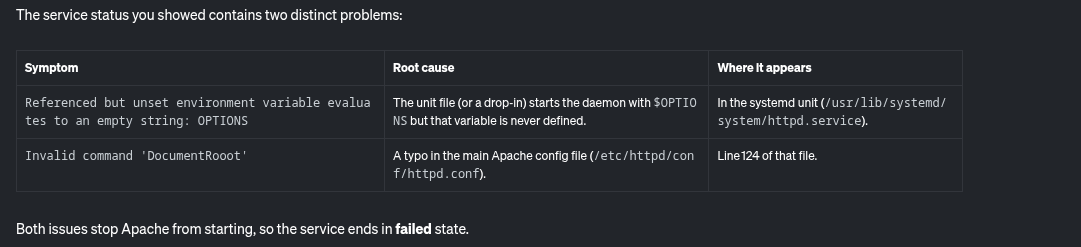

これに基づいて、LLM は httpd.service の失敗の潜在的な原因を報告します。

さらに、修正のためのステップごとの手順も示します。

RHEL 用の MCP サーバーを使用することで、ほぼ満杯のファイルシステムと失敗している httpd サービスに関連する、このシステムの潜在的な問題を簡単に特定してトラブルシューティングすることが可能になります。

次のステップ

読み取り専用の分析から始めていますが、ロードマップとしては、他のユースケースへの拡張が予定されています。開発プロセスを確認するには、アップストリームの GitHub リポジトリを確認してください。アップストリームへの貢献を歓迎します!機能拡張リクエストやバグレポートなど、フィードバックをお待ちしております。GitHub または Fedora AI/ML Special Interest Group (SIG) を通じて、チームに問い合わせることができます。

よりスマートなトラブルシューティングを体験してみませんか?

RHEL 向けの MCP サーバーは、開発者プレビューで利用可能になりました。LLM クライアントのアプリケーションに接続して、コンテキスト認識型の AI が RHEL の管理方法をどのように変えるかを確認してください。スタートするには、Red Hat ドキュメントと、アップストリームの文書を参照してください。

製品トライアル

Red Hat Enterprise Linux | 製品トライアル

執筆者紹介

Brian Smith is a product manager at Red Hat focused on RHEL automation and management. He has been at Red Hat since 2018, previously working with public sector customers as a technical account manager (TAM).

Máirín Duffy is a Red Hat Distinguished Engineer and leads the Red Hat Enterprise Linux Lightspeed Incubation team at Red Hat as a passionate advocate for human-centered AI and open source. A recipient of the O’Reilly Open Source Award, Máirín first joined Red Hat as an intern in 2004 and has spent two decades in open source communities focusing on user experience in order to expand the reach of open source. A sought-after speaker and author, Mo holds 19 patents and authored 6 open source coloring books, including The SELinux Coloring Book.

類似検索

AI insights with actionable automation accelerate the journey to autonomous networks

Fast and simple AI deployment on Intel Xeon with Red Hat OpenShift

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

チャンネル別に見る

自動化

テクノロジー、チームおよび環境に関する IT 自動化の最新情報

AI (人工知能)

お客様が AI ワークロードをどこでも自由に実行することを可能にするプラットフォームについてのアップデート

オープン・ハイブリッドクラウド

ハイブリッドクラウドで柔軟に未来を築く方法をご確認ください。

セキュリティ

環境やテクノロジー全体に及ぶリスクを軽減する方法に関する最新情報

エッジコンピューティング

エッジでの運用を単純化するプラットフォームのアップデート

インフラストラクチャ

世界有数のエンタープライズ向け Linux プラットフォームの最新情報

アプリケーション

アプリケーションの最も困難な課題に対する Red Hat ソリューションの詳細

仮想化

オンプレミスまたは複数クラウドでのワークロードに対応するエンタープライズ仮想化の将来についてご覧ください