私たちは AI を組織に導入することが求められていますが、概念実証 (PoC) から本番環境に対応するアプリケーションに移行するまでの道のりは、とくエージェント型 AI のユースケースの場合には、ツールが断片化され、統合が複雑化するために容易ではありません。真の課題は、テクノロジーだけではなく、スケーラブルで信頼性が高く、管理しやすい AI 戦略を構築することにあります。

標準化は、この課題に対処する上での主な鍵であり、これは主に複雑さを軽減し、効率性を高めることによって課題に対応します。また、Red Hat OpenShift AI などのプラットフォームで モデルコンテキストプロトコル (MCP) と Llama Stack を組み合わせることで、AI アプリケーション向けの統合された、可搬性のある環境を構築できます。

OpenShift AI は、LangChain、LangGraph、CrewAI などのツールを含む、その他のエージェント型フレームワークやコンポーネントの統合もサポートします。Red Hat のアプローチは、開発の単純化や運用の効率化を支援します。さらに、AI 開発者やデータサイエンティストなどの複数のチームが、信頼できる一貫した環境内で AI のビジョンを実現するために必要なツールを提供します。

インテリジェントなエージェントの構成要素について

回復力のある AI 対応アプリケーションを構築するには、インテリジェントなエージェントが企業固有のツールとデータにアクセスし、これらを使用できるようにするための基盤が必要です。これには、サービスを公開する標準化された方法とサービス、およびそれらと対話するための統合フレームワークの 2 つの主要な要素が必要です。

これがエージェント型 AI の本質であり、自律的なシステムが、目標達成に必要な最適な行動とツールを決定することができます。MCP と Llama Stack を組み合わせることで、これらのエージェントを効果的に運用するためのフレームワークを利用できます。

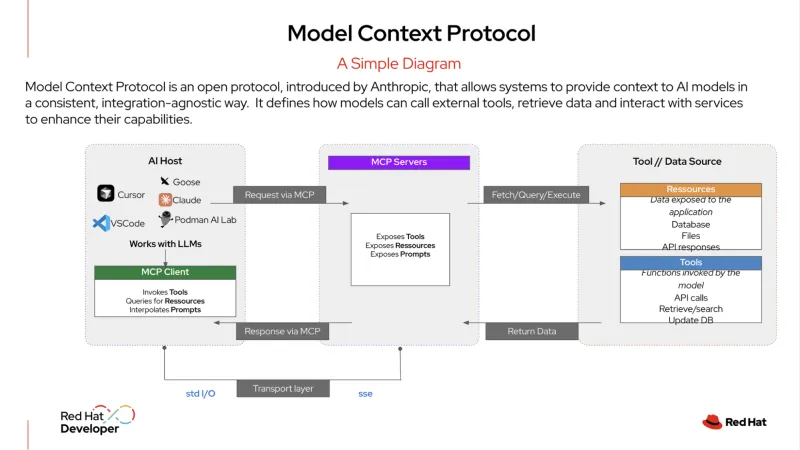

MCP は、AI システムが外部のツールやデータソースと統合する方法を標準化するオープンプロトコルです。これは、「AI アプリケーション用の USB-C ポート」とも表現されています。USB-C を使用すると、任意の互換性のあるデバイス (モニター、ハードドライブ、キーボードなど) を接続できるように、MCP サーバーも組織のサービスを標準化された形式で公開します。

AI エージェントはこのサーバーに接続して、データベース、顧客関係管理 (CRM) システム、内部 API のいずれであっても、利用可能なツールを検出して使用できます。このプロトコルは、AI エージェントが各種サービスに接続できるように構造化された方法を提供し、これにより、AI エージェントはタスクの実行に必要な情報を容易に取得できるようになります。

Llama Stack は、生成 AI (gen AI) アプリケーションの構築とデプロイのための統一された API 駆動型アプローチを提供するオープンソース・フレームワークです。これは、AI の開発とデプロイの複雑さを抽象化するための、一貫性のあるポータブルな方法を提供し、推論、検索拡張生成 (RAG)、AI エージェント用の API などの企業用ツールのスイートが含まれています。また、安全性、評価、可観測性用の組み込みコンポーネントを提供するため、信頼性が高くスケーラブルな、本番対応の AI アプリケーションの作成を支援します。

エージェント型 AI の実例

エンタープライズ IT では、エージェント型 AI は動的な意思決定を必要とする複雑な多段階ワークフローを処理できます。たとえば、単純な 1 対 1 の要求と応答の代わりに、より高度なエージェントが自律的なサービスデスク・マネージャーとして機能し、最小限の人的介入で問題を解決できます。

ユーザーが「サービス停止」のチケットを送信した場合に、この種のエージェントが実行する内容を次に示します。

- Llama Stack は初期チケットを受信します。システムは、ユーザーからのサービス停止のレポートを受信し、これを優先度の高いインシデントに分類します。

- エージェントは MCP を使用して計画を策定します。エージェントは MCP を使用して、アクセス可能な関連ツール (監視サービス、ログ分析ツール、Runbook Automation システムなど) を特定し、検出します。MCP からのこのコンテキストを使用して、エージェントは問題を調査し、解決するための多段階の計画を策定します。

- エージェントは MCP を使用して計画を実行し、検出されたツールと通信します。

- まず監視ツールを使用して、関連するサービスと依存関係の状態をチェックします。

- 次に、ログ分析ツールを呼び出して、関連するアプリケーションまたは Red Hat OpenShift コンテナについての最近のログを確認し、エラーを探します。

- 潜在的な問題 (Pod がクラッシュしているなど) が特定された場合、診断ツールを使用し、ネットワークポリシーの設定ミスやディスクが一杯であるなどの根本的な問題を特定します。

- エージェントが是正措置を取ります。診断に基づいて、MCP を使用して事前承認済みの修復スクリプトを呼び出し、Pod を再起動してディスクの空き容量を確保します。その後、サービスの状態を再確認して、問題が解決されたことを確認します。

- エージェントが結果を伝えます。これは、内部ツールを使用して、実行されたアクションの概要も含め、チケットのステータスを「Resolved (解決済み)」に更新します。次に、ユーザーにメッセージを送信し、問題について説明し、サービスがオンラインに戻ったことを確認します。このタスクには、人の介入が全くありません。

MCP を使用してこれらのアクションをオーケストレーションすることで、エージェントは自律的で自己完結型のサービスデスクとして動作し、IT チームの手作業の負担を軽減し、IT チームはより戦略的な取り組みに集中する時間を確保できます。

開発と本番稼働向けに最適化されたアプローチ

Llama Stack と MCP を組み合わせることで、開発者のエクスペリエンスを大幅に向上させることができます。特定のモノリシックなスタックを構築する代わりに、開発者は単一の API を介して標準化された抽象化レイヤーを使用できます。これにより、強力な「内部ループ」型の開発手法が可能になり、単一の SDK を使用してローカルマシン上で AI アプリケーションの構築とテストを行うことができます。

API に一貫性があり、サービスを標準化されたプロトコルを介して検出できるため、アプリケーションがエンタープライズグレードのプラットフォームにデプロイされたときに全く同じように動作すると確信できます。

この可搬性は、急速に変化する AI 環境において不可欠です。開発者は、現時点で特定のモデルを使用するようにアプリケーションを構築していても、より優れた、またよりコスト効率の高い新しいモデルが登場した場合には、コードを書き換えることなく、そのモデルに切り替えることができます。これにより、開発にかかる時間と労力を削減し、イノベーションを加速し、開発からプロダクションへの移行のための明確な道筋が得られます。

AI ワークロードの運用における一貫性を得る

運用チームにとって、多様な AI モデルとサービスの管理は、複雑さの大きな原因となる可能性があります。しかし、組織に合わせてカスタマイズされ、標準化された AI スタックを OpenShift AI などのプラットフォーム上で実行することで、一元化され、一貫性のある環境を活用することができます。

OpenShift AI は、LLM をデプロイして提供し、RAG アプリケーションに必要なデータベースを実行するための包括的で信頼できるプラットフォームを提供します。また、チームは既存のマイクロサービス・アーキテクチャを活用し、これを内部システムにスムーズに接続できます。

運用チームは、標準の GitOps プロセスを使用して、これらの AI アプリケーションをデプロイし、管理することもできます。これは、従来のクラウドネイティブ・アプリケーションに使用されているのと同じワークフローを AI ワークロードに適用できることを意味し、管理と保守を大幅に単純化できます。これにより、開発からプロダクションまでのプロセスを単純化し、ハイブリッドクラウド環境全体で運用の一貫性が実現します。

Llama Stack や MCP などのオープンソース・テクノロジーの力を組み合わせ、LangChain、Haystack、LlamaIndex、PydanticAI などの他のエージェント型 AI フレームワークの統合を可能にすることで、Red Hat AI は、ハイブリッドクラウド全体で AI アプリケーションを構築、デプロイ、管理するための信頼性の高い基盤を提供します。

詳細はこちら

実際に使用することを希望されますか?Red Hat の製品トライアル、コンサルティングサービス、トレーニングと認定などを通じて、Red Hat AI についてさらに詳しくご確認ください。

リソース

適応力のある企業:AI への対応力が破壊的革新への対応力となる理由

執筆者紹介

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.

チャンネル別に見る

自動化

テクノロジー、チームおよび環境に関する IT 自動化の最新情報

AI (人工知能)

お客様が AI ワークロードをどこでも自由に実行することを可能にするプラットフォームについてのアップデート

オープン・ハイブリッドクラウド

ハイブリッドクラウドで柔軟に未来を築く方法をご確認ください。

セキュリティ

環境やテクノロジー全体に及ぶリスクを軽減する方法に関する最新情報

エッジコンピューティング

エッジでの運用を単純化するプラットフォームのアップデート

インフラストラクチャ

世界有数のエンタープライズ向け Linux プラットフォームの最新情報

アプリケーション

アプリケーションの最も困難な課題に対する Red Hat ソリューションの詳細

仮想化

オンプレミスまたは複数クラウドでのワークロードに対応するエンタープライズ仮想化の将来についてご覧ください