-

製品とドキュメント Red Hat AI

ハイブリッドクラウドで AI の開発とデプロイを行うための製品およびサービスのプラットフォーム。

Red Hat AI Enterprise

AI を活用したアプリケーションをハイブリッドクラウドのどこででも構築、開発、デプロイします。

-

学ぶ 基本

-

AI パートナー

Red Hat OpenShift AI

Red Hat® OpenShift® AI は、ハイブリッドクラウド環境において予測型 AI モデルと生成 AI モデルのライフサイクルを大規模に管理するための AI プラットフォームです。

Red Hat OpenShift AI とは

OpenShift AI はオープンソース・テクノロジーを使用して構築されており、実験、モデル提供、革新的なアプリケーションの実現のための、信頼性と一貫性に優れた運用機能を提供します。

OpenShift AI により、データの取得と準備、モデルのトレーニングとファインチューニング、モデルの提供とモニタリング、およびハードウェアのアクセラレーションが可能になります。OpenShift AI は、ハードウェアパートナーとソフトウェアパートナーのオープンエコシステムにより、特定のユースケースに必要な柔軟性をもたらします。

AI 対応アプリケーションをより迅速にプロダクションに導入

Red Hat OpenShift AI と Red Hat OpenShift の実証済みの機能を、各チームを結び付ける 1 つのエンタープライズ対応 AI アプリケーション・プラットフォームに統合しましょう。データサイエンティスト、エンジニア、アプリケーション開発者は、一貫性、セキュリティ、スケーラビリティを促進する単一の場所でコラボレーションすることができます。

OpenShift AI の最新リリースには、Red Hat OpenShift AI 向けに検証および最適化された、本番環境対応のサードパーティモデルの厳選されたコレクションが含まれています。サードパーティモデルのカタログにアクセスして活用することで、チームはモデルのアクセシビリティと可視性をより細かく制御し、セキュリティとポリシーの要件を満たすのに役立てることができます。

さらに、OpenShift AI は、最適化された vLLM フレームワークを通じて、分散サービスでの推論のコスト管理に役立ちます。また、デプロイメントを自動化するための高度なツールを利用でき、モデル、ツール、リソースにセルフサービスでアクセスできるため、運用の複雑さがさらに軽減されます。

特長とメリット

AI インフラストラクチャの管理に費やす時間を短縮

セルフサービス、スケーリング、提供を容易にする高性能モデルにオンデマンドでアクセスできます。 開発者は複雑さを回避し、制御を維持し、コストを最適化できます。

Models-as-a-Service (MaaS) などの機能は現在、開発者プレビュー段階です。AI へのアクセスは、プライベートかつ高速で大規模な AI を促進する API エンドポイントの形で提供されます。

テスト済み、サポート付きの AI/ML ツール

AI/ML ツールとモデルの提供は Red Hat がテスト、統合、サポートするため、お客様は何もする必要がありません。OpenShift AI は、Red Hat の Open Data Hub コミュニティプロジェクトや Kubeflow のようなオープンソース・プロジェクトでの長年にわたる支援から生まれました。

当社はその経験とオープンソースに関する専門知識により、生成 AI 対応の基盤を提供できるため、お客様は生成 AI 戦略においてより幅広い選択肢と信頼性を得ることができます。

ハイブリッドクラウドにおける柔軟性

Red Hat OpenShift AI は、セルフマネージドのソフトウェアとして、または OpenShift 上のフルマネージド型クラウドサービスとして提供され、オンプレミスでも、パブリッククラウドでも、さらにはエッジでも、モデルを開発しデプロイする場所を選択できる安全で柔軟なプラットフォームです。

当社のベストプラクティスを活用

Red Hat サービスは、導入プロセスのどの段階であっても AI の課題を克服するのに役立つ専門知識、トレーニング、サポートを提供します。

AI ソリューションのプロトタイプ作成、AI プラットフォームの導入の効率化、MLOps 戦略の推進など、Red Hat コンサルティングがサポートと指導を提供します。

Red Hat OpenShift AI 向け MCP サーバー

テクノロジーパートナーが提供する、Red Hat OpenShift AI との統合が可能な厳選された MCP サーバー群をご覧ください。

モデル・コンテキスト・プロトコル (MCP) は、AI アプリケーションと外部サービス間の双方向接続と標準化された通信を可能にするオープンソース・プロトコルです。

これらの MCP サーバーを活用して、エンタープライズツールおよびリソースを AI アプリケーションやエージェント型ワークフローに統合できるようになりました。

vLLM を使用して最適化し、大規模な推論を高速かつコスト効率よく実行

Red Hat AI Inference Server は、Red Hat AI プラットフォームの一部です。Red Hat Enterprise Linux® AI と Red Hat OpenShift® AI の両方に含まれており、スタンドアロン製品として使用できます。

お客様のニーズに合致し、お客様の条件に従って動作する AI。

生成 AI

テキストやソフトウェアコードなどの新しいコンテンツを作成します。

Red Hat AI を使用することで、少ないリソースと低い推論コストで、任意の生成 AI モデルをより迅速に実行できます。

予測型 AI

パターンを結び付け、将来の結果を予測します。

Red Hat AI を使用することで、ハイブリッドクラウド全体で一貫性を維持しつつ、予測モデルを構築、トレーニング、提供、監視できます。

運用化 AI

AI の大規模な保守とデプロイをサポートするシステムを作成します。

Red Hat AI を使用することで、AI 対応アプリケーションのライフサイクルを管理および監視しながら、リソースを節約し、プライバシー規制へのコンプライアンスを確保できます。

エージェント型 AI

人間が限定的に関与するだけで複雑なタスクを実行するワークフローを構築します。

Red Hat AI は、既存アプリケーション内でのエージェント型 AI ワークフローの構築、管理、デプロイに対応する柔軟なアプローチと安定した基盤を提供します。

パートナーシップ

Red Hat OpenShift AI プラットフォームは、他の統合サービスや製品で拡張することで、活用の幅を拡げることができます。

NVIDIA と Red Hat は、比類のない柔軟性で多様な AI ユースケースを促進するスケーラブルなプラットフォームを提供します。

Intel® と Red Hat は、AI の導入を加速させ、AI/ML モデルを迅速に運用できるよう組織を支援します。

IBM と Red Hat は、AI 構築者のためのエンタープライズ対応 AI スタジオである IBM watsonx.aiTM などを通じて、AI 開発を促進するオープンソース・イノベーションを提供しています。

Starburst Enterprise と Red Hat は、統合されていない複数の分散データプラットフォームにわたる迅速なデータ分析を通して、優れた知見をタイムリーに取得するのをサポートします。

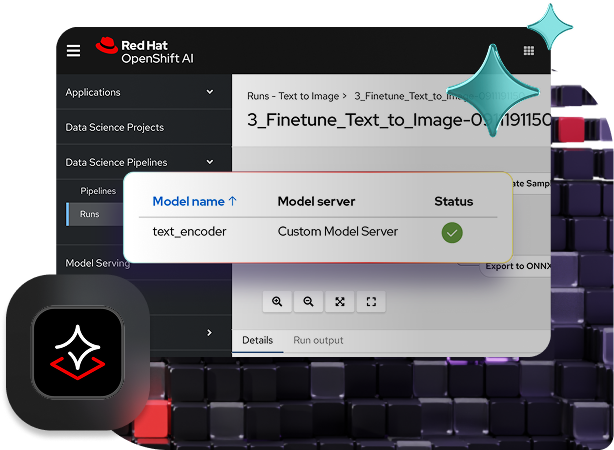

モデルのワークベンチを通じたコラボレーション

AI ハブと生成 AI スタジオを使用すると、プラットフォームエンジニアと AI エンジニアの両方が協力して生成 AI モデルをより迅速にプロダクション環境に導入できます。

AI ハブを使用することで、プラットフォームエンジニアは一元化された AI ワークロードと、サードパーティモデルの検証によるパフォーマンス分析情報を使用して、LLM を管理できます。生成 AI スタジオは、モデルを操作できる実践的な環境を AI エンジニアに提供します。そこでは、プレイグラウンドを通じて生成 AI アプリケーションのプロトタイプを迅速に作成できます。ライフサイクル統合の前に、サンドボックスにアクセスしてチャットや検索拡張生成 (RAG) フローを試し、モデルの適合性を検証できます。

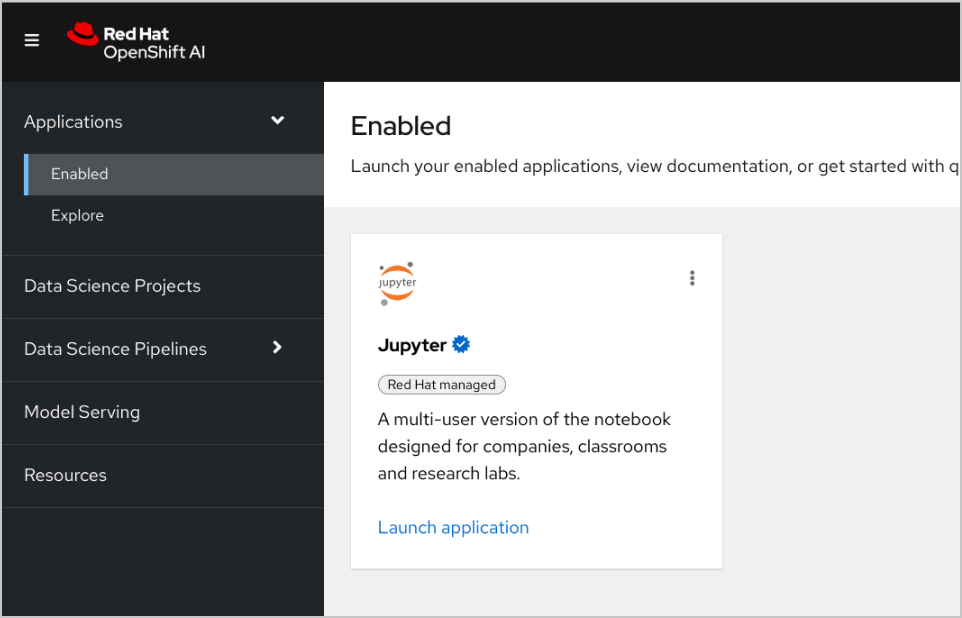

さらに、データサイエンティストは、事前に構築された、またはカスタマイズされたクラスタイメージにアクセスし、好みの IDE とフレームワークを使用してモデルを操作できます。Red Hat OpenShift AI は、Jupyter、PyTorch、Kubeflow、およびその他のオープンソース AI テクノロジーの変更を追跡します。

Red Hat OpenShift AI でモデル提供と安全をスケーリング

モデルは、最適化されたバージョンの vLLM (または選択した他のモデルサーバー) を使用して提供し、オンプレミス、パブリッククラウド、またはエッジの AI 対応アプリケーションに統合できます。これらのモデルは、ソースノートブックへの変更に基づいて再構築、再デプロイ、監視することが可能です。

ハルシネーションやバイアスは、モデルの整合性を損ない、スケーリングを困難にする場合があります。公平性、安全性、スケーラビリティを維持するために、OpenShift AI ではデータの実務担当者がモデルの出力とトレーニングデータ間の整合性を監視できます。

ドリフト検出ツールは、モデル推論に使用されるライブデータが元のトレーニングデータから逸脱していないかを監視できます。 また、モデルの入出力を誹謗中傷や卑猥な発言、個人データ、その他のドメイン固有の制限といった有害な情報から保護するための AI ガードレールも含まれています。

ソリューションパターン

Red Hat と NVIDIA AI Enterprise による AI アプリケーション

RAG アプリケーションを作成する

Red Hat OpenShift AI は、データサイエンス・プロジェクトを構築し、AI 対応アプリケーションを提供するためのプラットフォームです。独自の参照ドキュメントから AI の回答を取得する手法の 1 つである 検索拡張生成 (RAG) をサポートするために必要なすべてのツールを統合できます。OpenShift AI を NVIDIA AI Enterprise に接続すると、 大規模言語モデル (LLM) を試して、アプリケーションに最適なモデルを見つけることができます。

ドキュメントのパイプラインを構築する

RAG を利用するには、まずドキュメントをベクトルデータベースに取り込む必要があります。サンプルアプリでは、一連の製品ドキュメントを Redis データベースに埋め込んでいます。これらのドキュメントは頻繁に変更されるため、定期的に実行するこのプロセス用のパイプラインを作成すると、常に最新バージョンのドキュメントを入手できます。

LLM カタログを閲覧する

NVIDIA AI Enterprise ではさまざまな LLM のカタログにアクセスできるため、さまざまな選択肢を試して、最良の結果が得られるモデルを選択できます。モデルは NVIDIA API カタログでホストされています。API トークンを設定したら、OpenShift AI から直接 NVIDIA NIM モデル提供プラットフォームを使用してモデルをデプロイできます。

適切なモデルを選択する

さまざまな LLM をテストする際、ユーザーは生成される応答をそれぞれ評価することができます。Grafana モニタリング・ダッシュボードを設定して、各モデルの評価だけでなく、レイテンシーと応答時間も比較できます。そしてそのデータを使用して、プロダクションで使用する最適な LLM を選択できます。

2025 年の Red Hat Summit および AnsibleFest で紹介されたお客様の AI 導入事例

ターキッシュ エアラインズは、組織全体でのデータアクセスを実現して、デプロイのスピードを倍増させました。

JCCM は、AI を使用して地域の環境影響評価 (EIA) プロセスを改善しました。

DenizBank は、市場投入時間を数日から数分へと短縮しました。

日立は、Red Hat OpenShift AI を使用して事業全体で AI を運用化しました。

Red Hat OpenShift AI を試す方法

開発者サンドボックス

事前構成済みの柔軟な環境で、AI 対応アプリケーションの構築を試してみたい開発者やデータサイエンティスト向け。

60 日間のトライアル

OpenShift AI のすべての機能を評価する準備が整ったら、60 日間の製品トライアルをお試しください。ご利用にあたっては、あらかじめ Red Hat OpenShift クラスタが必要です。