Cos'è un microservizio?

I microservizi sono un approccio architetturale alle applicazioni in cui una raccolta di servizi indipendenti comunica tramite API leggere.

Pensa alla tua ultima visita al sito di un rivenditore online. Probabilmente hai usato la barra di ricerca del sito per sfogliare i prodotti. La ricerca costituisce un servizio. Potresti avere anche ricevuto suggerimenti per i prodotti correlati, o aggiunto un articolo a un carrello online. Ovviamente, sono entrambi altri servizi. Tutti questi microservizi, insieme, vanno a comporre un'applicazione completamente funzionante.

Un approccio più efficiente allo sviluppo applicativo

Un'architettura di microservizi è un approccio cloud native alla realizzazione di software secondo modalità che permettono l'esistenza indipendente di ogni funzione principale di un'applicazione.

Quando gli elementi di un'applicazione sono distinti in questo modo, i team di sviluppo e operativi possono lavorare in tandem senza intralciare le reciproche attività. Ciò consente a più sviluppatori di lavorare simultaneamente alla stessa app, riducendo le tempistiche di sviluppo.

Risorse da Red Hat

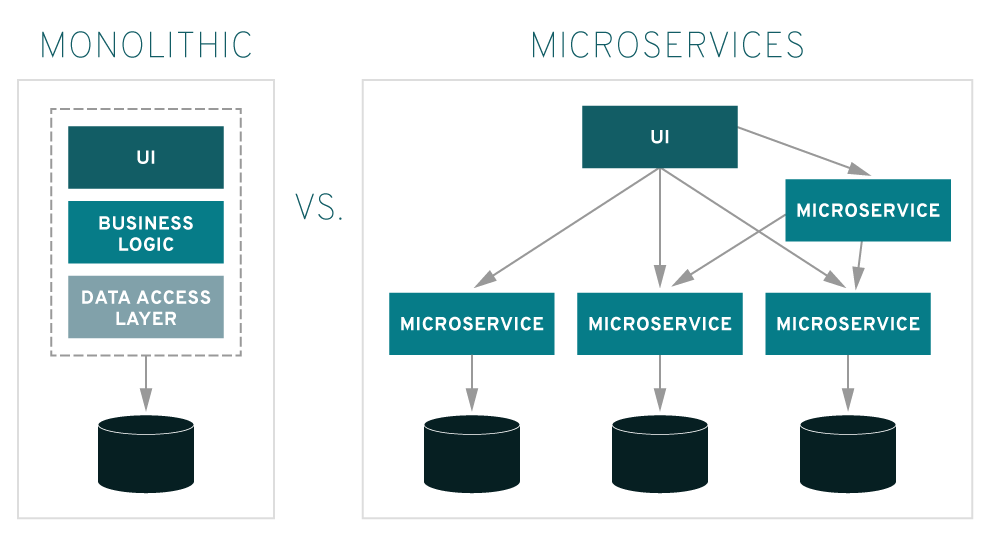

Architettura monolitica e architettura di microservizi a confronto

Il tradizionale approccio alla creazione delle applicazioni è di tipo monolitico e prevede che tutte le funzionalità e i servizi di un'applicazione siano bloccati insieme e funzionino come una singola unità. Quando l'applicazione viene aggiunta o migliorata in qualsiasi modo, la complessità dell'architettura aumenta, insieme alla difficoltà di ottimizzare ogni singola funzione dell'applicazione senza suddividerla in più parti. Inoltre, se è necessario dimensionare uno dei processi che compongono l'applicazione, sarà necessario dimensionarla nella sua interezza.

Nelle architetture di microservizi, le applicazioni sono costruite in modo che ogni loro funzione principale sia eseguibile in modo indipendente, consentendo ai team di sviluppo di creare e aggiornare nuovi componenti che soddisfano le mutate esigenze aziendali senza compromettere l'intera applicazione.

Service Oriented Architecture e architettura di microservizi a confronto

L'architettura di microservizi è un'evoluzione della Service Oriented architecture (SOA), due approcci simili in quanto entrambe suddividono le applicazioni complesse e di grandi dimensioni in componenti più piccoli e più facili da gestire. A causa delle loro somiglianze, le architetture SOA e dei microservizi sono spesso confuse. La differenza principale è che la SOA è un approccio architetturale di livello aziendale, mentre i microservizi sono una strategia di implementazione adottata dagli sviluppatori di app.

I vantaggi di un'architettura di microservizi

Basandosi su un'architettura distribuita, i microservizi consentono di ottenere sviluppo e routine più efficienti. La possibilità di sviluppare più microservizi in contemporanea consente a più sviluppatori di lavorare simultaneamente alla stessa app, riducendo le tempistiche di sviluppo.

Rilasci più rapidi

Consentendo di abbreviare i cicli di sviluppo, un'architettura basata su microservizi supporta deployment e aggiornamenti più agili.

Scalabilità superiore

Man mano che la domanda per determinati servizi aumenta, i microservizi possono essere distribuiti su più server e infrastrutture, in base alle esigenze aziendali.

Resilienza

Ciascun servizio, se costruito correttamente, è indipendente e non influisce sugli altri servizi dell'infrastruttura. Di conseguenza, l'eventuale errore di un componente non determina il blocco dell'intera app, come avviene con il modello monolitico.

Semplicità di deployment

Poiché le app basate su microservizi sono più piccole e modulari delle tradizionali applicazioni monolitiche, tutti i problemi associati a tali deployment vengono automaticamente eliminati. Benché questo approccio richieda un coordinamento superiore, per il quale può rivelarsi utile un livello di service mesh, i vantaggi che ne derivano sono determinanti.

Accessibilità

Poiché le app più grandi vengono suddivise in parti più piccole, per gli sviluppatori è molto più semplice comprendere, aggiornare e migliorare tali componenti, e questo permette di accelerare i cicli di sviluppo, soprattutto in combinazione con le metodologie di sviluppo agile, come DevOps.

Maggiore apertura

Grazie alle API poliglotte, gli sviluppatori sono liberi di scegliere il linguaggio e la tecnologia ottimali per la funzione da creare.

Potenziali problematiche dei microservizi

La flessibilità che caratterizza i microservizi può portare a un'accelerazione della distribuzione delle nuove modifiche, il che significa creare nuovi schemi. Nell'ingegneria del software, uno "schema" indica qualsiasi soluzione algoritmica nota come funzionante. Uno "schema da evitare" indica invece gli errori comuni compiuti con l'intento di risolvere un problema, che però ne creano altri nel lungo termine.

Oltre a queste, un'architettura basata su microservizi presenta due criticità principali: la complessità e la produttività. Quando si lavora con un'architettura di microservizi, è importante tenere conto degli schemi da evitare più comuni.

- Scalabilità: la possibilità di dimensionare qualsiasi funzione durante il processo di sviluppo del ciclo di vita software pone diverse sfide, soprattutto all'inizio. Durante la configurazione iniziale, è importante dedicare tempo a identificare le dipendenze tra servizi e i potenziali ostacoli capaci di creare incompatibilità con le versioni precedenti. Al momento della distribuzione, l'automazione è il miglior investimento, perché la complessità dei microservizi può renderli umanamente ingestibili.

- Registrazione: nei sistemi distribuiti, per ricollegare tutti i vari componenti sono necessari registri centralizzati, senza i quali gestirli in modo scalabile risulterebbe impossibile.

- Monitoraggio: è fondamentale per i team operativi avere una visibilità centralizzata del sistema, al fine di identificare l'origine dei problemi.

- Debugging: il debugging remoto tramite l'ambiente di sviluppo integrato (IDE) locale non è una scelta praticabile con decine o centinaia di servizi. Al momento non esiste un'unica soluzione legata al debugging.

- Connettività: occorre valutare quale metodo di rilevamento dei servizi scegliere, se centralizzato o integrato.

Strumenti e strategie per i microservizi

Container e Kubernetes

Un Kubernetes è una piattaforma di orchestrazione dei container che consente di aggiornare i singoli componenti di un'applicazione senza influenzare gli altri elementi dello stack tecnologico; è perfetta per automatizzare la gestione, la scalabilità e il deployment delle applicazioni di microservizi.

API

Un'interfaccia di programmazione delle applicazioni, o API, è il componente dell'applicazione responsabile di comunicare con le altre applicazioni. Nell'ambito dell'infrastruttura di un'architettura di microservizi, le API giocano il ruolo strategico che permette ai diversi servizi di un microservizio di condividere le informazioni, funzionando come se fossero un servizio solo.

Flusso di eventi

Un evento è qualsiasi cosa che accade in un servizio di microservizi, ad esempio l'aggiunta o la rimozione di un articolo da un carrello per acquisti online.

Gli eventi compongono flussi di eventi che riflettono il comportamento mutevole di un sistema. Il loro monitoraggio permette alle organizzazioni di comprendere il comportamento di dati e utenti in modo utile. L'elaborazione dei flussi di eventi permette di intraprendere azioni immediate e può essere utilizzata con i carichi di lavoro operativi in tempo reale. Viene ormai applicata a diversi aspetti, dall'analisi delle frodi alla manutenzione dei sistemi.

Serverless computing

Definiamo serverless computing un modello di sviluppo cloud native che permette agli sviluppatori di creare e gestire le applicazioni, mentre un provider cloud è responsabile del provisioning, della manutenzione e della scalabilità dell'infrastruttura del server. Gli sviluppatori devono semplicemente creare pacchetti di codice all'interno di container per il deployment. Il serverless computing aiuta le aziende ad accelerare l'innovazione, astraendo l'applicazione dall'infrastruttura alla base.

Il ruolo di Red Hat

Le soluzioni open source di Red Hat ti aiutano nella suddivisione delle tue applicazioni monolitiche in microservizi, nella loro gestione e orchestrazione, fino alla gestione dei dati che i microservizi creano.

Red Hat OpenShift

Red Hat® OpenShift® è una piattaforma Kubernetes che offre un metodo unificato per la connessione, la gestione e il monitoraggio delle applicazioni basate su microservizi. Supporta applicazioni containerizzate, in uso e cloud native, oltre a quelle in corso di refactoring per essere adattate ai microservizi. OpenShift si integra con Red Hat Application Services e può essere utilizzato con strumenti di automazione esistenti quali Git, Maven e Jenkins. È inoltre dotato di un sistema operativo Linux di livello aziendale, che assicura maggiore sicurezza all'intero cluster.

Che si stiano ottimizzando applicazioni già in uso, avviando una migrazione verso il cloud o realizzando soluzioni totalmente nuove basate sui microservizi, Red Hat OpenShift costituisce una piattaforma più sicura e stabile per tutta l'infrastruttura.

Red Hat Runtimes

Red Hat Runtimes è un insieme di raccolte di runtime preconfigurate e containerizzate che costituiscono le fondamenta dei microservizi. Supporta un gran numero di linguaggi e framework da utilizzare nella progettazione di architetture di microservizi quali Quarkus, Spring Boot, MicroProfile e Node.js. Inoltre, Red Hat Runtimes include servizi di supporto per l'accesso rapido ai dati con Red Hat Data Grid, e servizi per la protezione delle API dei microservizi con Red Hat Single-sign on.

Red Hat Integration

Red Hat Integration è un set completo di tecnologie di integrazione e messaggistica finalizzate a connettere le applicazioni e i dati sulle infrastrutture ibride. È una soluzione agile, distribuita, containerizzata e basata sulle API. Fornisce orchestrazione e creazione dei servizi, connettività delle applicazioni, trasformazione dei dati, messaggistica in tempo reale e gestione delle API, il tutto associato a una piattaforma cloud native e una toolchain per un supporto completo dello sviluppo applicativo moderno.

Gli sviluppatori possono sfruttare strumenti come i servizi con trascinamento della selezione e i pattern di integrazione incorporati per la creazione dei microservizi. Al contempo, gli utenti aziendali possono avvalersi degli strumenti web per sviluppare API capaci di integrare microservizi diversi.

Il blog ufficiale di Red Hat

Leggi gli articoli del blog di Red Hat per scoprire novità e consigli utili sulle nostre tecnologie, e avere aggiornamenti sul nostro ecosistema di clienti, partner e community.